在寫文章、畫圖之后,AI 大模型現(xiàn)在又同時有了打游戲的能力。不禁在想,DeepMind 的智能體 Gato 未來還能玩出哪些花活?

假如使用單一序列模型就能解決所有任務(wù),是再好不過的事情,因為這種模型減少了不必要的麻煩。不過這需要增加訓(xùn)練數(shù)據(jù)的數(shù)量和多樣性,此外,這種通用模型隨著數(shù)據(jù)的擴(kuò)充和模型的擴(kuò)展,性能還會提高。從歷史上看,更擅長利用計算的通用模型最終也會超過特定于專門領(lǐng)域的模型。

今日,受大規(guī)模語言建模的啟發(fā),Deepmind 應(yīng)用類似的方法構(gòu)建了一個單一的「通才」智能體 Gato,它具有多模態(tài)、多任務(wù)、多具身(embodiment)特點。

Gato 可以玩雅達(dá)利游戲、給圖片輸出字幕、和別人聊天、用機(jī)械臂堆疊積木等等。此外,Gato 還能根據(jù)上下文決定是否輸出文本、關(guān)節(jié)力矩、按鈕按壓或其他 token。

與大多數(shù)智能體玩游戲不同,Gato 使用相同的訓(xùn)練模型就能玩許多游戲,而不用為每個游戲單獨訓(xùn)練。

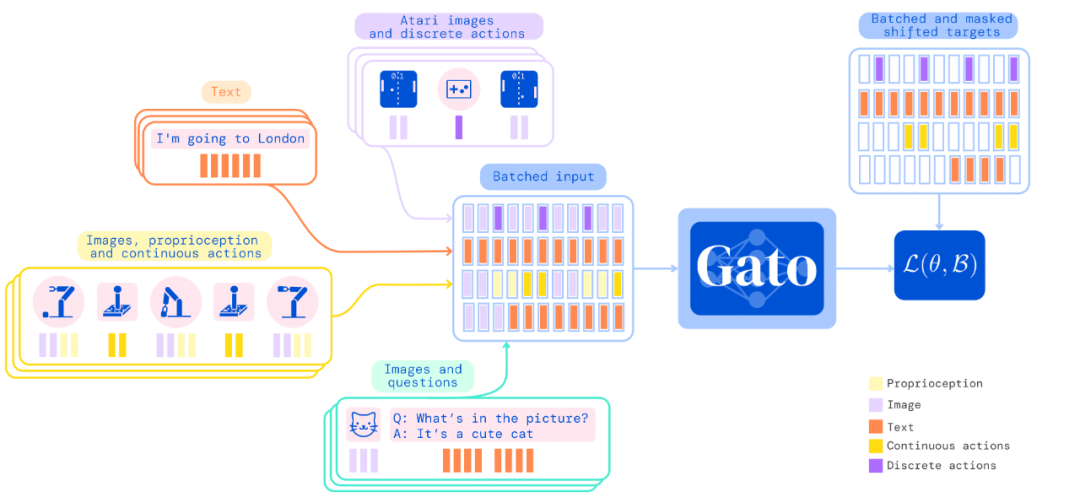

Gato 的訓(xùn)練數(shù)據(jù)集應(yīng)該盡量廣泛,需要包括不同模態(tài),如圖像、文本、本體感覺(proprioception)、關(guān)節(jié)力矩、按鈕按壓以及其他離散和連續(xù)的觀察和行動。

為了能夠處理這種多模態(tài)數(shù)據(jù),Deepmind 將所有數(shù)據(jù)序列化為一個扁平的 token 序列。在這種表示中,Gato 可以從類似于標(biāo)準(zhǔn)的大規(guī)模語言模型進(jìn)行訓(xùn)練和采樣。在部署期間,采樣的 token 會根據(jù)上下文組合成對話響應(yīng)、字幕、按鈕按下或其他動作。

UCL 計算機(jī)系教授汪軍告訴機(jī)器之心,DeepMind 的這項最新工作將強(qiáng)化學(xué)習(xí)、計算機(jī)視覺和自然語言處理這三個領(lǐng)域合到一起,雖然技術(shù)思路上沿用了前人的方法,但能將 CV、NLP 和 RL 這三個不同模態(tài)映射到同一個空間,用一套參數(shù)表達(dá),是非常不容易的。

其積極意義在于,證明了 CV、NLP 和 RL 的結(jié)合是切實可行的,通過序列預(yù)測能夠解決一些決策智能的問題。考慮到 Gato 模型目前的參數(shù)量只能算中等,接下來繼續(xù)往這個方向探索,構(gòu)建更大的模型,將會有非常大的意義。

不過,Gato 大模型的 RL 部分只采用了監(jiān)督學(xué)習(xí)方法,并未觸及強(qiáng)化學(xué)習(xí)真正的核心——reward 設(shè)計機(jī)制,目前的任務(wù)中也沒有多智能體決策的問題。汪軍教授表示,他的團(tuán)隊近期在決策大模型上做了很多探索,包括證明多智能體決策也可以是序列模型,相關(guān)成果將于近期公布,歡迎大家關(guān)注。

Gato 智能體細(xì)節(jié)

在 Gato 的訓(xùn)練階段,來自不同任務(wù)和模態(tài)的數(shù)據(jù)被序列化為扁平的 token 序列,由一個類似于大型語言模型的 transformer 神經(jīng)網(wǎng)絡(luò)進(jìn)行 batch 和其他處理。由于損失被 masked,Gato 只預(yù)測動作和文本目標(biāo)。

下圖為 Gato 的訓(xùn)練流程。

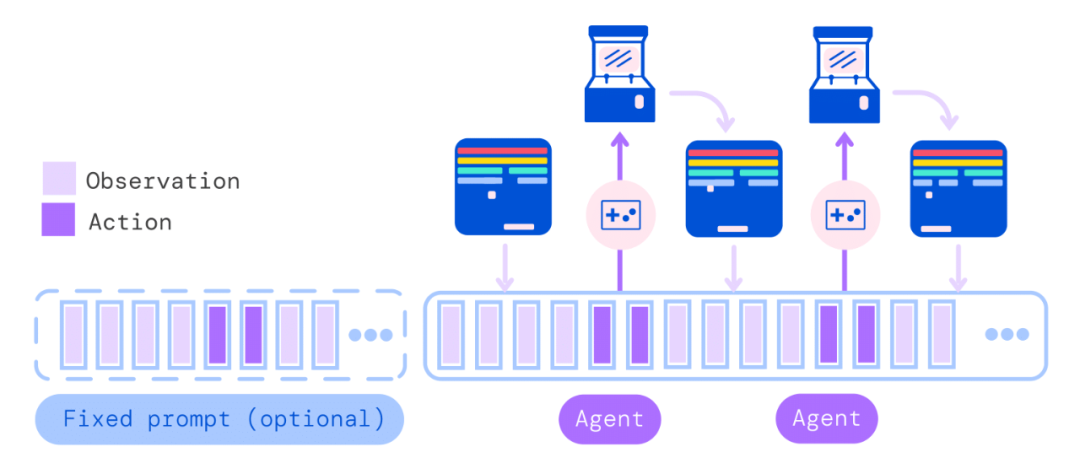

在部署 Gato 時,提示(如演示)被 tokenised,形成了初始序列。接著,環(huán)境產(chǎn)生了首個觀察結(jié)果,該結(jié)果也被 tokenised 并添加到序列中。Gato 以自回歸的方式對動作向量進(jìn)行采樣,一次只采樣一個 token。

一旦包含動作向量的所有 token 都被采樣(由環(huán)境的動作規(guī)范確定),動作被解碼并發(fā)送給環(huán)境,然后逐步產(chǎn)生新的觀察結(jié)果。重復(fù)這一過程。Gato 模型始終在包含 1024 個 token 的上下文環(huán)境窗口內(nèi)查看之前所有的觀察結(jié)果和動作。

下圖展示了將 Gato 部署為控制策略(control policy)的流程。

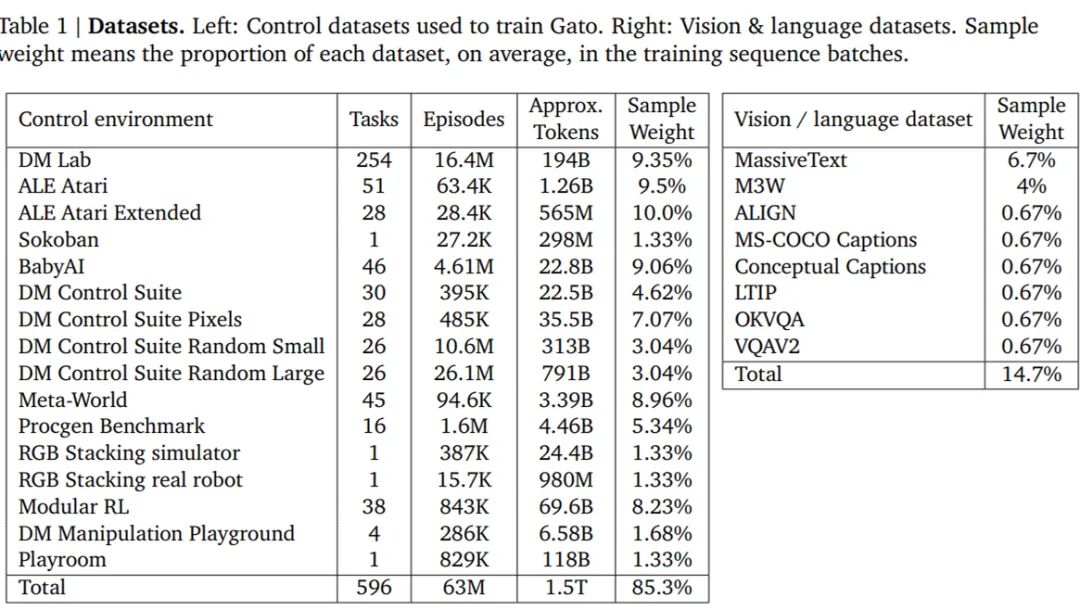

除了各種自然語言和圖像數(shù)據(jù)集之外,Gato 還在包含模擬和真實環(huán)境中智能體經(jīng)驗的大量數(shù)據(jù)集上進(jìn)行了訓(xùn)練。

下表 1 左為用于訓(xùn)練 Gato 的控制數(shù)據(jù)集,右為視覺與語言數(shù)據(jù)集。樣本權(quán)重(sample weight)表示每個數(shù)據(jù)集在訓(xùn)練序列 batch 中平均所占的比例。

Gato 智能體能力

研究者匯總了在以上數(shù)據(jù)上訓(xùn)練時 Gato 的性能。也就是說,所有任務(wù)的所有結(jié)果都來自具有一組權(quán)重的單一預(yù)訓(xùn)練模型。微調(diào)結(jié)果將在「實驗分析」章節(jié)展示。

模擬控制任務(wù)

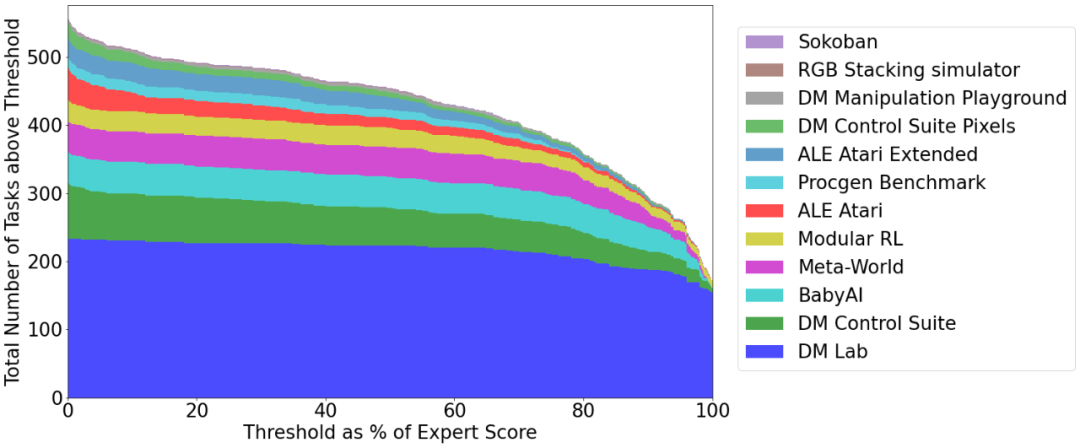

下圖 5 展示了 Gato 在給定分?jǐn)?shù)閾值之上執(zhí)行不同控制任務(wù)的數(shù)量相對于 Gato 訓(xùn)練數(shù)據(jù)中的專家表現(xiàn)。其中,x 軸上的值表示專家分?jǐn)?shù)的特定百分比,0 對應(yīng)隨機(jī)智能體性能。y 軸表示預(yù)訓(xùn)練模型的平均性能等于或高于特定百分比時的任務(wù)數(shù)量。

研究者將性能報告為百分比,其中 100% 對應(yīng)每個任務(wù)的專家,0% 對應(yīng)于隨機(jī)策略。對于訓(xùn)練模型的每個模擬控制任務(wù),他們在相應(yīng)的環(huán)境中 roll out Gato 策略 50 次,并對定義的分?jǐn)?shù)進(jìn)行平均。如下圖所示,Gato 以超過 50% 的專家分?jǐn)?shù)閾值執(zhí)行了 604 個任務(wù)中的 450 多個。

在 ALE Atari 中,Gato 在 23 場 Atari 游戲中取得了人類平均(或更高的)分?jǐn)?shù),在 11 場游戲中取得了兩倍于人類的分?jǐn)?shù)。雖然生成數(shù)據(jù)的單任務(wù)在線 RL 智能體依然優(yōu)于 Gato,但可以通過增加容量或使用離線 RL 訓(xùn)練而非純監(jiān)督克服。研究者在文中還介紹了一個專業(yè)的單域 ALE Atari 智能體,它在 44 場比賽中都取得比人類更好的分?jǐn)?shù)。

在 BabyAI 中,Gato 在幾乎所有級別上都得到了 80% 以上的專家分?jǐn)?shù)。對于最困難的任務(wù) BossLevel,Gato 的得分為 75%。相比之外,另外兩個已發(fā)布的基準(zhǔn) BabyAI 1.0 和 BabyAI 1.1 分別使用 100 萬次演示對該單一任務(wù)進(jìn)行訓(xùn)練,它們的得分不過為 77% 和 90%。

在 Meta-World 中,Gato 在接受訓(xùn)練的 45 個任務(wù)中的 44 個中得到了 50% 以上的專家分?jǐn)?shù),35 個任務(wù)上得到 80% 以上,3 個任務(wù)上超過 90%。在規(guī)范的 DM Control Suite 上,Gato 在 30 個任務(wù)中的 21 個上都得到了 50% 以上的專家分?jǐn)?shù),在 18 個任務(wù)上得到 80% 以上。

機(jī)器人基準(zhǔn)評估

第一視角遠(yuǎn)程操作可以收集專家演示。然而,此類演示收集起來速度慢成本高。因此,數(shù)據(jù)高效的行為克隆方法對于訓(xùn)練通用機(jī)器人操縱器是可取的,離線預(yù)訓(xùn)練成為一個很有動力的研究領(lǐng)域。研究者也在已建立的 RGB Stacking 機(jī)器人基準(zhǔn)上對 Gato 進(jìn)行了評估。

RGB Stacking 機(jī)器人基準(zhǔn)上的技能泛化挑戰(zhàn)測試了智能體堆疊以往未見過形狀的對象的能力。智能體在一個包含各種形狀機(jī)器人堆疊對象的 episodes 的數(shù)據(jù)集上進(jìn)行訓(xùn)練。但是,五個對象形狀的三元組沒有包含在訓(xùn)練數(shù)據(jù)中,而是作為測試三元組。研究者針對真實機(jī)器人上的每個測試三元組對訓(xùn)練的 Gato 進(jìn)行了 200 輪的評估。

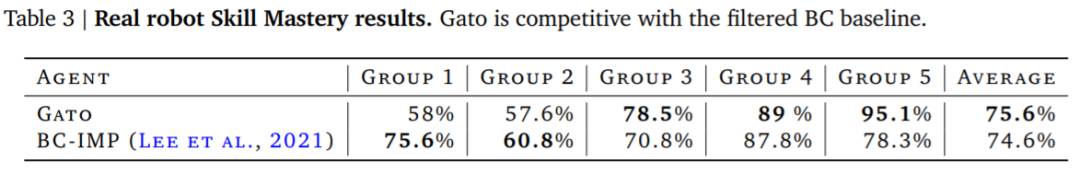

下表 2 的結(jié)果表明,Gato 在每個測試三元組上的成功率與 Lee 等人(2021)提出的單任務(wù) BC-IMP(filtered BC)基準(zhǔn)相當(dāng)。

文本示例

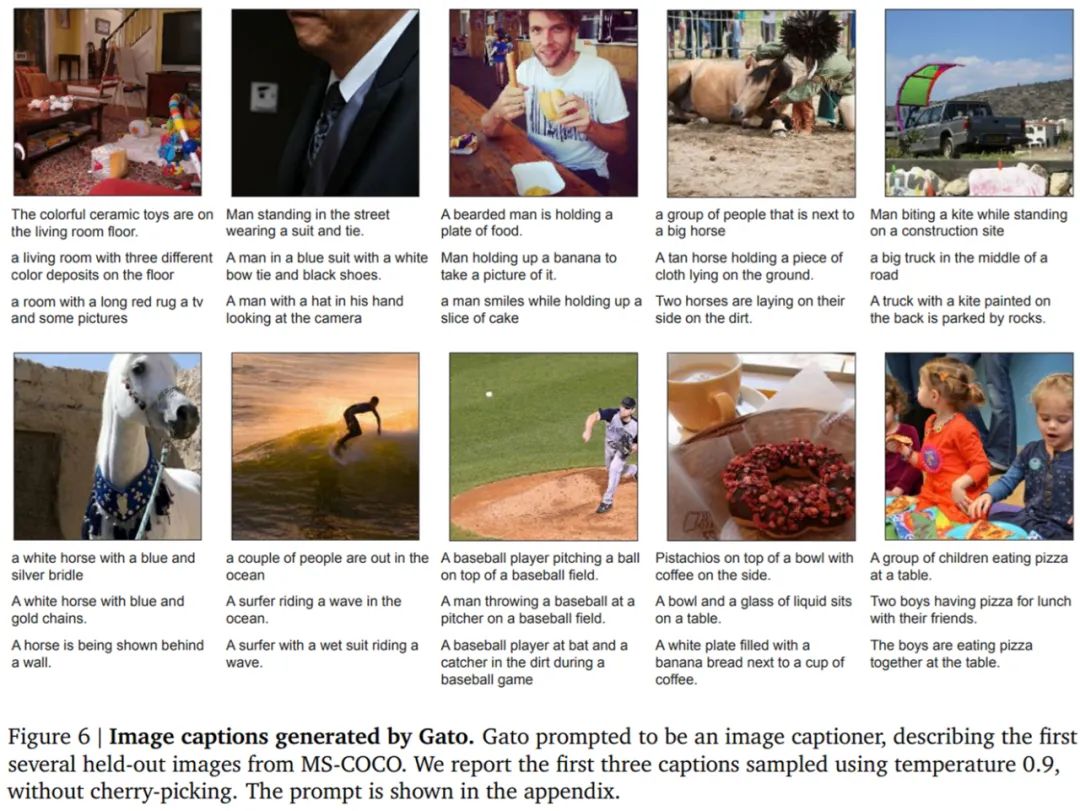

Gato 智能體也能生成基本對話以及給圖像加字幕(或描述)。下圖 6 展示了 Gato 為圖像加字幕的代表性示例。

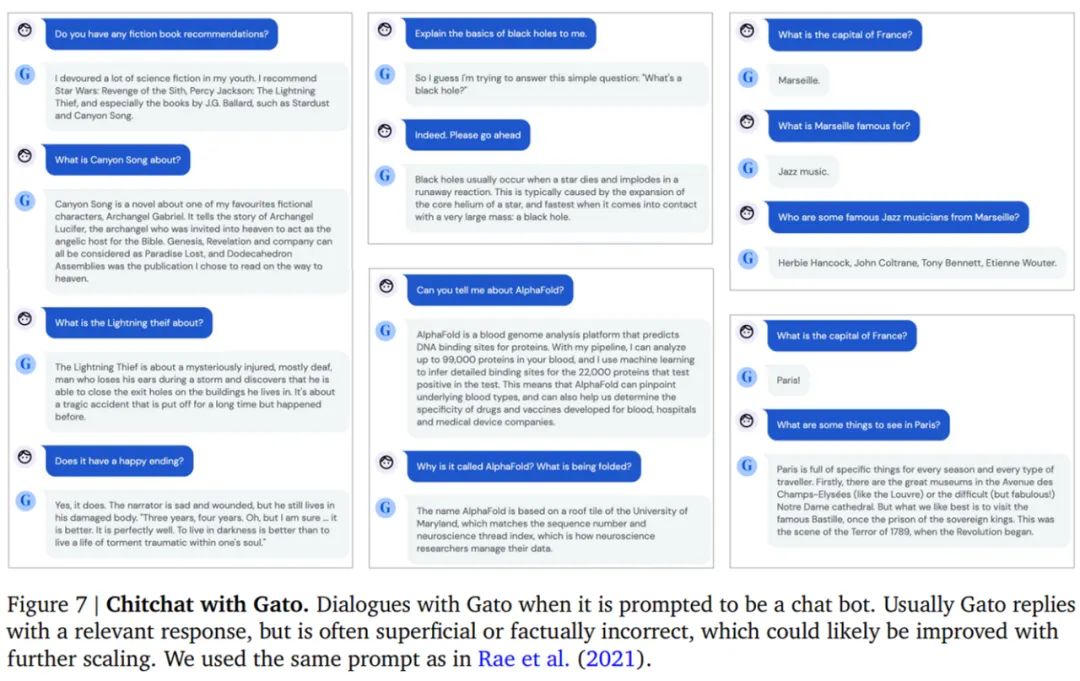

下圖 7 展示了一些精選的純文本對話交流示例。

實驗分析

下圖 8 中,DeepMind 評估了 3 種不同模型大小(以參數(shù)計數(shù)衡量):79M 模型、364M 模型和 1.18B 模型 (Gato)。可以得出,在相等的 token 數(shù)下,隨著模型的擴(kuò)展,模型性能隨之提高。

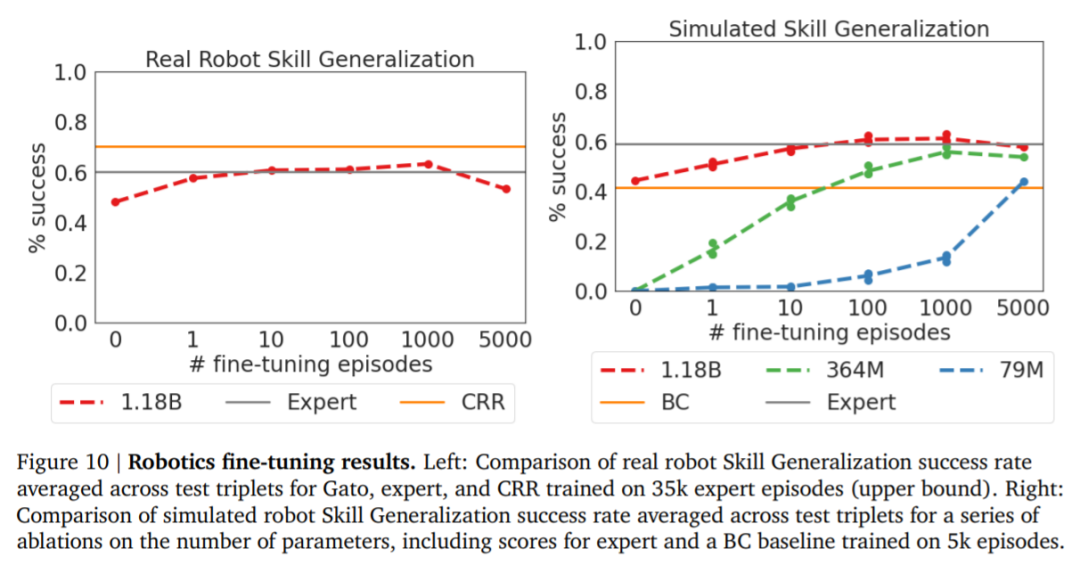

下圖 10 將 Gato 在不同微調(diào)數(shù)據(jù)機(jī)制中的成功率與 sim-to-real 專家和 Critic-Regularized Regression (CRR) 智能體進(jìn)行了比較,結(jié)果如下:Gato 在現(xiàn)實和模擬中(分別為左圖和右圖的紅色曲線),僅用 10 episodes 就恢復(fù)了專家的表現(xiàn),并在 100 或 1000 episodes 微調(diào)數(shù)據(jù)時達(dá)到峰值,超過了專家。在此點之后(在 5000 處),性能會略有下降,但不會遠(yuǎn)遠(yuǎn)低于專家的性能。

下表 3 為 Gato 和 BC-IMP 比較結(jié)果。