11月5日消息,騰訊今日宣布推出業(yè)界參數(shù)規(guī)模最大、效果最好的開源MoE大語言模型Hunyuan-Large。

Huanyuan-large模型的總參數(shù)量為389B、激活參數(shù)為52B、訓(xùn)練token數(shù)量為7T、最大上下文長度為256K、詞表大小為12.8w。

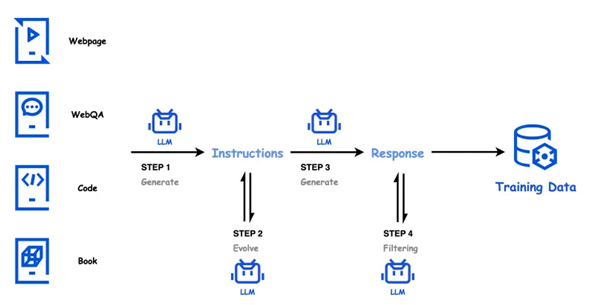

在技術(shù)創(chuàng)新方面,Hunyuan-large通過高質(zhì)量的合成數(shù)據(jù)來增強(qiáng)模型訓(xùn)練,彌補(bǔ)了自然數(shù)據(jù)的不足。

其中,該模型預(yù)訓(xùn)練支持處理高達(dá)256K的文本序列,大幅提升了長文本上下文的處理能力,能夠更高效地完成長文本任務(wù)。

據(jù)了解,Hunyuan-large在CMMLU、MMLU、CEva1、MATH等多學(xué)科綜合評測集上表現(xiàn)優(yōu)異,在中英文自然語言處理、代碼生成、數(shù)學(xué)運(yùn)算等9大能力維度中全面領(lǐng)先,超越了Llama3.1和Mixtral等一流開源模型。

此外,騰訊還宣布將推出自研的長文評測集“企鵝卷軸(PenguinScrolls)”,以填補(bǔ)行業(yè)在真實長文評測集上的空白。

企鵝卷軸基于公開的金融、法律、學(xué)術(shù)論文等長文本構(gòu)建,文本長度從1K到128K不等,覆蓋深度閱讀理解和長文推理任務(wù)。

本站內(nèi)容除特別聲明的原創(chuàng)文章之外,轉(zhuǎn)載內(nèi)容只為傳遞更多信息,并不代表本網(wǎng)站贊同其觀點(diǎn)。轉(zhuǎn)載的所有的文章、圖片、音/視頻文件等資料的版權(quán)歸版權(quán)所有權(quán)人所有。本站采用的非本站原創(chuàng)文章及圖片等內(nèi)容無法一一聯(lián)系確認(rèn)版權(quán)者。如涉及作品內(nèi)容、版權(quán)和其它問題,請及時通過電子郵件或電話通知我們,以便迅速采取適當(dāng)措施,避免給雙方造成不必要的經(jīng)濟(jì)損失。聯(lián)系電話:010-82306118;郵箱:[email protected]。