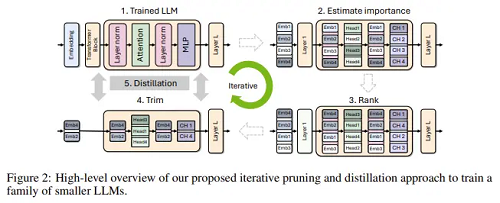

7月25日訊,據(jù) huggingface 頁面顯示,英偉達官方推出一款小語言模型Minitron,包含4B和8B兩個參數(shù)版本。

據(jù)悉,Minitron在保持相當(dāng)性能水平的同時,將模型大小縮小了 2-4 倍。具體來說,使用這種方法,從 15B 模型衍生出的 8B 和 4B 模型所需的訓(xùn)練代幣比從頭開始訓(xùn)練少 40 倍。這使得訓(xùn)練整個模型系列(15B、8B 和 4B)的計算成本節(jié)省了 1.8 倍。

Minitron 模型系列現(xiàn)已在 Huggingface 上開源供公眾使用。

本站內(nèi)容除特別聲明的原創(chuàng)文章之外,轉(zhuǎn)載內(nèi)容只為傳遞更多信息,并不代表本網(wǎng)站贊同其觀點。轉(zhuǎn)載的所有的文章、圖片、音/視頻文件等資料的版權(quán)歸版權(quán)所有權(quán)人所有。本站采用的非本站原創(chuàng)文章及圖片等內(nèi)容無法一一聯(lián)系確認(rèn)版權(quán)者。如涉及作品內(nèi)容、版權(quán)和其它問題,請及時通過電子郵件或電話通知我們,以便迅速采取適當(dāng)措施,避免給雙方造成不必要的經(jīng)濟損失。聯(lián)系電話:010-82306118;郵箱:[email protected]。