近期,國(guó)內(nèi)多個(gè)大模型企業(yè)陸續(xù)下調(diào)相關(guān)產(chǎn)品價(jià)格。

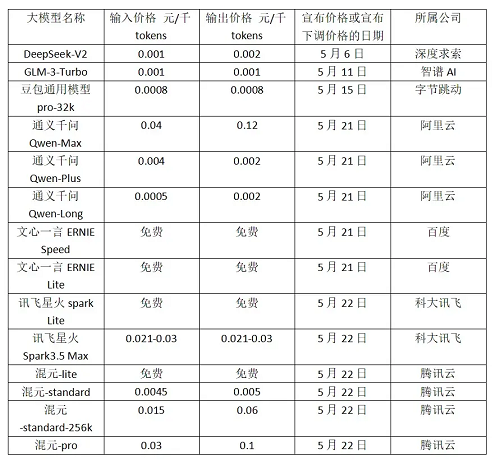

五月初開(kāi)始,9家發(fā)布新內(nèi)容的國(guó)內(nèi)大模型企業(yè)中,有7家宣布降價(jià)。其中包括:深度求索、智譜AI、字節(jié)跳動(dòng)、阿里云、百度、科大訊飛、騰訊云這7家企業(yè),共涉及21款模型。甚至于有大廠打出“免費(fèi)模式”的旗號(hào)。

01

5月6日,知名私募巨頭幻方量化創(chuàng)立的深度求索對(duì)外發(fā)布第二代MoE模型DeepSeek-V2。MoE模型即混合專(zhuān)家模型,將復(fù)雜任務(wù)拆解為子任務(wù),分別交由合適的“專(zhuān)家”模型處理,提高準(zhǔn)確性和推理效率。模型迭代的同時(shí),深度求索把API調(diào)用的定價(jià)降到每百萬(wàn)tokens輸入1元、輸出2元,價(jià)格僅為GPT-4-Turbo的近百分之一。

5 月 11 日,智譜 AI 跟進(jìn),宣布將其 GLM-3 Turbo 模型的調(diào)用價(jià)格下調(diào) 80%。從 5 元/百萬(wàn) tokens 降至 1 元/百萬(wàn) tokens。1 元可以購(gòu)買(mǎi) 100 萬(wàn) tokens。

5 月 15 日,字節(jié)的豆包大模型正式對(duì)外開(kāi)放,放出了較業(yè)內(nèi)極低的價(jià)格,價(jià)格單位直接從“元”變?yōu)椤袄濉薄6拱竽P图易灏拱ㄓ媚P?PRO 版和 lite 版兩款通用模型,其中,豆包通用模型 pro-32k 版,推理輸入價(jià)格 0.0008 元/千 tokens,較行業(yè)價(jià)格低 99.3%。lite 版為 0.0003 元/千 tokens。

隨后在5月21日,阿里云也發(fā)布降價(jià)通知,通義9款主力大模型大幅降價(jià)。其中,通義千問(wèn)GPT-4級(jí)主力模型Qwen-Long 的 API輸入價(jià)格直降97%至0.0005元/千tokens,1塊錢(qián)可以買(mǎi)200萬(wàn)tokens,相當(dāng)于5本《新華字典》的文字量。

當(dāng)日,百度甚至宣布文心大模型的兩款主力模型ENIRE Speed、ENIRE Lite全面免費(fèi)。科大訊飛也在22日宣布訊飛星火 Lite 版 API 永久免費(fèi)開(kāi)放,訊飛星火 Pro/Max API 價(jià)格降至 0.21 元/萬(wàn) tokens。此外,22日騰訊也公布了全新的大模型升級(jí)方案。騰訊的主力模型之一混元-lite 模型,API 輸入輸出總長(zhǎng)度計(jì)劃從目前的 4k 升級(jí)到 256k,價(jià)格從 0.008 元/千 tokens 調(diào)整為全面免費(fèi)。

在AI領(lǐng)域的激烈角逐中,大模型正逐步走向價(jià)格戰(zhàn)的漩渦。那么,推動(dòng)這一變革的深層原因是什么?而它又將如何深遠(yuǎn)地影響整個(gè)行業(yè)生態(tài)?

02

降價(jià)的本質(zhì)為何?

價(jià)格戰(zhàn)有利于巨頭搶占市場(chǎng)

當(dāng)前的行業(yè)價(jià)格戰(zhàn),可以看做是“百模大戰(zhàn)”帶來(lái)的一個(gè)衍生結(jié)果。大模型狂熱之時(shí),幾乎每隔一天就有一個(gè)大模型“蹦出來(lái)”。截至2023年11月30日,國(guó)內(nèi)已經(jīng)有至少200家大模型廠商推出了各自的大模型。

當(dāng)下的大模型競(jìng)爭(zhēng)早已超過(guò)了技術(shù)的范疇,更多是一種生態(tài)層面的比拼,具體表現(xiàn)在有多少應(yīng)用、有多少插件、有多少開(kāi)發(fā)者以及用戶(hù)等。

要知道,當(dāng)前的大模型市場(chǎng),空間相當(dāng)有限,大部分的大模型APP都已經(jīng)開(kāi)始面臨用戶(hù)增長(zhǎng)乏力的困境,包括備受矚目的OpenAI。因此降價(jià)便是這些大廠獲得更多市場(chǎng)的方式之一。

此外,從價(jià)格角度來(lái)看,一些初創(chuàng)公司的價(jià)格本身就較低。因此,針對(duì)當(dāng)下的科技巨頭紛紛降價(jià),那些AI創(chuàng)業(yè)公司大都沒(méi)有選擇跟進(jìn)。一些參與AI大模型投資的投資人表示,“這波降價(jià)對(duì)一些創(chuàng)業(yè)公司TO B模式影響較大。”因?yàn)檫^(guò)去很多公司,之所以選擇跟初創(chuàng)公司合作,主要就是看重初創(chuàng)公司的API比大廠要便宜,但現(xiàn)在基本上沒(méi)有任何比大廠便宜的可能性了,這意味著創(chuàng)業(yè)公司的B端商業(yè)化模式不復(fù)存在了。

對(duì)于這些初創(chuàng)公司來(lái)說(shuō),倘若找不到新的出路,或許就會(huì)面臨生死考驗(yàn)。

入門(mén)級(jí)、輕量級(jí)的文本大模型的能力差距不顯著

半導(dǎo)體產(chǎn)業(yè)縱橫觀察發(fā)現(xiàn),在這波降價(jià)潮中降價(jià)的模型主要為入門(mén)級(jí)、輕量級(jí)的文本大模型,而高性能及圖像識(shí)別、語(yǔ)音識(shí)別等垂類(lèi)的多模態(tài)模型并沒(méi)有調(diào)整價(jià)格。

而這些入門(mén)級(jí)、輕量級(jí)的文本大模型技術(shù)和能力等各方面已經(jīng)趨同,各廠商之間的技術(shù)壁壘并不顯著,因此價(jià)格競(jìng)爭(zhēng)成為了它們之間主要的競(jìng)爭(zhēng)手段。

根據(jù)上海人工智能實(shí)驗(yàn)室發(fā)布的大模型開(kāi)源開(kāi)放評(píng)測(cè)體系司南(OpenCompass2.0)顯示,復(fù)雜推理相關(guān)能力是大模型普遍面臨的難題,國(guó)內(nèi)大模型相比于GPT-4還存在差距,這是大模型在金融、工業(yè)等要求可靠的場(chǎng)景落地需要的關(guān)鍵能力。不過(guò),在中文場(chǎng)景下國(guó)內(nèi)最新的大模型已展現(xiàn)出獨(dú)特優(yōu)勢(shì),尤其在語(yǔ)言、知識(shí)維度上接近GPT-4 Turbo的水平。

大模型的邊際收益正在持續(xù)走低

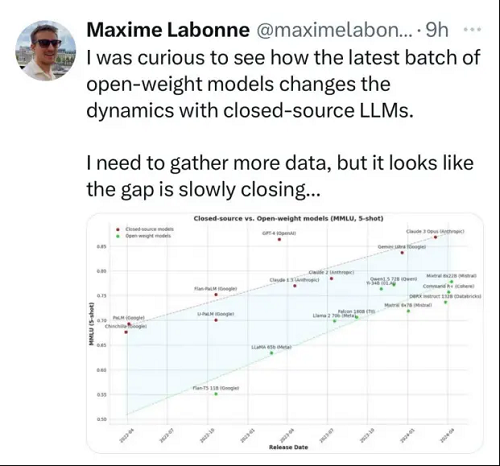

Gary Marcus 博士在“Evidence that LLMs are reaching a point of diminishing returns — and what that might mean”《LLMs正達(dá)到收益遞減的證據(jù)——及其可能意味著什么》一文中提到,從GPT-2到GPT-4甚至GPT-4 Turbo的性能變化,已經(jīng)出現(xiàn)了性能遞減的跡象。

Gary Marcus 博士表示:“自GPT-4發(fā)布以來(lái),多個(gè)模型在GPT-4水平性能上都有著巨大的收斂,然而并沒(méi)有明顯領(lǐng)先的模型。”

在收益遞減的背景下,意味著處理相同的任務(wù),開(kāi)發(fā)者的實(shí)際成本是在上升的。在AI創(chuàng)新商業(yè)化前景還不明朗的市場(chǎng)環(huán)境下,為了保住現(xiàn)有用戶(hù),大模型廠商必須給出有吸引力的對(duì)策。包括提供更小的模型,比如谷歌推出的Gemini 1.5 Flash。另一個(gè)手段就是直接降價(jià)。

03

投入高昂,多芯混合或有助力

人工智能的核心是算力,算力需求主要分為兩部分,包括訓(xùn)練算力和推理算力。

目前來(lái)說(shuō)對(duì)訓(xùn)練算力需求非常高,根據(jù)去年的一則數(shù)據(jù)顯示,ChatGPT的公開(kāi)數(shù)據(jù)顯示它的整個(gè)訓(xùn)練算力消耗非常大,達(dá)到了3640PF-days。換算成英偉達(dá)A100芯片,它單卡算力相當(dāng)于0.6P的算力,理想情況下總共需要大概6000張,在考慮互聯(lián)損失的情況下,需要一萬(wàn)張A100作為算力基礎(chǔ)。在A100芯片10萬(wàn)人民幣/張的情況下,算力的硬件投資規(guī)模達(dá)到10億人民幣。推理算力主要是英偉達(dá)T4卡,推理成本大約相當(dāng)于訓(xùn)練成本的三分之一。

除了算力的成本,還有隨之而來(lái)的存儲(chǔ)、推理、運(yùn)維、應(yīng)用等一系列成本。??

那么如何解決絕大多數(shù)企業(yè)當(dāng)下最關(guān)心的“降本增效”問(wèn)題?除了對(duì)模型的優(yōu)化,硬件層面的創(chuàng)新思路亦不容忽視。近期,業(yè)界不少專(zhuān)家和技術(shù)人員開(kāi)始聚焦于多芯混合的概念,嘗試通過(guò)這一策略來(lái)為企業(yè)帶來(lái)更高的性能和更低的成本。

那么到底什么是多芯混合?它又如何在AI大模型算力緊缺的當(dāng)下提供更優(yōu)的解決方案。

多芯混合主要涉及在硬件設(shè)計(jì)或應(yīng)用中,結(jié)合使用不同類(lèi)型、不同功能或不同制程架構(gòu)的芯片,以形成一個(gè)混合的計(jì)算系統(tǒng)或解決方案。上文提到當(dāng)前基礎(chǔ)大模型訓(xùn)練所需要的最大 AI 算力集群規(guī)模,已經(jīng)從單一集群千卡逐步提升至萬(wàn)卡量級(jí)。同時(shí),很多智算中心已經(jīng)部署的 GPU 集群,通常是十幾臺(tái)至數(shù)百臺(tái)服務(wù)器不等,難以滿(mǎn)足未來(lái)行業(yè)大模型訓(xùn)練的需求。

所以,在已有 AI 算力集群的基礎(chǔ)上,構(gòu)建由昆侖芯、昇騰等不同芯片混合組成的單一集群,為大模型訓(xùn)練提供更大 AI 算力,成為了一個(gè)自然的選擇。

多芯混合有哪些優(yōu)勢(shì)?

第一,通過(guò)將計(jì)算任務(wù)分配到多個(gè)GPU上,可以顯著加速模型的訓(xùn)練速度。多GPU并行訓(xùn)練還可以減少單GPU訓(xùn)練中由于計(jì)算瓶頸導(dǎo)致的時(shí)間浪費(fèi),從而提高了訓(xùn)練效率。

第二,多GPU訓(xùn)練可以同時(shí)處理更多的數(shù)據(jù),從而提高了內(nèi)存利用率。

第三,這種混合集群的構(gòu)建能夠有效降低成本。畢竟,與英偉達(dá)的A100/H100系列GPU相比,其他品牌的GPU價(jià)格更為親民。

然而,若此方案真如我們想象中那般易于實(shí)施,那么它早已被業(yè)界的諸多巨頭所采納。具體看看,這一方案的實(shí)施都存在哪些難點(diǎn)?

04

多芯混合要解決哪些問(wèn)題?

為了建設(shè)一個(gè)能夠高效訓(xùn)練大模型的集群,需要在卡間和機(jī)間建立高效的互聯(lián)互通,將大模型訓(xùn)練任務(wù)按照合適的并行策略拆分到GPU卡中,最后通過(guò)各種優(yōu)化方法,加速GPU對(duì)算子的計(jì)算效率,完成大模型訓(xùn)練。

然而,不同芯片之間很難互聯(lián)互通,因?yàn)橛ミ_(dá)GPU、昆侖芯、昇騰 910B 的物理連接方式,并行策略以及AI加速套件上都不一樣。

首先,在互聯(lián)互通上,單臺(tái)服務(wù)器內(nèi)的 8 塊 GPU 卡通過(guò) NVLink 連接。不同服務(wù)器之間的 GPU 卡通過(guò) RDMA 網(wǎng)絡(luò)連接。

過(guò)去,我們看到了很多有關(guān)英偉達(dá)GPU和CUDA護(hù)城河的介紹。誠(chéng)然,經(jīng)過(guò)多年的投入,他們已經(jīng)建立起了難以逾越的優(yōu)勢(shì)。但除此以外,如上所述,英偉達(dá)還有很多隱形護(hù)城河,NVLink就是其中的一個(gè),一個(gè)為GPU到GPU互聯(lián)提供高速連接的技術(shù)。

在摩爾定律逐漸失效,但對(duì)算力要求越來(lái)越高的當(dāng)下,這種互聯(lián)顯得尤為必要。

英偉達(dá)官網(wǎng)表示,NVLink 是全球首創(chuàng)的高速GPU 互連技術(shù),為多GPU 系統(tǒng)提供另一種選擇,與傳統(tǒng)的PCI-E 解決方案相比,速度方面擁有顯著提升。使用NVLink 連接兩張英偉達(dá)GPU,即可彈性調(diào)整存儲(chǔ)器與效能,滿(mǎn)足專(zhuān)業(yè)視覺(jué)運(yùn)算最高工作負(fù)載的需求。

而昆侖芯服務(wù)器內(nèi)部通過(guò) XPU Link 進(jìn)行連接,服務(wù)器之間通過(guò)標(biāo)準(zhǔn)的 RDMA 網(wǎng)卡進(jìn)行連接,卡和卡之間使用 XCCL 通信庫(kù)進(jìn)行相互通信。昇騰 910B 服務(wù)器內(nèi)部通過(guò) HCCS 進(jìn)行連接,服務(wù)器之間通過(guò)華為自研的內(nèi)置 RDMA 進(jìn)行連接,卡和卡之間使用 HCCL 通信庫(kù)進(jìn)行相互通信。

其次,在并行策略上,英偉達(dá)GPU 和昆侖芯采用單機(jī) 8 卡的部署方式,昇騰 910B 則是機(jī)內(nèi) 16 卡分為 2 個(gè) 8 卡通信組 。這意味著在 AI 框架下形成不同的集群拓?fù)洌枰嗅槍?duì)性地制定分布式并行策略。

最后,在 AI 加速套件上,由于昆侖芯、昇騰等芯片在計(jì)算能力,顯存大小,I/O 吞吐,通信庫(kù)等均存在差異,故需要面向具體芯片進(jìn)行特定優(yōu)化。最后的結(jié)果,就是每一種芯片,有一個(gè)各自對(duì)應(yīng)的算子庫(kù),以及相應(yīng)的加速策略。

05

哪些廠商開(kāi)始試水?

值得注意的是,近日,AMD、博通、思科、谷歌、惠普企業(yè) (HPE)、英特爾、Meta 和微軟等領(lǐng)先科技公司組成的聯(lián)盟宣布成立超級(jí)加速器鏈路 (UALink) 促進(jìn)會(huì)。該計(jì)劃旨在制定一項(xiàng)開(kāi)放的行業(yè)標(biāo)準(zhǔn),以促進(jìn)數(shù)據(jù)中心 AI 系統(tǒng)的高速、低延遲通信。

面對(duì)日益增長(zhǎng)的 AI 工作負(fù)載,這些科技巨頭均迫切需要超高性能互連。

百度也在打造多芯混合訓(xùn)練AI集群。百度百舸的多芯混合訓(xùn)練方案,屏蔽了底層復(fù)雜的異構(gòu)環(huán)境,將各類(lèi)芯片融合成為了一個(gè)大集群,可以實(shí)現(xiàn)存量不同算力的統(tǒng)一,整合發(fā)揮這些算力的最大效能,支持更大模型訓(xùn)練任務(wù)。同時(shí),支持新增資源的快速融入,滿(mǎn)足未來(lái)業(yè)務(wù)增長(zhǎng)的需要。該方案不僅通過(guò)百度智能云的公有云提供服務(wù),同時(shí)還可以通過(guò)ABC Stack專(zhuān)有云進(jìn)行交付。

此前,百度集團(tuán)執(zhí)行副總裁、百度智能云事業(yè)群總裁沈抖表示,在“一云多芯”方面,百度百舸兼容昆侖芯、昇騰、海光DCU、英偉達(dá)、英特爾等國(guó)內(nèi)外主流AI芯片,支持同一智算集群中混合使用不同廠商芯片,最大程度上屏蔽硬件之間差異,幫助企業(yè)擺脫單一芯片依賴(lài),打造更有性?xún)r(jià)比、更安全、更具彈性的供應(yīng)鏈體系。在多芯混合訓(xùn)練任務(wù)中,百舸能夠?qū)涡酒寐省⑿酒g通信效率、集群整體效能發(fā)揮到極致,百卡規(guī)模性能損失不超過(guò)3%,千卡規(guī)模性能損失不超過(guò)5%,均為國(guó)內(nèi)最高水平。

近日,F(xiàn)lagScale 開(kāi)源大模型并行訓(xùn)練框架全面升級(jí)。智源團(tuán)隊(duì)與天數(shù)智芯團(tuán)隊(duì)合作,實(shí)現(xiàn)了“英偉達(dá)芯片+其它AI芯片”集群上單一大模型任務(wù)的異構(gòu)混合訓(xùn)練,并在70B大模型上驗(yàn)證了不同架構(gòu)芯片上進(jìn)行異構(gòu)混合訓(xùn)練的有效性。同時(shí),為了加速多種AI芯片在大模型訓(xùn)練場(chǎng)景的使用,智源積極探索高效靈活的芯片適配方案,通過(guò)與硬件廠商的深入合作,F(xiàn)lagScale 已在6家不同廠商的多款A(yù)I芯片上適配Aquila2系列大模型的大規(guī)模訓(xùn)練。

由于不同廠商的卡間互聯(lián)協(xié)議不同,為了實(shí)現(xiàn)“英偉達(dá)芯片+其它AI芯片”高速互聯(lián),智源團(tuán)隊(duì)與天數(shù)智芯協(xié)作,優(yōu)化天數(shù)智芯的iXCCL通信庫(kù),使其在通信原語(yǔ)操作上以及API接口上兼容英偉達(dá)NCCL,然后將框架編譯鏈接到同一iXCCL通信庫(kù)上,從而在用戶(hù)和AI框架無(wú)感知的情況下實(shí)現(xiàn)異構(gòu)算力芯片間高效通信,進(jìn)而實(shí)現(xiàn)不同架構(gòu)芯片混合訓(xùn)練。同時(shí),雙方還協(xié)作優(yōu)化了流水線(xiàn)并行的分配方式,并針對(duì)不同芯片算力、內(nèi)存帶寬、內(nèi)存容量的差異來(lái)為不同芯片配置不同的流水線(xiàn)并行策略,以使得訓(xùn)練過(guò)程中能充分發(fā)揮不同芯片的性能,最終率先實(shí)現(xiàn)了通用GPU異構(gòu)大模型高效訓(xùn)練方案。

06

國(guó)產(chǎn)GPU廠商的機(jī)遇

多芯混合技術(shù)允許將不同架構(gòu)、不同功能的芯片集成在一個(gè)系統(tǒng)中,這為國(guó)產(chǎn)廠商提供了技術(shù)創(chuàng)新的機(jī)會(huì)。通過(guò)整合和優(yōu)化不同芯片的性能,可以開(kāi)發(fā)出更高效、更靈活的解決方案。

多芯混合技術(shù)為國(guó)產(chǎn)廠商帶來(lái)了綜合性的發(fā)展機(jī)遇。這一技術(shù)不僅推動(dòng)了技術(shù)創(chuàng)新,滿(mǎn)足了市場(chǎng)對(duì)高性能、低功耗芯片的日益增長(zhǎng)需求,還促進(jìn)了產(chǎn)業(yè)鏈上下游的協(xié)同合作,加強(qiáng)了產(chǎn)業(yè)整體競(jìng)爭(zhēng)力。同時(shí),國(guó)家政策的支持也為國(guó)產(chǎn)廠商在多芯混合技術(shù)領(lǐng)域的發(fā)展提供了有力保障。國(guó)產(chǎn)廠商應(yīng)抓住這一機(jī)遇,加大研發(fā)力度,推動(dòng)多芯混合技術(shù)的突破與應(yīng)用,以提升國(guó)產(chǎn)芯片的技術(shù)水平和市場(chǎng)競(jìng)爭(zhēng)力。