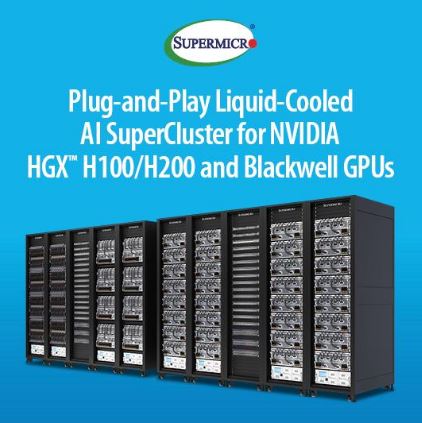

Supermicro推出機柜級即插即用液冷AI SuperCluster

2024-06-12

來源:Supermicro

生成式AI SuperCluster與NVIDIA AI Enterprise、NIM微服務(wù)整合,并通過大規(guī)模可擴(kuò)展的計算單元,提供立即性投資報酬率效益和更低的AI運行成本,進(jìn)而簡化AI以利快速部署

【2024 年 6 月 7 日,加州圣何塞及臺北訊】Supermicro, Inc.(NASDAQ:SMCI)作為AI、云端、儲存和 5G/邊緣領(lǐng)域的全方位IT解決方案制造商,推出可立即部署式液冷型AI數(shù)據(jù)中心。此數(shù)據(jù)中心專為云原生解決方案而設(shè)計,通過SuperCluster加速各界企業(yè)對生成式AI的運用,并針對NVIDIA AI Enterprise 軟件平臺優(yōu)化,適用于生成式AI的開發(fā)與部署。通過Supermicro的4U液冷技術(shù),NVIDIA近期推出的Blackwell GPU 能在單一GPU上充分發(fā)揮20 PetaFLOPS的AI性能,且與較早的GPU相比,能提供4倍的AI訓(xùn)練性能與30倍的推理性能,并節(jié)省額外成本。配合此率先上市的策略,Supermicro近期推出基于NVIDIA Blackwell架構(gòu)的完善產(chǎn)品系列,支持新型NVIDIA HGX? B100、B200和GB200 Grace Blackwell Superchip 。

Supermicro總裁兼首席執(zhí)行官梁見后表示:“Supermicro 在打造與部署具有機柜級液冷技術(shù)的AI解決方案方面持續(xù)領(lǐng)先業(yè)界。數(shù)據(jù)中心的液冷配置設(shè)計可幾近免費,并通過能持續(xù)降低用電量的優(yōu)勢為客戶提供額外價值。我們的解決方案針對NVIDIA AI Enterprise軟件優(yōu)化,滿足各行各業(yè)的客戶需求,并提供世界規(guī)模級效率的全球制造產(chǎn)能。因此我們得以縮短交付時間,更快提供搭配NVIDIA HGX H100和H200,以及即將推出的B100、B200和GB200解決方案的可立即使用型液冷或氣冷計算叢集。從液冷板到CDU乃至冷卻塔,我們的機柜級全方位液冷解決方案最大可以降低數(shù)據(jù)中心40%的持續(xù)用電量。”

在臺北國際計算機展(COMPUTEX 2024)上,Supermicro展示了即將推出,并針對NVIDIA Blackwell GPU優(yōu)化的系統(tǒng),包括基于NVIDIA HGX B200的10U氣冷系統(tǒng)和4U液冷系統(tǒng)。此外,Supermicro也將提供8U氣冷型NVIDIA HGX B100系統(tǒng)、NVIDIA GB200 NVL72機柜(具有72個通過NVIDIA NVLink 交換器 互連的GPU)與新型 NVIDIA MGX?系統(tǒng)(支持NVIDIA H200 NVL PCIe GPU與最新發(fā)布的NVIDIA GB200 NVL2架構(gòu))。

NVIDIA創(chuàng)始人兼首席執(zhí)行官黃仁勛表示:“生成式AI正在推動整個計算堆棧的重置,新的數(shù)據(jù)中心將會通過GPU進(jìn)行計算加速,并針對AI優(yōu)化。Supermicro設(shè)計了頂尖的NVIDIA加速計算和網(wǎng)絡(luò)解決方案,使價值數(shù)兆美元的全球數(shù)據(jù)中心能夠針對AI時代優(yōu)化。”

隨著大語言模型(Large Language Model,LLM)的快速發(fā)展以及Meta的Llama-3和Mistral的Mixtral 8x22B等開源模型不斷推出,企業(yè)更容易取得并使用當(dāng)今最先進(jìn)的AI模型。簡化AI基礎(chǔ)設(shè)施并以最具成本效益的方式提供存取能力,對于支持目前的急速AI變革至關(guān)重要。Supermicro云原生AI SuperCluster使實時存取的云端便利性和可移植性之間得以連結(jié),并通過NVIDIA AI Enterprise讓任何規(guī)模的AI項目從評估測試階段無縫順暢地進(jìn)行到實際作業(yè)階段。這提供了能在任何地方運行并安全管理數(shù)據(jù)的靈活性,包括自架系統(tǒng)或本地大型數(shù)據(jù)中心。

隨著各界企業(yè)急速進(jìn)行生成式AI的實驗性使用,Supermicro與NVIDIA密切合作,確保無縫且靈活地從AI應(yīng)用的實驗和評估試行推動至作業(yè)部署和大規(guī)模數(shù)據(jù)中心AI。此順暢流程是借由NVIDIA AI Enterprise軟件平臺的機柜、叢集級優(yōu)化而實現(xiàn),能使從初步探索至可擴(kuò)展AI落地的過程更流暢無阻。

托管服務(wù)涉及基礎(chǔ)架構(gòu)的選擇、數(shù)據(jù)共享和生成式AI策略控管。NVIDIA NIM微服務(wù)作為 NVIDIA AI Enterprise的一部分,可在無缺陷情況下提供托管生成式AI和開源部署優(yōu)勢。其多功能推理運行環(huán)境通過微服務(wù),可加速從開源模型到NVIDIA基礎(chǔ)模型等各類型生成式AI的部署。此外,NVIDIA NeMo?可實現(xiàn)通過數(shù)據(jù)管理、進(jìn)階自定義和檢索增強生成(Retrieval-Augmented Generation,RAG)的客制模型開發(fā),以實現(xiàn)企業(yè)級解決方案。與搭配NVIDIA AI Enterprise的Supermicro SuperCluster整合后,NVIDIA NIM能為可擴(kuò)展、加速型生成式AI作業(yè)的部署提供最快途徑。

Supermicro目前的生成式AI SuperCluster產(chǎn)品包括:

●液冷型Supermicro NVIDIA HGX H100/H200 SuperCluster,具有256個H100/H200 GPU,為5個機柜規(guī)模的可擴(kuò)展計算單元(包括 1 個專用網(wǎng)絡(luò)機柜)

●氣冷型Supermicro NVIDIA HGX H100/H200 SuperCluster,具有256個HGX H100/H200 GPU,為9個機柜規(guī)模的可擴(kuò)展計算單元(包括1個專用網(wǎng)絡(luò)機柜)

●Supermicro NVIDIA MGX GH200 SuperCluster,具有256個GH200 GraceTM Hopper Superchip,為9個機柜規(guī)模的可擴(kuò)展計算單元(包括1個專用網(wǎng)絡(luò)機柜)

Supermicro的SuperCluster支持NVIDIA AI Enterprise,其中包括NVIDIA NIM微服務(wù)和NVIDIA NeMo平臺,能實現(xiàn)端對端生成式AI客制,并針對NVIDIA Quantum-2 InfiniBand以及具有每GPU 400Gb/s網(wǎng)速的新型NVIDIA Spectrum-X以太網(wǎng)絡(luò)平臺優(yōu)化,可擴(kuò)展到具有數(shù)萬個GPU的大型計算叢集。

Supermicro即將推出的SuperCluster產(chǎn)品包括:

●Supermicro NVIDIA HGX B200 SuperCluster,液冷型

●Supermicro NVIDIA HGX B100/B200 SuperCluster,氣冷型

●Supermicro NVIDIA GB200 NVL72 或 NVL36 SuperCluster,液冷型

Supermicro的SuperCluster解決方案針對LLM訓(xùn)練、深度學(xué)習(xí)以及大規(guī)模與大批量推理優(yōu)化。Supermicro的L11和L12驗證測試及現(xiàn)場部署服務(wù)可為客戶提供無縫順暢體驗。客戶收到即插即用的可擴(kuò)充單元后即可在數(shù)據(jù)中心輕松部署,進(jìn)而更快取得效益。

更多精彩內(nèi)容歡迎點擊==>>電子技術(shù)應(yīng)用-AET<<