名曰Figure 01,它能聽會說,動作靈活。

能和人類描述眼前看到的一切:

我在桌子上看到了一個紅色的蘋果,瀝水架上面還有幾個盤子和一個杯子;然后你站在附近,手放在桌子上。

聽到人類說“想吃東西”,就馬上遞過去蘋果。

而且對于自己做的事有清楚認(rèn)知,給蘋果是因為這是桌上唯一能吃的東西。

還順便把東西整理,能同時搞定兩種任務(wù)。

最關(guān)鍵的是,這些展示都沒有加速,機器人本來的動作就這么迅速。

接下來,我們繼續(xù)來看下Figure 01的細(xì)節(jié)。

OpenAI視覺語言大模型加持

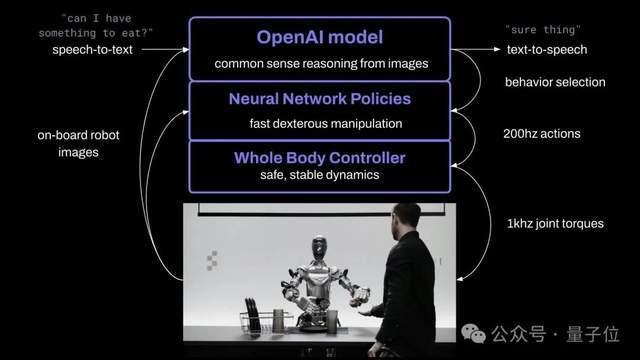

根據(jù)創(chuàng)始人的介紹,F(xiàn)igure 01通過端到端神經(jīng)網(wǎng)絡(luò),可以和人類自如對話。

基于OpenAI提供的視覺理解和語言理解能力,它能完成快速、簡單、靈巧的動作。

模型只說是一個視覺語言大模型,是否為GPT-4V不得而知。

它還能規(guī)劃動作、有短期記憶能力、用語言解釋它的推理過程。

如對話里說“你能把它們放在那里嗎?”

“它們”、“那里”這種模糊表述的理解,就體現(xiàn)了機器人的短期記憶能力。

它使用了OpenAI訓(xùn)練的視覺語言模型,機器人攝像頭會以10Hz拍下畫面,然后神經(jīng)網(wǎng)絡(luò)將以200Hz輸出24自由度動作(手腕+手指關(guān)節(jié)角度)。

具體分工上,機器人的策略也很像人類。

復(fù)雜動作交給AI大模型,預(yù)訓(xùn)練模型會對圖像和文本進(jìn)行常識推理,給出動作計劃;

簡單動作如抓起塑料袋(抓哪里都可以),機器人基于已學(xué)習(xí)的視覺-動作執(zhí)行策略,可以做出一些“下意識”的快速反應(yīng)行動。

同時全身控制器會負(fù)責(zé)保持機身平衡、運動穩(wěn)定。

除了最先進(jìn)的AI模型,F(xiàn)igure 01背后公司——Figure的創(chuàng)始人兼CEO還在推文中提到,F(xiàn)igure方面整合了機器人的所有關(guān)鍵組成。

包括電機、中間件操作系統(tǒng)、傳感器、機械結(jié)構(gòu)等,均由Figure工程師設(shè)計。

據(jù)了解,這家機器人初創(chuàng)公司在2周前才正式宣布和OpenAI的合作,但才13天后就帶來如此重磅成果。不少人都開始期待后續(xù)合作了。

由此,具身智能領(lǐng)域又有一顆新星走到了聚光燈下。

“將人形機器人帶進(jìn)生活”

說到Figure,這家公司創(chuàng)立于2022年,正如前文所言,再次引爆外界關(guān)注,就在十幾天前——

官宣在新一輪融資中籌集6.75億美元,估值沖到26億美元,投資方幾乎要集齊半個硅谷,包括微軟、OpenAI、英偉達(dá)和亞馬遜創(chuàng)始人貝佐斯等等。

更重要的是,OpenAI同時公開了與Figure更進(jìn)一步合作的計劃:將多模態(tài)大模型的能力擴展到機器人的感知、推理和交互上,“開發(fā)能夠取代人類進(jìn)行體力勞動的人形機器人”。

用現(xiàn)在最熱的科技詞匯來說,就是要一起搞具身智能。