最近爆火的ChatGPT和AI作畫驚艷了無數(shù)人,能對(duì)話問答、能翻譯、能寫詩,還能修代碼,ChatGPT展示了既強(qiáng)大又通用的語言能力。其強(qiáng)大的通用語言能力背后,是1750億個(gè)模型參數(shù)和45TB的訓(xùn)練數(shù)據(jù)(以它的上一代GPT-3為例)。如此巨大的計(jì)算量,沒有算力的持續(xù)增長(zhǎng),是不可能實(shí)現(xiàn)的。ChatGPT及GPT-3這樣的大語言模型展示了,當(dāng)模型的大小和訓(xùn)練量的大小出現(xiàn)量變以后,最后的表現(xiàn)結(jié)果就是產(chǎn)生質(zhì)變。這本質(zhì)上揭示了“智能”和算力的深刻聯(lián)系。

算力發(fā)展與科技奇點(diǎn)

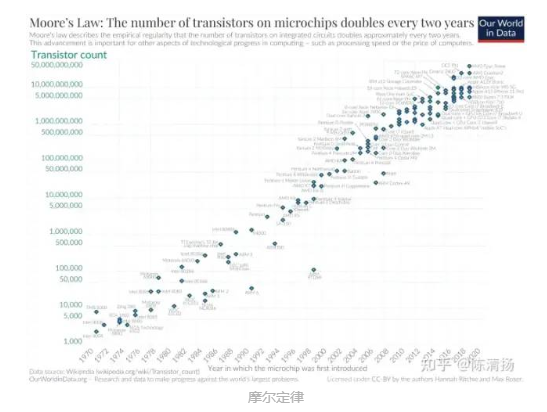

計(jì)算機(jī)的計(jì)算能力便每隔幾年翻一倍,計(jì)算機(jī)的應(yīng)用也遍地開花:1980年代末出現(xiàn)了互聯(lián)網(wǎng),1990年代出現(xiàn)了搜索引擎,2000年代出現(xiàn)了社交網(wǎng)絡(luò),2010年代出現(xiàn)移動(dòng)互聯(lián)網(wǎng),而2012年AlexNet橫空出世。計(jì)算機(jī)應(yīng)用的變遷和發(fā)展背后的動(dòng)力則是算力的發(fā)展,當(dāng)算力達(dá)到一定的程度了,相應(yīng)的應(yīng)用就會(huì)自然涌現(xiàn)。英特爾的創(chuàng)始人Gordon Moore1965年提出了著名的摩爾定律,后來摩爾定律有很多個(gè)說法,最簡(jiǎn)單的說法是,在價(jià)格不變的情況下,芯片中的晶體管數(shù)量每18個(gè)月翻一倍。摩爾定律并不是物理規(guī)律,而是一種對(duì)于人類科技進(jìn)步趨勢(shì)的洞察,即算力的增長(zhǎng)是指數(shù)的。

美國著名未來學(xué)家、奇點(diǎn)臨近一書的作者Ray Kurzweil認(rèn)為,算力的發(fā)展其實(shí)一直指數(shù)增長(zhǎng)的過程,這個(gè)過程開始得遠(yuǎn)遠(yuǎn)早于摩爾定律,譬如世界上第一臺(tái)電子計(jì)算機(jī)使用的材料是電子管,而電子管后來被晶體管取代。在電子管之前甚至還有通過機(jī)械原理制造的計(jì)算機(jī)Z3。如今基于硅的集成電路工藝已經(jīng)小到了一定程度,在未來會(huì)遇到散熱上的瓶頸,但是這并不妨礙未來人們會(huì)有更好的方式和材料來構(gòu)造計(jì)算機(jī),繼續(xù)保持算力的持續(xù)增長(zhǎng)。

算力持續(xù)指數(shù)增長(zhǎng)下去的結(jié)果就是科技發(fā)展的加快,想想從2012年Alex橫空出世到現(xiàn)在AI才發(fā)展了10年,就已經(jīng)取得了巨大的進(jìn)步。而人類14000年前才進(jìn)入農(nóng)業(yè)時(shí)代,200多年前才進(jìn)入工業(yè)革命時(shí)代,不到100年前才有計(jì)算機(jī),不到20年前才有智能手機(jī),而10年前才有了深度學(xué)習(xí)的爆發(fā),這的確印證了科技的指數(shù)發(fā)展。

神經(jīng)網(wǎng)絡(luò)的低谷與爆發(fā)

1.神經(jīng)網(wǎng)絡(luò)的發(fā)展,經(jīng)歷了兩次低谷期:

第一次低谷是算法:神經(jīng)網(wǎng)絡(luò)50年代提出,此時(shí)主要由生物學(xué)背景的科學(xué)家主導(dǎo)。但隨著人工智能之父提出的異或問題,人們開始質(zhì)疑,認(rèn)為神經(jīng)網(wǎng)絡(luò)是騙人的。

但從80年代開始,物理學(xué)家開始進(jìn)入這一陣地。并在1986年,提出了BP算法,通過梯度下降的方式,可以將誤差收斂到一個(gè)極小值,論上證明了神經(jīng)網(wǎng)絡(luò)這種聯(lián)結(jié)主義可用,BP算法大獲成功。

第二次低谷是算力:隨著神經(jīng)網(wǎng)絡(luò)的發(fā)展,人們很快就遇到了新的問題,那就是收斂速度和泛化的問題。

簡(jiǎn)單說就是“慢”。當(dāng)時(shí)的計(jì)算器CPU性能還不夠強(qiáng)大,對(duì)于稍微大點(diǎn),層數(shù)和節(jié)點(diǎn)多一點(diǎn)的網(wǎng)絡(luò),訓(xùn)練時(shí)間太長(zhǎng),稍微大的規(guī)模就無法處理了。

2.進(jìn)入21世紀(jì)出現(xiàn)了轉(zhuǎn)機(jī):

數(shù)據(jù):21世紀(jì),互聯(lián)網(wǎng)快速發(fā)展,人類通過互聯(lián)網(wǎng)的運(yùn)轉(zhuǎn),獲取了過去十多年難以想象的海量數(shù)據(jù)。這些數(shù)據(jù),為神經(jīng)網(wǎng)絡(luò)的數(shù)據(jù)構(gòu)建和訓(xùn)練帶來了可行性。

高級(jí)算法:2006年,Hinton在Science首次提出“深度信念網(wǎng)絡(luò)”的概念。與傳統(tǒng)的訓(xùn)練方式不同,“深度信念網(wǎng)絡(luò)”有一個(gè)“預(yù)訓(xùn)練”過程,可以方便地讓神經(jīng)網(wǎng)絡(luò)中的權(quán)值找到一個(gè)接近最優(yōu)解的值,之后再使用“微調(diào)”(fine-tuning)技術(shù)來對(duì)整個(gè)網(wǎng)絡(luò)進(jìn)行優(yōu)化訓(xùn)練。

預(yù)訓(xùn)練+微調(diào),這種兩部訓(xùn)練技術(shù)的運(yùn)用,大幅度的減少了多層神經(jīng)網(wǎng)絡(luò)的訓(xùn)練時(shí)間。在上一篇文章的ChatGPT發(fā)展過程中我也有提到,ChatGPT的基本能力來源于預(yù)訓(xùn)練,而能力進(jìn)化和解鎖來源于指令微調(diào)。

這個(gè)階段,訓(xùn)練和計(jì)算基本依靠CPU進(jìn)行,CPU頻率也在逐漸提高,但此時(shí)10億量級(jí)的鏈接,比如2012年的Google X 項(xiàng)目,訓(xùn)練這一模型,耗費(fèi)了1000臺(tái)計(jì)算機(jī),16000個(gè)CPU計(jì)算,其訓(xùn)練速度、運(yùn)行時(shí)間、訓(xùn)練成本都不能令人滿意。

而因?yàn)镃PU算力有限,此時(shí)深度學(xué)習(xí)發(fā)展速度并不快。

3.GPU的強(qiáng)大計(jì)算能力的引入:

CPU是專門為按序列串行處理優(yōu)化的核心組成;而 GPU 則擁有大規(guī)模并行架構(gòu),當(dāng)中包含數(shù)千個(gè)更小、更高效的核心,專為同時(shí)處理多重任務(wù)而設(shè)計(jì)。與僅包含 CPU 的配置相比,GPU 的數(shù)據(jù)處理速度快得多。

在神經(jīng)網(wǎng)絡(luò)在最初的訓(xùn)練過程中,主要依靠的是CPU。

在2011~2012年前后,英偉達(dá)顯卡GTX580被導(dǎo)入到CNN模型計(jì)算,對(duì)于大模型的訓(xùn)練,GPU的加速效果達(dá)到了CPU的60倍左右。比如上文的10億個(gè)連接的Google X項(xiàng)目,在同等工作量和時(shí)間下,只需要64個(gè)GPU的16臺(tái)電腦就可以運(yùn)算出結(jié)果。

2012年,吳恩達(dá)用3臺(tái)GTX680,就完成了谷歌用1000臺(tái)CPU服務(wù)器才能完成的貓臉識(shí)別任務(wù),GPU正式被各大互聯(lián)網(wǎng)頭部廠商導(dǎo)入,但依然處于CPU+GPU并行的階段。

2016年,英偉達(dá)推出新的GPU架構(gòu),專門針對(duì)AI計(jì)算進(jìn)行優(yōu)化。而在之后的兩年時(shí)間,基于深度學(xué)習(xí)的AlphaGo先后戰(zhàn)勝李世石和柯潔。

也就是那時(shí)候開始,深度學(xué)習(xí)/人工智能在短時(shí)間之內(nèi)火遍業(yè)界、學(xué)術(shù)界和就業(yè)市場(chǎng)。相信幾年前的火熱場(chǎng)景大家還有影響,一個(gè)應(yīng)屆生,只要會(huì)一點(diǎn)tensorflow,pytorch,會(huì)調(diào)參數(shù)的調(diào)參俠就可以被公司以四五十萬招攬。

而因?yàn)镚PU強(qiáng)大的加速效果,隨著以深度學(xué)習(xí)為核心的各種應(yīng)用,不斷涌現(xiàn)并且快速落地。GPU在此時(shí),成為了AI計(jì)算的標(biāo)配。

從數(shù)據(jù),算法、算力,一點(diǎn)點(diǎn)積累,最終造就的就是一次小規(guī)模的科技大爆發(fā),而這次科技大爆發(fā)的成果就是深度學(xué)習(xí),而其所帶來的,則是算力需求的大爆炸。

算力需求大爆炸

1.需求大爆炸:

在深度學(xué)習(xí)新算法+GPU的兩大加持之下,AI計(jì)算在應(yīng)用領(lǐng)域極速擴(kuò)大。

尤其是隨著云計(jì)算、金融、短視頻推薦算法,圖像識(shí)別(安防、智慧城市)以及自動(dòng)駕駛的飛速發(fā)展,互聯(lián)網(wǎng)巨頭、ZF,公共事業(yè)部門、安全部門等,對(duì)于算力的需求飛速增長(zhǎng)。再加上加密貨幣的火熱,出現(xiàn)了第一次算力需求的大爆炸。

在社會(huì)層面,互聯(lián)網(wǎng)巨頭們對(duì)于算力的海量需求,大量的數(shù)據(jù)中心和算力中心被建立,GPU芯片被快速部署到各種服務(wù)器,數(shù)據(jù)中心,并且在持續(xù)的進(jìn)行。

而政府規(guī)劃層面,東數(shù)西算、智算中心也自此誕生。

而英偉達(dá)則隨著GPU的大量出貨,GPU+CUDA獨(dú)霸市場(chǎng),股價(jià)也開啟了從30,漲到800的逆天之旅。

2.GPU局限性

但是,通用GPU在使用過程中,也逐漸顯現(xiàn)出局限性,并不能滿足每一種需求,因?yàn)橛械膫?cè)重訓(xùn)練,而有的則是側(cè)重推理,有的側(cè)重能效,比如加密貨幣領(lǐng)域,為了最求更高的能效比,礦卡開始大量取代英偉達(dá)的GPU。

其實(shí),這個(gè)局限性,在谷歌的AlphaGO就已經(jīng)顯現(xiàn),最初的AlphaGo完整版本運(yùn)行在48顆CPU和8塊GPU上,這個(gè)板本的AlphaGO的反應(yīng)相對(duì)較慢,并不足以顛覆人機(jī)大戰(zhàn),李世石一度很有信心。

但實(shí)際上,后續(xù)與李世石的對(duì)弈,谷歌引入了高度定制化的,基于tensor Flow深度學(xué)習(xí)架構(gòu)的TPU,按照谷歌的描述,其TPU 平均比當(dāng)前的 GPU 或 CPU 快15~30倍,能效比更是GPU的70倍,CPU的兩百倍。在這一配置下,AlphaGO以絕對(duì)優(yōu)勢(shì)擊敗了李世石。雖然TPU通用性差,但效率巨高,后來在谷歌翻譯、圖像搜索、谷歌照片(Google Photo)、谷歌云視覺API 中大量應(yīng)用。

與之類似的是,特斯拉的自動(dòng)駕駛,F(xiàn)SD芯片從18年開始導(dǎo)入,不僅僅依賴于GPU, 而是專門加入了神經(jīng)處理單元和各種加速器。后續(xù)更是開發(fā)了Dojo+D1芯片,專門承擔(dān)算法訓(xùn)練重任。

還有百度,在使用GPU的時(shí)候,也采用FPGA研發(fā)AI加速。并最終自研了云端全功能AI芯片-昆侖。

而阿里,因?yàn)閼?yīng)用場(chǎng)景不同,則是自研了含光800,更加側(cè)重于推理。在城市大腦的業(yè)務(wù)測(cè)試中,1顆含光800的算力相當(dāng)于10顆GPU。

可以說,在第一次算力需求大爆發(fā)下,GPU 雖然獨(dú)霸市場(chǎng),但各種偏訓(xùn)練、推理的專用芯片也開始快速的發(fā)展。

新的算力需求大爆炸即將到來

深度學(xué)習(xí)伴隨的第一次算力需求大爆炸,To C應(yīng)用火熱的基本沒有,更多的是在To B 和 To G,主要在云端部署。GPU+專用芯片,第一次算力需求的大爆發(fā),似乎處于一個(gè)相對(duì)平衡階段。

但是,當(dāng)ChatGPT月活用戶接近1億的時(shí)候,事情就不一樣了。這是互聯(lián)網(wǎng)發(fā)展20年來,增長(zhǎng)最快的消費(fèi)類應(yīng)用。這也是人工智能誕生以來,面向C端用戶增長(zhǎng)最快的速度。

這是獲得大眾認(rèn)可的AI C端產(chǎn)品,而過去,人們只會(huì)叫他們“人工智障”。天貓精靈或者各種什么同學(xué),有時(shí)候能讓你氣的腦溢血。人們往往用一用,就過了新鮮勁,所以更多的AI還是在B端,G端,用在現(xiàn)在,已經(jīng)有1億人對(duì)ChatGPT表示出了高漲的熱情。大佬們更是給出了超高的評(píng)價(jià):

比爾蓋茨說,“ChatGPT讓我們窺見了即將發(fā)生的事情,這項(xiàng)技術(shù)以及其革新速度都令人印象深刻。”美國《財(cái)富》雜志評(píng)價(jià)ChatGPT就是人工智能行業(yè)的iPhone。商湯智能產(chǎn)業(yè)研究院長(zhǎng)田豐認(rèn)為:“ChatGPT驗(yàn)證了當(dāng)前AI大模型的巨大商業(yè)價(jià)值和科研價(jià)值。ChatGPT的出圈,可能意味著一個(gè)AI大規(guī)模商業(yè)化時(shí)代的到來。

ChatGPT讓谷歌,微軟、百度等一眾大佬剛到恐懼,他雖然不是搜索引擎,但用戶通過ChatGPT獲得更準(zhǔn)確、及時(shí)、人性化的答案,這個(gè)時(shí)候還需要搜索引擎嗎?谷歌的Gmail創(chuàng)始人保羅·布赫海特認(rèn)為,谷歌距離被徹底顛覆可能只需要一兩年的時(shí)間,像ChatGPT這樣的AI聊天機(jī)器人將摧毀谷歌,消滅搜索引擎結(jié)果頁面。

ChatGPT取得的成績(jī),以及各種高度的評(píng)價(jià),足夠令人重視。而我們需要重視的,是ChatGPT背后的通用大模型技術(shù):他已經(jīng)在醫(yī)藥研究、虛擬電廠等各種方向開始創(chuàng)新和發(fā)展。但當(dāng)他以To C的方式出圈,會(huì)進(jìn)一步推動(dòng)這種模型在產(chǎn)業(yè)層的應(yīng)用。

而這樣一個(gè)需要進(jìn)行大規(guī)模預(yù)訓(xùn)練,具有3000億數(shù)據(jù),將近2000億參數(shù)的超級(jí)大模型。當(dāng)前僅僅是GPT-3.5, 近期將會(huì)更新GPT-4,他的參數(shù)將比3代再高出幾個(gè)量級(jí)。

這個(gè)模型的訓(xùn)練,目前OpenAI至少導(dǎo)入了一萬多塊的英偉達(dá)最高端的GPU進(jìn)行預(yù)訓(xùn)練。而觸發(fā)第一次算力需求大爆炸時(shí)的AlphaGO 僅僅需要8塊GPU RTX680,而和柯潔對(duì)戰(zhàn)的go只用了4塊GPU。

這種大模型,對(duì)算力的需求至少是指數(shù)級(jí)的增長(zhǎng)。當(dāng)他從實(shí)驗(yàn)室走向落地,旦類似的大模型開始根據(jù)各行各業(yè)做推廣和部署,這個(gè)算力需求是個(gè)無底洞,當(dāng)前的算力是不夠的。甚至于東數(shù)西算打造的各種數(shù)據(jù)中心,也遠(yuǎn)遠(yuǎn)難以應(yīng)對(duì)即將到來的,"新的一輪的,算力需求大爆炸"。

我們可能需要更多,不僅僅依賴于數(shù)據(jù)中心,云計(jì)算,更需要算力網(wǎng)絡(luò),需要云網(wǎng)融合,甚至需要端測(cè)設(shè)備也提供算力,將端側(cè)的閑置算力鏈接并網(wǎng)。我們不僅需要GPU,更需要各種專用的云端訓(xùn)練芯片,推理芯片。我們還需要各種端側(cè)的推理芯片,NPU/AI 芯片,未來的各種終端都需要具有AI算力。不僅僅用于處理端側(cè)的算力需求,還要將閑置的算力貢獻(xiàn)到整個(gè)算力網(wǎng)絡(luò)中調(diào)配,類似于BTC挖礦。

新的一次的算力需求大爆炸,我相信不會(huì)太遠(yuǎn),也許在2025年前后就會(huì)到來。這是個(gè)機(jī)會(huì),因?yàn)闈摿拖胂罅薮蟆5埠茈y,因?yàn)槲覀冊(cè)诟叨怂懔ι先笔?yán)重,我們?cè)诟呖萍碱I(lǐng)域、半導(dǎo)體領(lǐng)域、高性能計(jì)算等方面被各種掣肘。

不過國家正在規(guī)劃的事情放到一起去看,能看出些東西的。比如GPGPU、算力、訓(xùn)練芯片各種芯片廠家快速獲得大額融資;比如各家互聯(lián)網(wǎng)大廠、新能源汽車主機(jī)廠的數(shù)據(jù)中心,算力中心,智算中心的加快建設(shè);比如國家的東數(shù)西算,云網(wǎng)融合,算力網(wǎng)絡(luò)。

相信趕上不會(huì)太遠(yuǎn)了。

來 源 | 知乎@陳清揚(yáng)、雪球@撿貝殼的FBB

歡迎關(guān)注電子技術(shù)應(yīng)用2023年2月22日==>>商業(yè)航天研討會(huì)<<