中文預(yù)訓(xùn)練語(yǔ)言模型,參數(shù)量也上了千億,還是為業(yè)界定制的。

如果你是一位 NLP 從業(yè)者,你可能發(fā)現(xiàn),最近的中文 NLP 社區(qū)有點(diǎn)熱鬧:「中文版 T5」、「中文版 GPT-3」以及各種大規(guī)模中文版預(yù)訓(xùn)練模型陸續(xù)問世,似乎要帶領(lǐng)中文 NLP 社區(qū)跑步進(jìn)入「練大模型」時(shí)代。

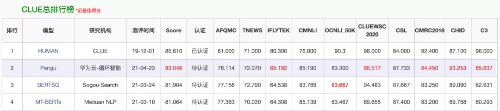

在此背景下,中文語(yǔ)言理解測(cè)評(píng)基準(zhǔn)「CLUE」也經(jīng)歷了它的前輩「GLUE」所經(jīng)歷過的盛況:一個(gè)模型的冠軍寶座還沒坐熱,就被一個(gè)更新的模型擠了下去。

這次刷榜的,是一個(gè)叫「盤古」的 NLP 模型。

在最近的 CLUE 榜單上,「盤古」在總榜、閱讀理解排行榜和分類任務(wù)排行榜上都位列第一,總榜得分比第二名高出一個(gè)百分點(diǎn)。

除此之外,它還拿到了 NLPCC 生成任務(wù)的第一名,文本摘要的分?jǐn)?shù)相比基線提升了 60%。

在HDC.Cloud大會(huì)上,余承東發(fā)布由華為云和循環(huán)智能聯(lián)合開發(fā)的盤古NLP 模型

這是業(yè)界首個(gè)千億參數(shù)的中文大模型,擁有 1100 億密集參數(shù),由循環(huán)智能(Recurrent AI)和華為云聯(lián)合開發(fā),鵬城實(shí)驗(yàn)室提供算力支持。

為了訓(xùn)練這個(gè)模型,田奇(華為云人工智能首席科技家)與楊植麟(循環(huán)智能聯(lián)合創(chuàng)始人)聯(lián)合帶領(lǐng)的研究團(tuán)隊(duì)花了近半年的時(shí)間,給模型喂了 40TB 的行業(yè)文本數(shù)據(jù)和超過 400 萬小時(shí)的行業(yè)語(yǔ)音數(shù)據(jù)。

所有這些努力,都是為了克服 GPT-3 的落地難題。

「GPT-3 是一個(gè)學(xué)術(shù)界的產(chǎn)物,是一個(gè)學(xué)術(shù)研究的重大突破,但在落地過程中仍然面臨很多問題。」楊植麟告訴機(jī)器之心,「導(dǎo)致這個(gè)問題的原因是,學(xué)術(shù)研究往往以人工收集構(gòu)造的相對(duì)通用化的數(shù)據(jù)集作為 benchmark,往往以較理想化的設(shè)定來進(jìn)行實(shí)驗(yàn)(比如類別均衡的多分類問題),這些都跟實(shí)際應(yīng)用有出入。盤古模型實(shí)際上針對(duì)性地解決了這些問題。跟以往的大規(guī)模預(yù)訓(xùn)練模型不同,盤古模型從第一天起就是奔著商業(yè)化落地的角度進(jìn)行設(shè)計(jì)和研發(fā)。」

作為一個(gè)深耕 NLP 企業(yè)服務(wù)的團(tuán)隊(duì),循環(huán)智能看到了 GPT-3 等大規(guī)模預(yù)訓(xùn)練模型的潛力,但也看到了它們?cè)诼涞剡^程中的局限。「盤古」模型正是為了克服這些局限而生。在最近的一次訪談中,循環(huán)智能 NLP Moonshot 團(tuán)隊(duì)向機(jī)器之心介紹了這個(gè)項(xiàng)目的初衷、挑戰(zhàn)和具體的解決方案。

GPT-3 很強(qiáng),但到了業(yè)界不好用

GPT-3 是 OpenAI 在去年 5 月份發(fā)布的語(yǔ)言模型,不僅可以答題、翻譯、寫文章,還帶有一些數(shù)學(xué)計(jì)算的能力,因此在人工智能領(lǐng)域掀起了一場(chǎng)巨浪。

GPT-3 很強(qiáng),這是社區(qū)公認(rèn)的事實(shí),所以循環(huán)智能最初是想開發(fā)一個(gè)中文版 GPT-3。但在開發(fā)過程中,他們發(fā)現(xiàn):GPT 類模型在復(fù)雜的商業(yè)場(chǎng)景中既不好用,也不高效。

具體來說,問題出在三個(gè)方面。

第一個(gè)問題是:GPT 對(duì)于復(fù)雜商用場(chǎng)景的少樣本學(xué)習(xí)能力較弱。少樣本學(xué)習(xí)是指利用少量標(biāo)注樣本完成模型的學(xué)習(xí)任務(wù)。在高質(zhì)量數(shù)據(jù)緊缺、經(jīng)濟(jì)效益至上的產(chǎn)業(yè)界,這一能力非常重要。

此前,Schick 和 Schutze 已經(jīng)在 PET 工作中證明:在少樣本學(xué)習(xí)方面,千億參數(shù)的 GPT-3 模型的語(yǔ)言理解能力還比不上億級(jí)參數(shù)量的 BERT。在復(fù)雜的企業(yè)級(jí)落地場(chǎng)景中,這一缺陷將使得模型在利用數(shù)據(jù)方面非常低效。

比如在下面這兩段保險(xiǎn)場(chǎng)景對(duì)話中,模型需要判斷服務(wù)人員是否正確講解了「現(xiàn)金價(jià)值可以通過退保的形式返回」這個(gè)專業(yè)保險(xiǎn)知識(shí)。正例需要完整說明以下方面:(1)要用退保的形式;(2)退回的是現(xiàn)金價(jià)值。

對(duì)話 1:

服務(wù)人員:「它有一個(gè)養(yǎng)老的功能,以后您不想保了,那么到一定年限,到現(xiàn)金價(jià)值的高峰期間可以退保,拿到現(xiàn)金價(jià)值 」

對(duì)話 2:

服務(wù)人員:「您如果說保的時(shí)間,不會(huì),因?yàn)榻坏腻X是固定的。只是您這個(gè)保單對(duì)應(yīng)的現(xiàn)金價(jià)值是每年往上漲的」

顯然,對(duì)話 1 同時(shí)提及了退保和退回現(xiàn)金價(jià)值兩個(gè)主要因素,應(yīng)被判斷為正例;而對(duì)話 2 只提及了現(xiàn)金價(jià)值,并不涉及現(xiàn)金價(jià)值贖回的介紹,應(yīng)被判斷為負(fù)例。但針對(duì) 30 億參數(shù)的中文 GPT 模型 CPM 的少樣本學(xué)習(xí)測(cè)試發(fā)現(xiàn),該模型并沒有給出正確答案。

再比如,在下面這段教育場(chǎng)景對(duì)話中,模型需要判斷課程顧問是否推薦了全科輔導(dǎo)班。如果推薦了,則判斷為正例,否則判斷為負(fù)例。

對(duì)話 3:

課程顧問:「啊沒有那么多,你是考慮單科輔導(dǎo)班還是全科輔導(dǎo)班?」

客戶:「這個(gè)這個(gè)我還沒考慮好 」

顯然,在這段對(duì)話中,課程顧問只是單純?cè)儐枺⑽大w現(xiàn)推薦,因此應(yīng)被判斷為負(fù)例,但 CPM 依然沒有正確識(shí)別。

除了少樣本學(xué)習(xí),實(shí)際應(yīng)用中還存在一些需要通過大量樣本進(jìn)行學(xué)習(xí)的場(chǎng)景,這就要涉及到模型的微調(diào)問題。但現(xiàn)實(shí)是,GPT-3 對(duì)于微調(diào)并不友好,在落地場(chǎng)景中難以進(jìn)一步優(yōu)化,這也是 GPT 模型存在的第二大問題。

商業(yè)場(chǎng)景對(duì)于模型的準(zhǔn)確率和召回率有著很高的要求。雖然 P-Tuning 等工作提出了針對(duì) GPT-3 的新型微調(diào)方式,但在面對(duì)復(fù)雜場(chǎng)景時(shí),我們?nèi)匀浑y以通過使用更多標(biāo)注數(shù)據(jù)對(duì) GPT-3 進(jìn)行進(jìn)一步優(yōu)化。

「比如說我們現(xiàn)在用到的一個(gè)場(chǎng)景里面,通過少量樣本得到 GPT-3 的準(zhǔn)確率是 65%。在學(xué)術(shù)研究的語(yǔ)境下,這個(gè)準(zhǔn)確率聽起來也不是很差,但是你實(shí)際場(chǎng)景就沒法用。這時(shí)我們要加一些數(shù)據(jù)對(duì)模型進(jìn)行優(yōu)化,要做到 90% 才能用,但我們實(shí)驗(yàn)發(fā)現(xiàn) GPT-3 結(jié)合微調(diào)的提升并不明顯,這就大大限制了它的使用場(chǎng)景。」楊植麟表示。

GPT-3 是一個(gè)百科全書式的存在,但在很多落地場(chǎng)景中,我們更需要的是一個(gè)領(lǐng)域「專家」。為了打造這個(gè)「專家」,我們需要將行業(yè)的知識(shí)庫(kù)接入 AI 流水線,將通用 AI 能力跟行業(yè)知識(shí)相結(jié)合,實(shí)現(xiàn)基于行業(yè)知識(shí)的精確理解和預(yù)測(cè)。

「例如,在實(shí)時(shí)輔助場(chǎng)景中,我們希望模型能夠?qū)崟r(shí)地給銷售推送知識(shí)、講解要點(diǎn)、推薦產(chǎn)品,通過增強(qiáng)智能的方式提升銷售能力。在這個(gè)場(chǎng)景中,就需要大量外部知識(shí)的接入,才能達(dá)到較好的推薦效果。」循環(huán)智能資深算法總監(jiān)陳虞君解釋說。

但與之相矛盾的是,GPT-3 只能進(jìn)行直接的、端到端的生成(把知識(shí)庫(kù)做成很長(zhǎng)的一段文字,直接放進(jìn) prompt 中),難以融入領(lǐng)域知識(shí),這便是它的第三大問題。

在這三大問題的限制下,GPT-3 的強(qiáng)大能力很難直接在商業(yè)場(chǎng)景中得到發(fā)揮。

盤古:打通 NLP 技術(shù)到產(chǎn)業(yè)的最后一公里

好用、高效是業(yè)界對(duì)一個(gè)模型的基本要求。要達(dá)到這個(gè)要求,首先要克服以上三大問題,這也是「盤古」模型的創(chuàng)新之處。

如何提高少樣本學(xué)習(xí)能力?

為了克服少樣本學(xué)習(xí)難題,循環(huán)智能的研究團(tuán)隊(duì)進(jìn)行了兩方面的努力。

一是利用遷移學(xué)習(xí)。與 GPT-3 的少樣本學(xué)習(xí)方式不同,盤古模型的技術(shù)路線是通過元學(xué)習(xí)的方式在任務(wù)之間進(jìn)行遷移,從而實(shí)現(xiàn)少樣本學(xué)習(xí)的目標(biāo)。這種方式可以更好地利用任務(wù)之間的相似性,得到更好的少樣本學(xué)習(xí)結(jié)果。

二是將 P-tuning、priming 等最新技術(shù)融入到盤古的微調(diào)框架中,進(jìn)一步提升微調(diào)效果。

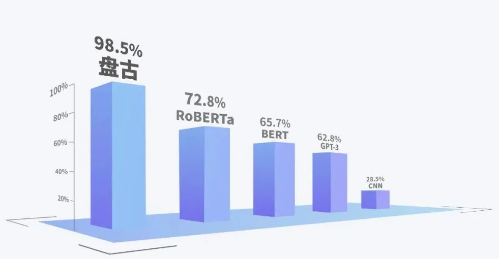

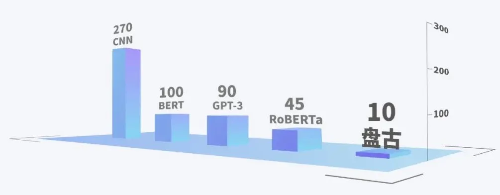

下面兩個(gè)圖展示了 CNN、中文版 GPT-3(CPM)、BERT、RoBERTa 和盤古在少樣本場(chǎng)景下的學(xué)習(xí)能力。

復(fù)雜商用場(chǎng)景實(shí)測(cè)不同模型少樣本學(xué)習(xí)達(dá)到的 F1 結(jié)果(100%表示跟 full label 結(jié)果相同)

各模型復(fù)雜商用場(chǎng)景實(shí)測(cè)得到目標(biāo) F1 結(jié)果所需的平均樣本量

從第一幅圖可以看出,在樣本極少的情況下,盤古的少樣本學(xué)習(xí)能力遠(yuǎn)超上述 GPT 系列和 BERT 系列。

第二幅圖則顯示,要得到相同的 F1 結(jié)果,盤古所需的數(shù)據(jù)量?jī)H為中文 GPT-3 的 1/9,實(shí)現(xiàn)了近 10 倍的生產(chǎn)效率提升。「也就是說,以前可能兩個(gè)星期才能完成的一些工作,現(xiàn)在你用一兩天就可以做完。所以,這個(gè)模型實(shí)際上有很大機(jī)會(huì)去變革生產(chǎn)效率。」循環(huán)智能資深算法總監(jiān)杜羽倫解釋說。

如何解決大模型微調(diào)難題?

大模型微調(diào)難題的解決也分為兩個(gè)方面。

首先,為了增強(qiáng)預(yù)訓(xùn)練與微調(diào)的一致性,研究者在預(yù)訓(xùn)練階段加入了基于 prompt 的任務(wù)。Prompt pattern 的選擇和數(shù)據(jù)增強(qiáng)機(jī)制保證了微調(diào)階段使用的 prompt 得到充分的預(yù)訓(xùn)練,大幅度降低了基于 prompt 的微調(diào)的難度。在下游數(shù)據(jù)充足時(shí),微調(diào)難度的降低使得模型可以隨著數(shù)據(jù)變多而持續(xù)優(yōu)化;在下游數(shù)據(jù)稀缺時(shí),微調(diào)難度的降低使得模型的少樣本學(xué)習(xí)效果得到顯著提升。

其次,研究者觀察到,隨著預(yù)訓(xùn)練模型規(guī)模的增大,微調(diào)難度不斷上升,過擬合十分嚴(yán)重。因此,他們分析了過擬合的主要來源,采用了 gradient dropout 等機(jī)制對(duì)微調(diào)過程進(jìn)行正則化,可以較大程度緩解過擬合的問題。

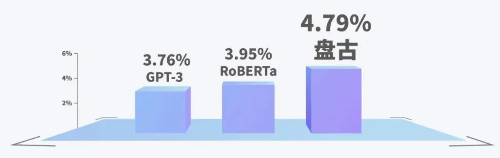

下圖展示了研究團(tuán)隊(duì)針對(duì)銷售線索評(píng)分場(chǎng)景進(jìn)行實(shí)測(cè)的結(jié)果。在銷售線索評(píng)分場(chǎng)景中,數(shù)據(jù)相對(duì)充裕,模型通過分析數(shù)十萬條歷史數(shù)據(jù)的成單情況對(duì)每條銷售線索的客戶意向度進(jìn)行評(píng)分。在這種情況下,由于更適合微調(diào),盤古模型在最終的銷售轉(zhuǎn)化率上取得較大提升。

基于對(duì)話內(nèi)容的銷售線索評(píng)分場(chǎng)景中,使用不同模型的實(shí)測(cè)銷售線索轉(zhuǎn)化率對(duì)比

如何融合行業(yè)知識(shí)?

行業(yè)知識(shí)來源于行業(yè)數(shù)據(jù)。盤古團(tuán)隊(duì)使用了大量行業(yè)語(yǔ)音和文本數(shù)據(jù)。這些數(shù)據(jù)來自銷售、客服等企業(yè)與客戶之間的溝通場(chǎng)景,涵蓋金融、保險(xiǎn)、教育、地產(chǎn)、本地生活、電商、汽車等諸多行業(yè),構(gòu)成了龐大的行業(yè)知識(shí)庫(kù)。借助這些數(shù)據(jù)進(jìn)行微調(diào),模型的行業(yè)特定意圖和知識(shí)理解能力大幅提高。

此外,與 GPT-3 直接使用端到端生成的方式不同,由于盤古模型同時(shí)具備生成能力和少樣本理解能力,開發(fā)者可以根據(jù)業(yè)務(wù)需求靈活搭建 pipeline,包括與行業(yè)知識(shí)庫(kù)進(jìn)行對(duì)接,實(shí)現(xiàn)行業(yè)知識(shí)與通用知識(shí)的融合,最大程度上滿足個(gè)性化的業(yè)務(wù)需求。

可以說,與 GPT-3 等模型相比,「盤古」是專門為產(chǎn)業(yè)落地所打造的,其終極目標(biāo)就是「打通 NLP 技術(shù)與產(chǎn)業(yè)的最后一公里」。

如何賦能產(chǎn)業(yè)?

模型有了,之后要怎么用呢?在這方面,循環(huán)智能 NLP Moonshot 團(tuán)隊(duì)給出了正在做的兩個(gè)方向。

第一個(gè)方向是深入具體場(chǎng)景。

在過去的幾年中,企業(yè)通過部署 AI 客服、AI 外呼系統(tǒng),取代了一小部分人員的簡(jiǎn)單工作。但很多情況下,客戶并沒有感覺自己的服務(wù)體驗(yàn)得到了改善,尤其是在涉及高附加值行業(yè)的產(chǎn)品銷售與服務(wù)時(shí)。

以銀行、保險(xiǎn)、房產(chǎn)和教育等國(guó)計(jì)民生領(lǐng)域?yàn)槔T谶@些領(lǐng)域,企業(yè)意識(shí)到只有通過人與人的溝通過程,才能與客戶建立更緊密的聯(lián)結(jié)。如果 NLP 技術(shù)可以在提升員工專業(yè)度和產(chǎn)能方面發(fā)揮作用,就可以幫助企業(yè)為其客戶帶來更好的體驗(yàn),創(chuàng)造更大的價(jià)值。

這就是循環(huán)智能主攻的方向——增強(qiáng)「人」的智能。

他們的思路可以概括為:借助先進(jìn)的 NLP 技術(shù),從企業(yè)與客戶溝通時(shí)產(chǎn)生的對(duì)話數(shù)據(jù)中挖掘優(yōu)秀員工的優(yōu)秀實(shí)踐,把這些優(yōu)秀實(shí)踐變?yōu)槠髽I(yè)資產(chǎn),然后通過更有針對(duì)性的培訓(xùn)和「實(shí)時(shí)輔助」系統(tǒng),將優(yōu)秀實(shí)踐傳遞給每一名普通員工,提升他們的表現(xiàn)。

通俗點(diǎn)說,實(shí)時(shí)輔助系統(tǒng)有點(diǎn)像企業(yè)給銷售代表、客服等工作人員配備的一個(gè)「外掛」,這個(gè)「外掛」可以實(shí)時(shí)提示工作人員如何更好地解答客戶的疑問,如何更專業(yè)地向客戶介紹產(chǎn)品和服務(wù)……

在實(shí)際應(yīng)用中,循環(huán)智能為企業(yè)提供對(duì)比測(cè)試方案以衡量產(chǎn)品價(jià)值。他們發(fā)現(xiàn),通過讓員工變得更專業(yè),實(shí)時(shí)輔助系統(tǒng)往往能夠帶來員工的產(chǎn)能提升和公司的營(yíng)收再增長(zhǎng)。這個(gè)千億級(jí)別的市場(chǎng),有望借助「盤古」模型的能力,更快地實(shí)現(xiàn)規(guī)模化應(yīng)用。

第二個(gè)方向是打造通用 API。

大模型是一種基礎(chǔ)設(shè)施類型的存在。在楊植麟看來,「盤古」有望成為一個(gè)通用 API,開啟一種新的商業(yè)模式。在這種模式中,開發(fā)者可以基于通用 API,結(jié)合業(yè)務(wù)場(chǎng)景,靈活高效地定制行業(yè)應(yīng)用,解鎖更多此前想象不到的場(chǎng)景。

華為云人工智能首席科學(xué)家、IEEE Fellow 田奇也表示:「盤古 NLP 大模型可以實(shí)現(xiàn)一個(gè) AI 大模型在眾多場(chǎng)景通用、泛化和規(guī)模化復(fù)制,減少對(duì)數(shù)據(jù)標(biāo)注的依賴,讓 AI 開發(fā)由作坊式轉(zhuǎn)變?yōu)楣I(yè)化開發(fā)的新模式。」

「基于模型的 AI 時(shí)代」即將到來?

清華大學(xué)計(jì)算機(jī)科學(xué)與技術(shù)系教授唐杰在前段時(shí)間接受機(jī)器之心采訪時(shí)曾表示,「超大規(guī)模預(yù)訓(xùn)練模型的出現(xiàn),很可能改變信息產(chǎn)業(yè)格局。繼基于數(shù)據(jù)的互聯(lián)網(wǎng)時(shí)代、基于算力的云計(jì)算時(shí)代之后,接下來可能將進(jìn)入基于模型的 AI 時(shí)代。」楊植麟也同意這一觀點(diǎn)。在他看來,這個(gè)新時(shí)代將有兩大特征。

一是 AI 生產(chǎn)效率的變革。隨著標(biāo)注數(shù)據(jù)需求大幅降低,AI 生產(chǎn)效率將迎來兩到三個(gè)數(shù)量級(jí)的提升,擺脫原來依靠大量樣本的落后生產(chǎn)方式,進(jìn)入規(guī)模化量產(chǎn)時(shí)代。

二是 AI 場(chǎng)景的指數(shù)級(jí)增加。技術(shù)的突破往往帶來新市場(chǎng),而目前 AI 商業(yè)化的現(xiàn)狀就是需求很多但技術(shù)不一定滿足。AI 預(yù)訓(xùn)練技術(shù)突破之后,馬上可以解鎖很多新場(chǎng)景,從數(shù)字化程度比較高的行業(yè)走向傳統(tǒng)行業(yè),從大型企業(yè)走向中小企業(yè)。

楊植麟認(rèn)為,預(yù)訓(xùn)練的難題有三個(gè)層次:(1)如何突破現(xiàn)有范式的瓶頸,拓展智能邊界,實(shí)現(xiàn)更強(qiáng)的認(rèn)知能力;(2)基于現(xiàn)有范式,如何進(jìn)行技術(shù)提升,打通技術(shù)和產(chǎn)業(yè)的最后一公里;(3)如何找到合適的商用場(chǎng)景,創(chuàng)造預(yù)訓(xùn)練模型的商業(yè)價(jià)值。

如果「基于模型的 AI 時(shí)代」真的到來,學(xué)界和業(yè)界可能將迎來更加清晰的分工:「盤古模型做的是 2 和 3,也是產(chǎn)業(yè)界重要的工作。學(xué)界應(yīng)該做的是 1 和 2。學(xué)界和業(yè)界應(yīng)該合作,通過學(xué)術(shù)資源、算力資源、商業(yè)資源的交融,把預(yù)訓(xùn)練技術(shù)往前推進(jìn)。」