杜麟,田暢,吳澤民,張兆豐,胡磊,張磊

(中國(guó)人民解放軍理工大學(xué) 通信工程學(xué)院,江蘇 南京 210007)

摘要:Q-STAR模型是現(xiàn)有的客觀視頻質(zhì)量評(píng)價(jià)中最接近主觀得分的模型,但是在解碼端難以從丟包解碼后的YUV視頻序列中提取與編碼端相一致的運(yùn)動(dòng)矢量信息,從而影響模型參數(shù)的預(yù)測(cè)。針對(duì)該問(wèn)題,提出了基于視敏度信息的模型參數(shù)預(yù)測(cè)方法,從YUV視頻序列中提取時(shí)間域和空間域視敏度特征,并結(jié)合Q-STAR模型中提取的特征進(jìn)行預(yù)測(cè)。通過(guò)實(shí)驗(yàn)發(fā)現(xiàn),使用視敏度信息代替原有的運(yùn)動(dòng)矢量信息進(jìn)行預(yù)測(cè),所得模型參數(shù)值與Q-STAR基本相符,并且計(jì)算更為簡(jiǎn)單。

關(guān)鍵詞:視頻傳輸質(zhì)量保障;主觀感知;參數(shù)預(yù)測(cè);視敏度信息

中圖分類號(hào):TN919.85文獻(xiàn)標(biāo)識(shí)碼:ADOI: 10.19358/j.issn.1674-7720.2017.01.013

引用格式:杜麟,田暢,吳澤民,等. 基于視敏度的QSTAR模型參數(shù)預(yù)測(cè)[J].微型機(jī)與應(yīng)用,2017,36(1):40-43.

0引言

視頻傳輸質(zhì)量保障的最終目的是保障接收端視頻的服務(wù)質(zhì)量,首先需要建立與人的主觀感受相一致的視頻質(zhì)量評(píng)價(jià)模型。近年來(lái),越來(lái)越多的研究著力于建立符合人眼視覺(jué)感知特性的評(píng)價(jià)指標(biāo)[12]。常見(jiàn)的方法是對(duì)主觀評(píng)價(jià)結(jié)果進(jìn)行分析,并建立相應(yīng)的模型使得評(píng)價(jià)的結(jié)果逼近真實(shí)主觀評(píng)價(jià)的結(jié)果。文獻(xiàn)[34]首先從時(shí)間域和質(zhì)量域出發(fā),分別研究了幀率以及量化步長(zhǎng)對(duì)主觀感知和碼率的影響,隨后在文獻(xiàn)[5]中加入分辨率對(duì)主觀感受的影響,并提出了聯(lián)合模型QSTAR。文獻(xiàn)[6]中提出用視敏度評(píng)估視頻質(zhì)量,用相鄰的視頻幀之間像素之差表示時(shí)間信息,用源視頻與測(cè)試視頻的時(shí)間信息差異表示視頻的損傷,并通過(guò)回歸樹(shù)的方法估計(jì)主觀得分。

本文從YUV視頻序列中提取時(shí)間域和空間域視敏度信息作為新的特征值,并進(jìn)行模型參數(shù)的預(yù)測(cè)。

1Q-STAR模型

文獻(xiàn)[5]從質(zhì)量域、時(shí)間域以及空間域三個(gè)方向出發(fā),分別研究了量化步長(zhǎng)、幀率以及分辨率對(duì)視頻主觀感知質(zhì)量的影響,從而得到了聯(lián)合的視頻主觀感知模型QSTAR,模型的計(jì)算表達(dá)式以及參數(shù)預(yù)測(cè)如下所示:

其中,q、f、s分別代表視頻的量化步長(zhǎng)、幀率以及分辨率;βq、βf、βs、v1和v2是與視頻內(nèi)容無(wú)關(guān)的常數(shù);αq、αf和s則是與視頻內(nèi)容有關(guān)的參數(shù),分別表示隨著量化步長(zhǎng)、幀率以及分辨率的變化,視頻主觀感知質(zhì)量變化的快慢;σDFD為基于運(yùn)動(dòng)估計(jì)的相鄰兩幀之間幀差均值的標(biāo)準(zhǔn)差;μFD為相鄰兩幀之間幀差均值的平均,σ為各幀像素值標(biāo)準(zhǔn)差的均值,η(μFD,σ)=μFD/σ;Gm為各幀Gabor濾波輸出值均值的平均;H為3×4的預(yù)測(cè)系數(shù)矩陣。

使用QSTAR模型對(duì)6個(gè)視頻序列(city、crew、harbour、soccer、garden和foreman)進(jìn)行參數(shù)預(yù)測(cè)。圖1為6個(gè)視頻序列的簡(jiǎn)圖。預(yù)測(cè)的結(jié)果如表1所示。表2表示用最小二乘擬合對(duì)主觀得分進(jìn)行擬合得到的模型參數(shù)值,將該數(shù)值作為模型參數(shù)預(yù)測(cè)的真實(shí)值,用于評(píng)價(jià)參數(shù)預(yù)測(cè)的好壞。(表格中視頻序列取前兩個(gè)字母表示)。

對(duì)表1中的結(jié)果進(jìn)行分析可以發(fā)現(xiàn),對(duì)于運(yùn)動(dòng)劇烈和場(chǎng)景復(fù)雜的視頻序列來(lái)說(shuō),QSTAR模型參數(shù)的預(yù)測(cè)存在較大的誤差,分析原因在于模型參數(shù)的預(yù)測(cè)中使用了特征σDFD,而σDFD是基于運(yùn)動(dòng)估計(jì)的相鄰兩幀之間幀差均值的標(biāo)準(zhǔn)差。對(duì)于運(yùn)動(dòng)劇烈和場(chǎng)景復(fù)雜的視頻序列來(lái)說(shuō),運(yùn)動(dòng)矢量信息以及殘差信息遠(yuǎn)大于其他的視頻序列,難以進(jìn)行準(zhǔn)確的運(yùn)動(dòng)估計(jì),運(yùn)動(dòng)估計(jì)的不準(zhǔn)確性導(dǎo)致運(yùn)動(dòng)補(bǔ)償之后的誤差增大,使得特征σDFD計(jì)算不準(zhǔn)確,從而造成模型參數(shù)預(yù)測(cè)的誤差。另一方面,運(yùn)動(dòng)矢量信息需要從264碼流中提取,無(wú)法直接從YUV視頻序列中得到,在視頻傳輸過(guò)程中如果發(fā)生丟包,解碼后的視頻能難得到有效的運(yùn)動(dòng)矢量信息,因此,該預(yù)測(cè)只能用于編碼端或者是無(wú)丟包條件下的視頻質(zhì)量評(píng)價(jià)。為了解決以上問(wèn)題,本文提出了一種基于視敏度的參數(shù)預(yù)測(cè)方法。

2視敏度

文獻(xiàn)[6]將視敏度[78]定義為視頻的感知質(zhì)量,并給出了一種在線計(jì)算視敏度的方法。視敏度是最基本的人眼視覺(jué)系統(tǒng)(Human Visual System,HVS)視覺(jué)處理機(jī)制,它表征了HVS對(duì)不同頻率視覺(jué)信號(hào)的響應(yīng)強(qiáng)度,主要有時(shí)域?qū)Ρ让舾卸群涂沼驅(qū)Ρ让舾卸取?/p>

時(shí)域?qū)Ρ让舾卸戎饕从沉艘曨l序列受幀率的影響,表現(xiàn)在視頻序列的連貫性上,體現(xiàn)了幀與幀之間的差別。圖2分別表示同一視頻在幀率為3.75、7.5、15以及30時(shí)相同位置連續(xù)的5幀。從圖2可以看出幀率越大,幀與幀之間的差別較小,視頻序列的連貫性越好;而幀率越小,幀與幀之間差別較大,造成視頻序列的不連貫,出現(xiàn)“跳躍”的現(xiàn)象。

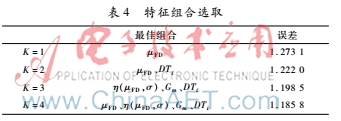

用時(shí)域信息Ti表示時(shí)域?qū)Ρ让舾卸龋琓i的計(jì)算表達(dá)式如下:

![$6PV2GUXS]B(J65F4[UO2UO.png $6PV2GUXS]B(J65F4[UO2UO.png](http://files.chinaaet.com/images/2017/03/02/6362407312001246987636652.png)

其中H和W分別代表視頻的高度和寬度;c代表顏色深度;Fn(i,j)代表視頻第n幀圖像中位于位置(i,j)的像素值;N代表視頻的幀數(shù)。

空域?qū)Ρ让舾卸戎饕芊直媛视绊懀w現(xiàn)在視頻序列的尺寸上,圖3分別表示了同一視頻在兩種分辨率下相同位置的幀。從圖3中可以看出分辨率越大,人眼的主觀感受越好;分辨率越小,越容易造成主觀感受的下降。

用空域信息Si表示空域?qū)Ρ让舾卸龋琒i的計(jì)算表達(dá)式如下:

為了解決模型參數(shù)預(yù)測(cè)中運(yùn)動(dòng)矢量信息的問(wèn)題,分別計(jì)算了源視頻時(shí)域信息Tio以及空域信息Sio和測(cè)試視頻的時(shí)域信息Tit以及空域信息Sit,并把時(shí)域信息和空域信息的變化DTi和DSi作為新的特征,特征計(jì)算如下:

![}5LJ%]4PXX%[}V594N}CC5Y.png }5LJ%]4PXX%[}V594N}CC5Y.png](http://files.chinaaet.com/images/2017/03/02/6362407314276413266419741.png)

3模型參數(shù)預(yù)測(cè)

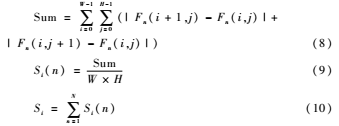

為了用盡可能少的特征組合進(jìn)行模型參數(shù)的預(yù)測(cè),本文采用文獻(xiàn)[5]所用的交叉驗(yàn)證法驗(yàn)證各個(gè)特征對(duì)模型參數(shù)的影響。從視頻序列提取的特征如表3所示。交叉驗(yàn)證法的基本思想是每次實(shí)驗(yàn)隨機(jī)選取一個(gè)視頻序列做為測(cè)試序列,其余的視頻序列用于訓(xùn)練,記P⌒=[α⌒s,αf,αq]T、F=[1,f1,f2,…,fK]T,則預(yù)測(cè)方程為=HF,其中K為選擇特征的個(gè)數(shù)。從K=1開(kāi)始,選擇不同的特征使得擬合誤差∑mm-Pm2最小,其中m為訓(xùn)練視頻序列的個(gè)數(shù)。逐漸增大K值直到擬合誤差沒(méi)有顯著的變化為止,從而得到最佳的特征組合F和預(yù)測(cè)矩陣H。表3視頻特征描述特征符號(hào)表示FDμFDSTDσNFDη(μFD,σ)=μFD/σGaborGmTiDTiSiDSi從6個(gè)視頻序列中選取5個(gè)用于訓(xùn)練,剩下一個(gè)視頻序列用于測(cè)試,求取預(yù)測(cè)結(jié)果與最小二乘擬合值之間的誤差,通過(guò)誤差大小進(jìn)行特征組合的選取,表4表示了不同個(gè)數(shù)特征組合下最佳的特征組合以及其最小誤差。

通過(guò)表4可以看出,當(dāng)K=4時(shí)誤差最小,而K=3時(shí)的誤差與K=4時(shí)僅相差0.013,因此,選擇DTi、η(μFD,σ)和Gm三種特征進(jìn)行模型參數(shù)的預(yù)測(cè),預(yù)測(cè)方程如式(12)所示。

![1F~%N({0Q13G]X38N93BWE0.png 1F~%N({0Q13G]X38N93BWE0.png](http://files.chinaaet.com/images/2017/03/02/6362407316195304076501961.png)

4實(shí)驗(yàn)結(jié)果

實(shí)驗(yàn)仿真平臺(tái)為MATLAB 2010b。對(duì)city、crew、harbour、soccer、garden和foreman 6個(gè)視頻進(jìn)行測(cè)試。本文采用H.264編碼標(biāo)準(zhǔn)進(jìn)行編碼,編碼的結(jié)構(gòu)為IPPP,GOP長(zhǎng)度為25,QP取值為28、32、36、40和44,幀率取值為3.75、7.5、15和30。在視頻傳輸過(guò)程中分辨率通常保持不變,因此,實(shí)驗(yàn)中選取標(biāo)準(zhǔn)視頻庫(kù)中352×288的視頻序列進(jìn)行測(cè)試,并將QP為28、幀率為30的編碼視頻序列作為學(xué)習(xí)的視頻序列,從該學(xué)習(xí)視頻序列中提取所需要的特征進(jìn)行模型參數(shù)的預(yù)測(cè)。預(yù)測(cè)結(jié)果如表5所示。由于不考慮分辨率的變化,因此也不考慮模型參數(shù)s的預(yù)測(cè)結(jié)果。重點(diǎn)比較模型參數(shù)αq,通過(guò)對(duì)表1、表2和表5的分析可以看出,在對(duì)模型參數(shù)αq的預(yù)測(cè)中,本文提出的預(yù)測(cè)方法普遍優(yōu)于QSTAR的預(yù)測(cè)結(jié)果。而在對(duì)模型參數(shù)αf的預(yù)測(cè)中,發(fā)現(xiàn)對(duì)于運(yùn)動(dòng)劇烈和場(chǎng)景復(fù)雜的視頻序列,如harbour、soccer,本文提出的預(yù)測(cè)方法比QSTAR的預(yù)測(cè)結(jié)果更優(yōu),但是對(duì)于運(yùn)動(dòng)平緩和場(chǎng)景簡(jiǎn)單的視頻序列,如crew和garden而言,本文提出的預(yù)測(cè)方法比QSTAR的預(yù)測(cè)結(jié)果稍差,原因在于對(duì)于此類視頻,運(yùn)動(dòng)估計(jì)較為準(zhǔn)確,運(yùn)動(dòng)補(bǔ)償之后得到的特征σDFD更準(zhǔn)確,所以預(yù)測(cè)的結(jié)果更接近于最小二乘擬合的結(jié)果。在傳輸過(guò)程中,通常采用固定的幀率,且?guī)蚀笥?5 fps,視頻主觀感知質(zhì)量受QP的影響最大,并且QSTAR模型的預(yù)測(cè)需要從264碼流提取運(yùn)動(dòng)矢量信息,而本文提出的基于視敏度的QSTAR模型利用視敏度信息代替運(yùn)動(dòng)矢量信息能達(dá)到相同的效果,誤差在可接受范圍內(nèi),因此,本文提出的方法更優(yōu)。

5結(jié)論

網(wǎng)絡(luò)視頻應(yīng)用越來(lái)越普及,保障用戶的體驗(yàn)是首要目的,基于PSNR的端到端失真估計(jì)保護(hù)以最小化失真為目標(biāo),如文獻(xiàn)[9]。而人眼視覺(jué)系統(tǒng)的復(fù)雜性決定了該保護(hù)與人眼感知的差異,基于主觀感知評(píng)價(jià)的視頻傳輸保障成為近年來(lái)研究的熱點(diǎn)。本文基于視敏度對(duì)現(xiàn)有的主觀感知模型QSTAR中模型參數(shù)進(jìn)行了重新預(yù)測(cè),提高了模型參數(shù)αq的預(yù)測(cè)準(zhǔn)確度,并解決了運(yùn)動(dòng)劇烈和場(chǎng)景復(fù)雜的視頻序列中模型參數(shù)s和αf預(yù)測(cè)誤差較大的問(wèn)題,但是對(duì)于運(yùn)動(dòng)平緩和場(chǎng)景簡(jiǎn)單的視頻序列中模型參數(shù)的預(yù)測(cè)準(zhǔn)確度有待提高。同時(shí),模型參數(shù)的預(yù)測(cè)所需的視頻特征僅僅通過(guò)YUV視頻序列本身進(jìn)行提取,不需要相應(yīng)的264碼流,在傳輸分組丟失的情況下,接收端無(wú)需重新估計(jì)運(yùn)動(dòng)矢量信息,在盡可能保障模型參數(shù)預(yù)測(cè)準(zhǔn)確度的同時(shí)使得計(jì)算更為簡(jiǎn)單,可有效地用于視頻質(zhì)量評(píng)價(jià)和視頻傳輸端到端的保障。

參考文獻(xiàn)

[1] 蔣剛毅, 朱亞培, 郁梅, 等. 基于感知的視頻編碼方法綜述[J]. 電子與信息學(xué)報(bào), 2013, 35(2): 474-483.

[2] LEE J, EBRAHIMI T. Perceptual video compression: a survey[J]. IEEE Journal of Selected Topics in Signal Processing, 2012, 6(6): 684-697.

[3] OU Y F, MA Z, LIU T, et al. Perceptual quality assessment of video considering both frame rate and quantization artifacts[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2011, 21(3): 286-298.

[4] MA Z, XU M, OU Y F, et al. Modeling of rate and perceptual quality of compressed video as functions of frame rate and quantization stepsize and its applications[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2012, 22(5): 671-682.

[5] OU Y F, XUE Y, WANG Y. QSTAR: a perceptual video quality model considering impact of spatial, temporal, and amplitude resolutions[J]. IEEE Transactions on Image Processing, 2014, 23(6): 2473-2486.

[6] BAIK E, PANDE A, STOVER C, MOHAPATRA P. Video acuity assessment in mobile devices[C]. 2015 IEEE Conference in Computer Communications (INFOCOM), HONG KONG, 2015: 19.

[7] LIN W, KUO C C J. Perceptual visual quality metrics: a survey[J]. Journal of Visual Communication & Image Representation, 2011, 22(4):297-312.

[8] BALACHANDRAN A, SEKAR V, AKELLA A, et al. Developing a predictive model of quality of experience for internet video[J]. ACM SIGCOMM Computer Communication Review, 2013, 43(4): 339-350.

[9] LI C, XIONG H, WU D. Delayratedistortion optimized rate control for endtoend video communication over wireless channels[J]. IEEE Transactions on Circuits & Systems for Video Technology, 2015, 25(10):1665-1681.