摘 要: 針對未知非結(jié)構(gòu)化室內(nèi)環(huán)境中雙目視覺機器人路標特征匹配的問題進行了研究,,提出了基于改進自組織映射網(wǎng)絡(luò)(Self-Organizing Map,SOM)的雙目視覺特征點快速匹配方法。對雙目視覺獲取的環(huán)境圖像提取SIFT特征向量作為改進SOM的輸入,,利用獲勝者計算技術(shù)完成對輸入SIFT特征點的快速匹配,SOM競爭學(xué)習(xí)過程中用街區(qū)距離與棋盤距離的線性組合作為相似性度量函數(shù),。實驗結(jié)果表明,,所提方法在路標特征匹配的時間和效果上優(yōu)于傳統(tǒng)SIFT和SURF特征匹配的方法,且能滿足實時性要求,。

關(guān)鍵詞: 無監(jiān)督競爭學(xué)習(xí),;特征匹配;雙目視覺,;自組織映射網(wǎng)絡(luò)

0 引言

在未知室內(nèi)環(huán)境中,移動機器人對自身與環(huán)境的精確定位是實現(xiàn)自主導(dǎo)航的前提和基礎(chǔ)[1],,而雙目視覺可以獲取更完整的環(huán)境信息,、探測范圍更廣,匹配雙目圖像顯著的特征點作為路標[2],,構(gòu)建機器人的環(huán)境地圖是移動機器人實現(xiàn)自主導(dǎo)航的基礎(chǔ),。

大多研究人員提出的算法主要是研究如何確定興趣點和其相鄰區(qū)域以及如何提取特征點的描述符向量。近些年不斷有新的匹配算法被提出,,參考文獻[3]中提出對旋轉(zhuǎn),、尺度縮放,、亮度變化保持不變性的局部特征描述方法(Scale Invariant Feature Transform,,SIFT),。該算法復(fù)雜度高,,提取大量的局部特征點集,導(dǎo)致圖像處理過程很慢,,不能滿足實時要求,。參考文獻[4]提出Harris-SIFT算法,用Harris角點代替SIFT算法的多尺度空間極值檢測,,生成SIFT特征描述子用在雙目圖像對的匹配上,。但該算法失去了SIFT算法對于尺度縮放保持不變的特性。參考文獻[5]改進了參考文獻[4]的Harris-SIFT算法,,保持了SIFT特性,。采用Best Bin First(BBF)來減少匹配搜索的復(fù)雜度,,提高了匹配速度。

本文提出一種SIFT特征向量提取與SOM競爭學(xué)習(xí)技術(shù)相結(jié)合的特征點快速匹配方法,,大大減少了檢測時間,。實驗表明,所提算法對特征點匹配的速度與效果優(yōu)于傳統(tǒng)SIFT和SURF匹配算法[6-7],,滿足移動機器人的實時性要求,。

1 特征點提取

雙目立體視覺系統(tǒng)由參數(shù)相同的兩個攝像頭組成,令兩個攝像頭的光軸互相平行且與透視投影平面垂直,,要求同步曝光及圖像質(zhì)量一致,。獲取的左、右目圖像分別記為IL,、IR,。分別對IL、IR提取SIFT特征點,,每一個特征點對應(yīng)一個描述符特征向量,。描述符向量使用4×4的16個種子點來描述,通過高斯加權(quán)后歸入8個方向直方圖,,獲得一個4×4×8的128維SIFT特征描述子,。由IL、IR提取的特征點組成的集合分別記為FL,、FR,,隨后作為自組織映射網(wǎng)絡(luò)(SOM)的輸入進行特征點的快速匹配。

2 自組織映射網(wǎng)絡(luò)(SOM)分析

基于Kohonen神經(jīng)網(wǎng)絡(luò)的SOM方法是一種無監(jiān)督競爭學(xué)習(xí)的神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)算法[8-9],。

設(shè)輸入變量集合X={x1,,x2,…,,xk}∈Rn,,權(quán)重系數(shù)W={wi1,wi2,,…,,win}∈Rn。隨機選取W的初始值,,將輸入特征模式向量X輸入到SOM輸入層處理單元中,,當網(wǎng)絡(luò)得到一個新的輸入模式向量時,競爭層的所有神經(jīng)元對應(yīng)的關(guān)聯(lián)權(quán)向量均與其進行相似性比較,并將最相似的權(quán)向量判為競爭獲勝神經(jīng)元,,由式(1)可以得到獲勝單元,。

在訓(xùn)練過程中,以獲勝神經(jīng)元為中心設(shè)定一個鄰域半徑,,稱為優(yōu)勝鄰域,。優(yōu)勝鄰域內(nèi)的節(jié)點也會彼此激發(fā)學(xué)習(xí)一個相同的輸入向量X,優(yōu)勝鄰域Nj*(t)內(nèi)的所有神經(jīng)元節(jié)點由式(2)進行權(quán)值調(diào)整,。

其中,,(t)為學(xué)習(xí)率因子(0<(t)<1),優(yōu)勝鄰域開始定得很大,,但隨著訓(xùn)練次數(shù)的增加,,優(yōu)勝鄰域會不斷收縮,最終收縮到半徑為零,。

3 改進SOM的特征點匹配

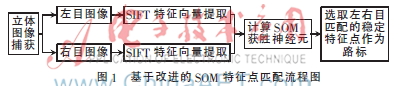

傳統(tǒng)SIFT和SURF的特征匹配算法復(fù)雜度高,,圖像匹配效率低,不能滿足實時性要求,。本文運用改進的SOM網(wǎng)絡(luò)完成雙目圖像特征點的快速匹配,,加快特征點的匹配速度?;诟倪MSOM的特征點匹配流程圖如圖1所示,。

修改后的算法把特征點匹配問題轉(zhuǎn)換成一個圖像的每個特征點與對應(yīng)的另一圖像特征點間立體映射的估計,所提算法選取街區(qū)距離LJ與棋盤距離LQ的線性組合代替歐氏距離Lo,,可知計算LJ和LQ比Lo簡單很多,,而且LQ≤Lo≤LJ,所以本文用LQ+LJ替代Lo,,作為相似性度量函數(shù),,減少了計算量,從而提高計算速度,。

修改后的SOM特征點匹配步驟如下:

![`Y(YR0WZG0F~0WH]6QBGVM9.jpg `Y(YR0WZG0F~0WH]6QBGVM9.jpg](http://files.chinaaet.com/images/2016/01/04/6358750299179000003730744.jpg)

完成以上步驟后就完成了雙目圖像之間的特征點匹配,。為了進一步提高匹配的準確率,使用極線幾何約束,、視差約束,、有序性約束以及唯一性約束條件消除錯誤的匹配點。

4 實驗與結(jié)果分析

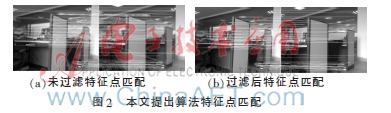

本文使用旅行家2號機器人作為實驗平臺,,兩個攝像頭之間的基線長20 cm,。對獲取到的圖像分別使用SIFT和SURF特征匹配方法以及所提算法進行特征點匹配。圖2(a)為所提算法未使用約束條件進行特征點匹配的實驗結(jié)果,,圖2(b)為約束條件過濾后的匹配結(jié)果,。

從圖2可以發(fā)現(xiàn),,未使用約束條件過濾前有明顯的誤配點,使用極線幾何約束,、視差約束等約束條件可以剔除大量的錯誤匹配點,提高匹配的準確度,。圖3為實驗仿真對比結(jié)果,,可以看出所提算法在匹配數(shù)量與時間上優(yōu)于傳統(tǒng)算法。獲取大量圖像對所提算法進行實驗評估,,統(tǒng)計運行耗時和特征點匹配數(shù)量如圖4,、圖5所示。

本文用SIFT算法提取雙目圖像的特征點集作為SOM的輸入,,減少了檢測時間,。使用棋盤距離和街區(qū)距離的線性組合代替歐式距離作為相似度量函數(shù),大大降低了計算量,,減少了計算時間,。使用獲勝者計算技術(shù)保證了特征點的數(shù)量。

實驗結(jié)果表明,,所提算法在實驗室環(huán)境下對雙目圖像特征點的匹配速度更快,,且匹配的特征點數(shù)量穩(wěn)定,可以滿足機器人導(dǎo)航實時性的要求,。

5 結(jié)論

SIFT算法具有尺度,、旋轉(zhuǎn)、視角和光照不變性,,但由于復(fù)雜性高,、效率低等達不到實時性的理想效果。本文使用SIFT特征點向量與改進的SOM相結(jié)合的無監(jiān)督競爭學(xué)習(xí)算法,,對雙目圖像特征點完成快速匹配,。實驗結(jié)果表明,所提算法在實驗室環(huán)境下對雙目圖像特征點的匹配有較好的實驗效果,,可以快速,、準確地匹配穩(wěn)定的特征點。在未來的工作中,,將在本文所提算法的基礎(chǔ)上,,進行雙目視覺機器人實時定位與地圖構(gòu)建(Simultaneous Localization and Mapping,SLAM)[10]的研究,。

參考文獻

[1] 林睿.基于圖像特征點的移動機器人立體視覺SLAM研究[D].哈爾濱:哈爾濱工業(yè)大學(xué),,2011.

[2] 王璐,蔡自興.未知環(huán)境中基于視覺顯著性的自然路標檢測[J].模式識別與人工智能,,2006,,19(1):100-105.

[3] LOWE D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision,, 2004, 60(2):91-110.

[4] 趙欽君,,趙東標,,韋虎.Harris-SIFT算法及其在雙目立體視覺中的應(yīng)用[J].電子科技大學(xué)學(xué)報,2010,,39(4):546-550.

[5] 王民,,劉偉光.基于改進SIFT特征的雙目圖像匹配算法[J].計算機工程與應(yīng)用,2013,,49(2):203-206.

[6] 常青,,張斌,邵金玲.基于SIFT和RANSAC的特征圖像匹配方法[J].華東理工大學(xué)學(xué)報(自然科學(xué)版),,2012,,38(6):747-751.

[7] 陳小丹,杜宇人,,高秀斌.一種基于SURF的圖像特征點快速匹配算法[J].揚州大學(xué)學(xué)報(自然科學(xué)版),,2012,15(4):64-67.

[8] KOHONEN T. Self-organizing maps[J]. Springer,, 1995,,11(3):340-349.

[9] 楊占華,楊燕.SOM神經(jīng)網(wǎng)絡(luò)算法的研究與進展[J].計算機工程,,2006,,32(16):201-203.

[10] 蘇立.室內(nèi)環(huán)境下移動機器人雙目視SLAM研究[D].西安:西安理工大學(xué),2010.