2025年6月30日,華為正式宣布開源盤古7B參數的稠密模型、盤古Pro MoE 72B混合專家模型和基于昇騰的模型推理技術。隨后一項由@HonestAGI 發(fā)布于GitHub的針對盤古大模型的研究引發(fā)業(yè)界熱議,該研究的作者認為,華為推出的盤古大模型(Pangu Pro MoE)與阿里巴巴發(fā)布的通義千問Qwen-2.5 14B模型在參數結構上存在高相似度。

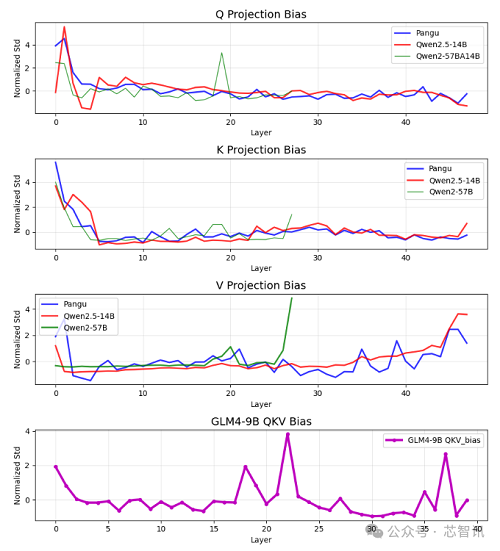

HonestAGI 通過測試比較稱,Pangu Pro MoE模型與Qwen-2.5 14B模型在注意力參數分布上的平均相關性高達0.927,遠超其他模型對比的正常范圍(業(yè)內同類模型對比通常不超過0.7)。

由于深度學習模型的訓練具有高度隨機性,涉及復雜的數據采樣、權重初始化及優(yōu)化路徑。兩個模型在眾多注意力參數上呈現近乎一致的分布,其自然發(fā)生的概率極低。因此,這種極高的相似度,立即引發(fā)其涉嫌“抄襲”的質疑。

隨后,有自稱是盤古大模型團隊的人在GitHub上進行了回應,否認抄襲指控,并且認為該作者的評估方法不科學。

該用戶表示,使用論文中描述的方法,評估了以下模型比較:

pangu-72b-a16b vs. Qwen2.5-14b = 0.92

baichuan2-13b vs. Qwen1.5-14b = 0.87

baichuan2-13b vs. pangu-72b-a16b = 0.84

baichuan2-13b vs. Qwen2.5-14b = 0.86

可以看到不同其他相近參數規(guī)模的模型在該評估方法下也得到了與Qwen-2.5 14B模型高度相似的結果。這表明該論文和指標缺乏實際意義。盤古團隊進一步并重申沒有抄襲。

對于該回應,HonestAGI 表示,其無法信服盤古大模型團隊的說法。HonestAGI 稱,“盤古仍然顯示出最高的相似度,對吧?我們很高興看到您成功復現了我們的結果!事實上,任何分類問題都有一個閾值來識別決策邊界(例如,本例中疑似值為0.9)。這主要是一個用于初步比較的工具,而盤古‘不幸地’在我們開始進一步調查之前觸發(fā)了這個警告信號。我們并非僅僅基于注意力參數就做出判斷。這只是動機。……”

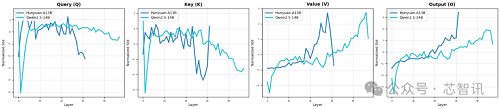

隨后,HonestAGI 還提供了 Qwen 和 Hunyuan A13B 之間的比,結果顯示二者在不同層級上展現出截然不同的內部模式,這表明它們擁有截然不同的架構和學習到的表征。顯然,HonestAGI提供該對比數據是想說明其測試方法沒有問題。

不過,目前HonestAGI似乎已經下線了之前關于盤古大模型的研究報告。但是,HonestAGI 在最新的回應中表示,“我們計劃在論文最終定稿并提交所有代碼后,將其提交給同行評審會議(可能是 ICLR 或之后的會議?)。”

另外,值得注意但是,通過查詢盤古大模型團隊官方發(fā)布在國內代碼托管平臺Gitcode(類似國外的Github)的“盤古Pro”大模型代碼,可以發(fā)現其“'Open Source Software Notice”當中的赫然出現了關于“transformers”組件的版權聲明“Copyright notice:Copyright 2024 The Qwen team, Alibaba Group and the HuggingFace Team. All rights reserved.” 顯然這段說明的意思是,其所用到的“transformers”組件的版權所有人是Qwen團隊、阿里巴巴集團和HuggingFace團隊。

需要指出的是,該代碼是由“Ascend Tribe”——盤古大模型團隊官方發(fā)布,并不是其他第三方進行發(fā)布的。由此也有不少網友認為這是“實錘”抄襲的證據。

不過,業(yè)內人士表示,這是一份標準的開源聲明,當盤古大模型團隊使用了第三方開發(fā)的開源軟件時,根據開源許可要求,是必須需要向用戶說明的法律義務。而在這份聲明當中,只能表明盤古大模型當中用了阿里巴巴Qwen團隊 和 HuggingFace共同開發(fā)的“transformers”組件,并且使用的是“Apache License 2.0”協議。該協議它允許任何人自由地使用、修改和分發(fā)該軟件,甚至用于商業(yè)產品中。所以,這份聲明只反應了盤古大模型團隊用了一些開源代碼,并且遵守了開源協議,并不能證明抄襲。

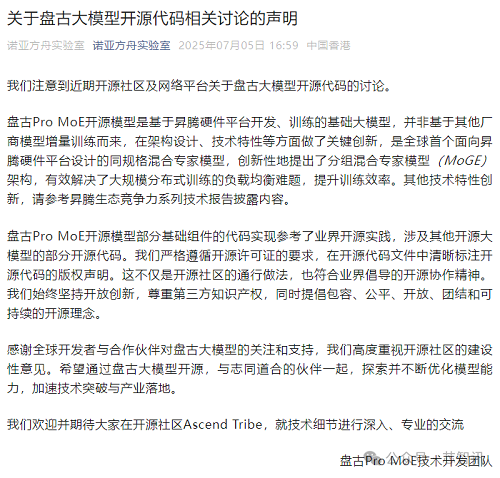

盤古大模型團隊正式回應

7月5日下午16:59分,隸屬于華為的負責開發(fā)盤古大模型的諾亞方舟實驗室發(fā)布聲明對于“抄襲”指控進行了官方回應。

諾亞方舟實驗室表示,盤古Pro MoE開源模型是基于昇騰硬件平臺開發(fā)、訓練的基礎大模型,并非基于其他廠商模型增量訓練而來,在架構設計、技術特性等方面做了關鍵創(chuàng)新,是全球首個面向昇騰硬件平臺設計的同規(guī)格混合專家模型,創(chuàng)新性地提出了分組混合專家模型(MoGE)架構,有效解決了大規(guī)模分布式訓練的負載均衡難題,提升訓練效率。

不過,諾亞方舟實驗室也承認,“盤古Pro MoE開源模型部分基礎組件的代碼實現參考了業(yè)界開源實踐,涉及其他開源大模型的部分開源代碼。我們嚴格遵循開源許可證的要求,在開源代碼文件中清晰標注開源代碼的版權聲明。這不僅是開源社區(qū)的通行做法,也符合業(yè)界倡導的開源協作精神。我們始終堅持開放創(chuàng)新,尊重第三方知識產權,同時提倡包容、公平、開放、團結和可持續(xù)的開源理念。”

此外,芯智訊發(fā)現,有百度貼吧網友爆料稱,負責盤古大模型的開發(fā)的諾亞方舟負責人王云鶴在內網也針對此事做了回應,回應內容的核心是兩個:1、盤古大模型是基于昇騰芯片進行訓練的,與Qwen所用的訓練硬件是不同的;2、盤古大模型當中所使用的Llama和Qwen的組件都是已經開源的,并不是抄襲。

總結來看,目前尚無證據證實盤古大模型存在抄襲阿里Qwen的“實錘”證據,HonestAGI 所發(fā)布的質疑論文所采用的測試方法的可靠性也有待進一步驗證,畢竟其并未完全公開其測試代碼,更何況HonestAGI 已經下線了之前的質疑論文。至于盤古大模型當中確實有采用Qwen的開源代碼,但這部分的代碼本就是開源代碼,盤古大模型團隊的相關的聲明做法也是合規(guī)的,只能說盤古大模型并不是從零起步的絕對原創(chuàng),如果只是用了部分開源組件,也并不屬于抄襲。