5 月 30 日消息,阿里巴巴昨日在 Github 上開源了其創(chuàng)新的自主搜索 AI Agent——WebAgent,具備端到端的自主信息檢索與多步推理能力,能夠像人類一樣在網(wǎng)絡(luò)環(huán)境中主動(dòng)感知、決策和行動(dòng)。

例如,當(dāng)用戶想了解某個(gè)特定領(lǐng)域的最新研究成果時(shí),WebAgent 能夠主動(dòng)搜索多個(gè)學(xué)術(shù)數(shù)據(jù)庫,篩選出最相關(guān)的文獻(xiàn),并根據(jù)用戶的需求進(jìn)行深入分析和總結(jié)。

據(jù)介紹,WebAgent 不僅能識(shí)別文獻(xiàn)中的關(guān)鍵信息,還能通過多步推理將不同文獻(xiàn)中的觀點(diǎn)進(jìn)行整合,最終為用戶提供一份全面且精準(zhǔn)的研究報(bào)告。

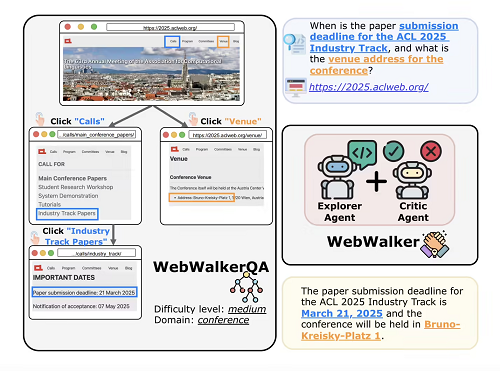

阿里巴巴 WebAgent 分為 WebDancer 和 WebWalker,前者是一種端到端智能體訓(xùn)練框架,旨在增強(qiáng)基于網(wǎng)絡(luò)的 AI 智能體的多步驟信息搜索能力;后者則屬于“Web 遍歷中的 LLM 基準(zhǔn)測試”。

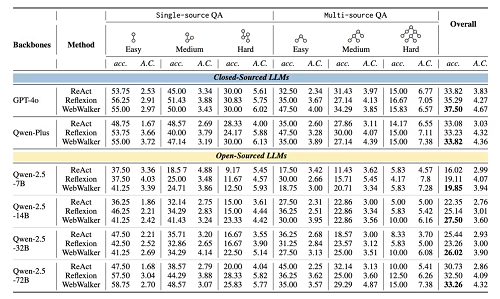

Web Agents 上的性能:

WebDancer 的框架一共由 4 大塊組成,從數(shù)據(jù)構(gòu)建到訓(xùn)練優(yōu)化,逐步打造出能夠自主完成復(fù)雜信息檢索任務(wù)的智能體。

瀏覽數(shù)據(jù)構(gòu)建是整個(gè)框架的起點(diǎn)。在現(xiàn)實(shí)世界中,高質(zhì)量的訓(xùn)練數(shù)據(jù)是智能體能夠有效學(xué)習(xí)和泛化的關(guān)鍵。WebDancer 通過兩種創(chuàng)新的數(shù)據(jù)合成方法來解決傳統(tǒng)數(shù)據(jù)集的局限性。

為了確保生成的軌跡既有效又連貫,WebDancer 采用了短推理和長推理兩種方法。短推理利用大模型直接生成簡潔的推理路徑,而長推理則通過推理模型逐步構(gòu)建復(fù)雜的推理過程。

在數(shù)據(jù)準(zhǔn)備完成后,WebDancer 進(jìn)入監(jiān)督微調(diào)(SFT)階段。這一階段的目標(biāo)是通過高質(zhì)量的軌跡數(shù)據(jù)對智能體進(jìn)行初始化訓(xùn)練,使其能夠適應(yīng)信息檢索任務(wù)的格式和環(huán)境要求。

在 SFT 過程中,WebDancer 將軌跡中的思考、行動(dòng)和觀察內(nèi)容分別標(biāo)記,并計(jì)算損失函數(shù),以優(yōu)化模型的參數(shù)。為了提高模型的魯棒性,WebDancer 在計(jì)算損失時(shí)排除了外部反饋的影響,確保模型能夠?qū)W⒂谧灾鳑Q策過程。這一階段的訓(xùn)練為智能體提供了強(qiáng)大的初始能力,使其能夠在后續(xù)的強(qiáng)化學(xué)習(xí)階段更好地適應(yīng)復(fù)雜的任務(wù)環(huán)境。

強(qiáng)化學(xué)習(xí)(RL)階段是 WebDancer 框架的關(guān)鍵環(huán)節(jié)。在這一階段,智能體通過與環(huán)境的交互,學(xué)習(xí)如何在復(fù)雜的任務(wù)中做出最優(yōu)決策。WebDancer 采用了 DAPO 算法,這是一種專門針對智能體訓(xùn)練設(shè)計(jì)的強(qiáng)化學(xué)習(xí)算法。

DAPO 算法通過動(dòng)態(tài)采樣機(jī)制,有效利用未充分利用的 QA 對,提高數(shù)據(jù)效率和策略的魯棒性。在 RL 過程中,智能體通過多次嘗試和反饋,逐步優(yōu)化其決策策略,最終實(shí)現(xiàn)高效的多步推理和信息檢索能力。