大家過年期間刷手機(jī)的時(shí)候,是不是感覺被DeepSeek“霸屏” 了?這款語(yǔ)言模型,一經(jīng)發(fā)布直接在全球范圍內(nèi)爆火,成為頂流,在熱搜上更是牢牢占據(jù)一席之地。無(wú)論是技術(shù)大神,還是緊跟潮流的技術(shù)小白,都被它強(qiáng)大的自然語(yǔ)言處理能力狠狠吸引,誰(shuí)不想趕緊上手體驗(yàn)一把呢?

作為openKylin系統(tǒng)的用戶,千萬(wàn)不要錯(cuò)過這波專屬福利———一份超詳細(xì)的在openKylin系統(tǒng)上本地部署并運(yùn)行DeepSeek-R1開源模型的安裝指南。手把手教學(xué),包教包會(huì),讓你輕松開啟這場(chǎng)超燃的技術(shù)探索之旅,趕緊跟著教程操作起來(lái)!

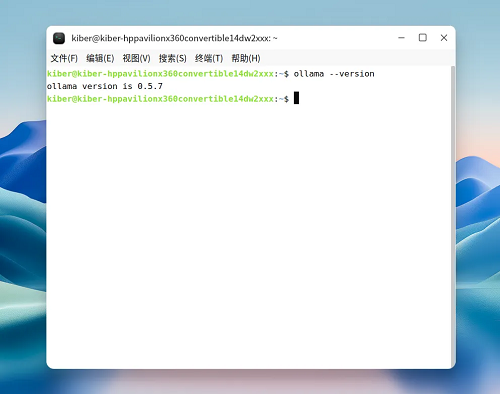

第一步:下載并安裝ollama

·方式一:

按照ollama官網(wǎng)的下載指南,執(zhí)行如下命令:

curl -fsSL https://ollama.com/install.sh | sh

·方式二:

前往github平臺(tái)ollama項(xiàng)目自行下載后解壓:

https://github.com/ollama/ollama/releases/tag/v0.5.7

執(zhí)行如下命令進(jìn)行解壓縮:

sudo tar -C /usr -xzf ollama-linux-amd64.tgz

·方式三:

如以上兩種方式因網(wǎng)絡(luò)原因均無(wú)法成功下載,可通過關(guān)注openKylin公眾號(hào),回復(fù)ollama,獲取百度網(wǎng)盤鏈接進(jìn)行下載。

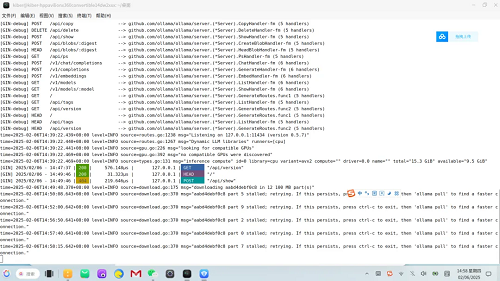

第二步:?jiǎn)?dòng)ollama服務(wù)

執(zhí)行如下命令啟動(dòng)ollama服務(wù):

ollama serve

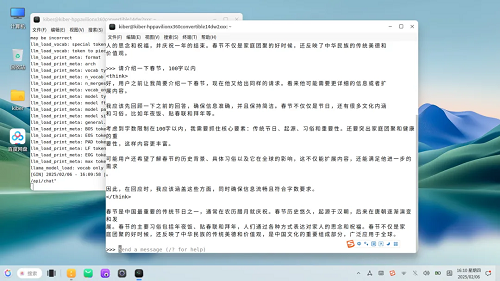

然后打開一個(gè)新的終端窗口,查看是否已啟動(dòng)成功,如下圖所示:

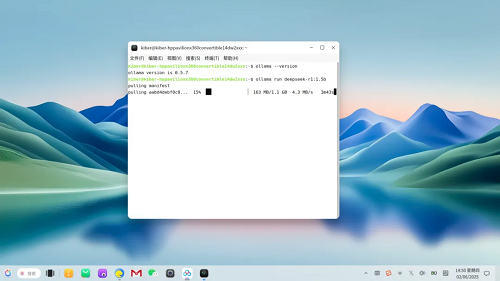

第三步:下載并安裝運(yùn)行DeepSeek-R1模型

執(zhí)行如下命令下載并安裝運(yùn)行DeepSeek-R1 1.5b模型:

ollama run deepseek-r1:1.5b

注意:本次演示以1.5b模型為例,若您的電腦性能更高,可下載安裝DeepSeek-R1更高規(guī)格的模型,效果更好哦!具體官方命令如下:

DeepSeek-R1-Distill-Qwen-1.5B

ollama run deepseek-r1:1.5b

DeepSeek-R1-Distill-Qwen-7B

ollama run deepseek-r1:7b

DeepSeek-R1-Distill-Llama-8B

ollama run deepseek-r1:8b

DeepSeek-R1-Distill-Qwen-14B

ollama run deepseek-r1:14b

DeepSeek-R1-Distill-Qwen-32B

ollama run deepseek-r1:32b

DeepSeek-R1-Distill-Llama-70B

ollama run deepseek-r1:70b

至此,已完成DeepSeek-R1模型的部署,接下來(lái)我們來(lái)問它一個(gè)問題測(cè)試一下:

可以看到,基于openKylin開源操作系統(tǒng)本地部署的DeepSeek-R1 1.5b模型,在較短時(shí)間內(nèi)即可給出它的分析過程及最終答案。

通過以上的步驟,我們成功在openKylin上完成了DeepSeek-R1開源模型的本地部署與運(yùn)行。希望大家在嘗試的過程中,不斷挖掘這兩者結(jié)合的潛力,在各自的領(lǐng)域中實(shí)現(xiàn)更多創(chuàng)新。如果你在操作過程中有任何疑問或心得,歡迎在評(píng)論區(qū)留言分享,讓我們共同推動(dòng)開源技術(shù)與人工智能的發(fā)展!OpenAtom openKylin是由開放原子開源基金會(huì)孵化及運(yùn)營(yíng)的開源項(xiàng)目,由基礎(chǔ)軟硬件企業(yè)、非營(yíng)利性組織、社團(tuán)組織、高等院校、科研機(jī)構(gòu)和個(gè)人開發(fā)者共同創(chuàng)立。

社區(qū)以“為世界提供與人工智能技術(shù)深度融合的開源操作系統(tǒng)”為愿景,旨在于開源、自愿、平等、協(xié)作的基礎(chǔ)上,共同打造全球領(lǐng)先的智能桌面開源操作系統(tǒng)根社區(qū),推動(dòng)Linux開源技術(shù)及其軟硬件生態(tài)繁榮發(fā)展。