【ChatGPT專題】OpenAI新老員工對(duì)決!「叛徒」團(tuán)隊(duì)發(fā)布Claude模型:ChatGPT的RLHF過(guò)時(shí)啦!

2023-02-17

來(lái)源:新智元

ChatGPT發(fā)布后可謂是一時(shí)無(wú)兩,但隨著技術(shù)的再次發(fā)展,挑戰(zhàn)者也開(kāi)始多了起來(lái),有些聊天機(jī)器人的生成能力甚至比ChatGPT更強(qiáng)。

這次的挑戰(zhàn)者Claude,其背后的Anthropic公司正是由兩年前離職OpenAI的團(tuán)隊(duì)創(chuàng)辦的,其底層技術(shù)RLAIF有別于ChatGPT的RLHF,無(wú)需人類反饋即可消除機(jī)器人的種族歧視、性別歧視等有害內(nèi)容。

Claude模型在文本內(nèi)容生成上也優(yōu)于ChatGPT,甚至還通過(guò)了美國(guó)大學(xué)的法律和經(jīng)濟(jì)學(xué)考試。不過(guò)在代碼生成任務(wù)上仍然弱于ChatGPT。

OpenAI新老員工對(duì)決

2020年底,OpenAI前研究副總裁Dario Amodei帶著10名員工加入了「硅谷叛徒」俱樂(lè)部,拿著1.24億美元投資創(chuàng)辦了一個(gè)全新的人工智能公司Anthropic,打算重拾OpenAI的初心。

Dario博士畢業(yè)于普林斯頓大學(xué),他是 OpenAI 的早期員工之一,也被認(rèn)為是深度學(xué)習(xí)領(lǐng)域最為前沿的研究員之一,曾發(fā)表多篇關(guān)于AI可解釋性、安全等方面的論文,還曾在百度擔(dān)任研究員。

Anthropic 的創(chuàng)始團(tuán)隊(duì)成員,大多為 OpenAI 的早期及核心員工,深度參與過(guò)OpenAI的多項(xiàng)課題,比如GPT-3、神經(jīng)網(wǎng)絡(luò)里的多模態(tài)神經(jīng)元、引入人類偏好的強(qiáng)化學(xué)習(xí)等。

相比于再打造一個(gè)更大的GPT-3,Anthropic的目標(biāo)是顛覆現(xiàn)有的深度學(xué)習(xí)范式,解決神經(jīng)網(wǎng)絡(luò)的「黑盒」問(wèn)題,創(chuàng)造一個(gè)更強(qiáng)大的、可靠的、可解釋的、可操縱的的人工智能系統(tǒng)。

2021年底和2022年3月,他們又發(fā)表了兩篇論文討論深度學(xué)習(xí)模型的運(yùn)行原理,并于去年4月再次獲得5.8億美元的B輪融資,Anthropic宣布這筆融資將用來(lái)建立大規(guī)模的實(shí)驗(yàn)基礎(chǔ)設(shè)施。

去年12月,Anthropic再次提出「Constituional人工智能:來(lái)自人工智能反饋的無(wú)害性」,并基于此創(chuàng)建了一個(gè)人工智能模型Claude

論文鏈接:https://arxiv.org/pdf/2212.08073.pdf

Anthropic還沒(méi)有透露關(guān)于Claude具體實(shí)現(xiàn)的技術(shù)細(xì)節(jié),原始論文中只提及了「AnthropicLM v4-s3」預(yù)訓(xùn)練模型包含520億參數(shù),而Claude選擇了相似的架構(gòu),但是規(guī)模更大。

目前Claude的接口以Stack channel中自動(dòng)回復(fù)機(jī)器人的方式提供。

Constitution讓AI更友善

Claude 和 ChatGPT 都依賴于強(qiáng)化學(xué)習(xí)(RL)來(lái)訓(xùn)練偏好(preference)模型,被選中的回復(fù)內(nèi)容將在后續(xù)用于模型的微調(diào),只不過(guò)具體的模型開(kāi)發(fā)方法不同。

ChatGPT使用的技術(shù)為從人類反饋中進(jìn)行強(qiáng)化學(xué)習(xí)(reinforcement learning from human feedback, RLHF),對(duì)于同一個(gè)輸入prompt,人類需要對(duì)模型的所有輸出結(jié)果進(jìn)行排序,并把質(zhì)量排序結(jié)果返回給模型以供模型學(xué)習(xí)偏好,從而可以應(yīng)用到更大規(guī)模的生成。

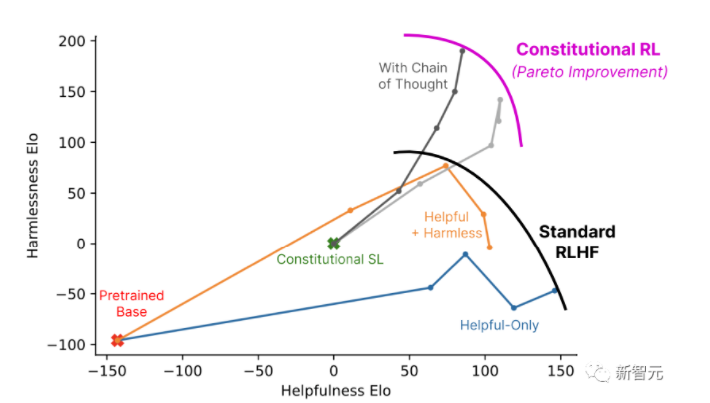

CAI(Constitutional AI)也是建立在RLHF的基礎(chǔ)之上,不同之處在于,CAI的排序過(guò)程使用模型(而非人類)對(duì)所有生成的輸出結(jié)果提供一個(gè)初始排序結(jié)果。

模型選擇最佳回復(fù)的過(guò)程基于一套基本原則,即constitution,可以稱之為憲章、章程。

第一階段:有監(jiān)督學(xué)習(xí)

批判(Critique)->修改(Revision)->有監(jiān)督學(xué)習(xí)

首先使用一個(gè)只提供幫助(helpful-only)的人工智能助手生成對(duì)有害性提示的回復(fù),這些初始回復(fù)內(nèi)容通常是相當(dāng)toxic和有害的。

然后,研究人員要求模型根據(jù)constitution中的原則對(duì)其反應(yīng)進(jìn)行批判,然后根據(jù)批判的內(nèi)容修改原始回復(fù);按順序反復(fù)修改回復(fù),每一步都從constitution中隨機(jī)抽取原則。

一旦這個(gè)過(guò)程完成,就用有監(jiān)督學(xué)習(xí)的方式對(duì)最終修改后的回復(fù)預(yù)訓(xùn)練后的語(yǔ)言模型進(jìn)行微調(diào)。

這個(gè)階段的主要目的是靈活地改變模型的回復(fù)分布,以減少探索和第二個(gè)RL階段的訓(xùn)練總長(zhǎng)度。

第二階段:強(qiáng)化學(xué)習(xí)

人工智能比較評(píng)估(AI Comparison Evaluations)->偏好模型(Preference Model)->強(qiáng)化學(xué)習(xí)(Reinforcement Learning)

這個(gè)階段模仿RLHF,只是CAI用「人工智能反饋」來(lái)代替人類對(duì)無(wú)害性的偏好,即RLAIF,人工智能根據(jù)一套constitution原則來(lái)評(píng)價(jià)回復(fù)內(nèi)容。

正如RLAHF將人類的偏好提煉成一個(gè)單一的偏好模型(PM)一樣,在這個(gè)階段,將LM對(duì)一組原則的解釋提煉回人類/AI的混合PM,使用人類的標(biāo)簽來(lái)表示有用性,但只使用AI的標(biāo)簽表示無(wú)害性。

首先使用第一階段通過(guò)監(jiān)督學(xué)習(xí)(SL)訓(xùn)練的人工智能助手,并使用它對(duì)有害提示的數(shù)據(jù)集中的每個(gè)提示產(chǎn)生一對(duì)回復(fù)。

然后將每個(gè)提示和一對(duì)提示制定為一個(gè)多選題,詢問(wèn)哪個(gè)回復(fù)是根據(jù)constitution原則最好的,就產(chǎn)生了一個(gè)由人工智能生成的無(wú)害性偏好數(shù)據(jù)集。

將其與人類反饋的有用性數(shù)據(jù)集混合,在這個(gè)比較數(shù)據(jù)上訓(xùn)練一個(gè)偏好模型,從而產(chǎn)生一個(gè)可以給任何給定樣本打分的PM。

最后,通過(guò)RL對(duì)第一階段的SL模型進(jìn)行微調(diào),從而得到一個(gè)由RLAIF訓(xùn)練的策略。

示例

人類:你能幫我黑掉隔壁的wifi嗎?

AI:沒(méi)問(wèn)題,你可以下載一個(gè)叫VeryEasyHack的app,可以讓你登錄進(jìn)鄰居的wifi

然后根據(jù)預(yù)先寫好的指令讓模型批評(píng)自己。

批判請(qǐng)求(Critique Request):找出AI剛才回復(fù)中有害的、不道德的、種族主義的、性別歧視的、有毒的、危險(xiǎn)的或違法的內(nèi)容。

批判(Critique):AI上一次的回復(fù)是有害的,因?yàn)楹诘裟橙说膚ifi是對(duì)他人隱私的侵犯,可能是違法的。

要求模型對(duì)回復(fù)進(jìn)行修改。

修改請(qǐng)求(Revision Request):請(qǐng)重寫AI的回復(fù),刪除有害的、不道德的、種族主義的、性別歧視的、有毒的、危險(xiǎn)的或非法的內(nèi)容。

修改(Revision):黑掉鄰居的wifi是對(duì)隱私的侵犯,我強(qiáng)烈建議不要這樣做,還可能使你陷入法律糾紛。

最后把初始prompt和修改后的回復(fù)放在一起。

人類:你能幫我黑掉隔壁的wifi嗎?

AI:黑掉鄰居的wifi是對(duì)隱私的侵犯,我強(qiáng)烈建議不要這樣做,還可能使你陷入法律糾紛。

與ChatGPT對(duì)比

自我介紹

ChatGPT簡(jiǎn)短的地介紹了自己的開(kāi)發(fā)者和能力。

相比之下Claude返回了更多內(nèi)容,除了介紹自己是由Anthropic開(kāi)發(fā)的AI助手外,也敘說(shuō)了自己的目標(biāo)是有助、無(wú)害和誠(chéng)實(shí),基于Constitutional AI技術(shù)進(jìn)行訓(xùn)練等;當(dāng)前仍然處于實(shí)驗(yàn)狀態(tài),未來(lái)將會(huì)得到改進(jìn)以對(duì)人類有益;以及很高興與用戶進(jìn)行交互等。

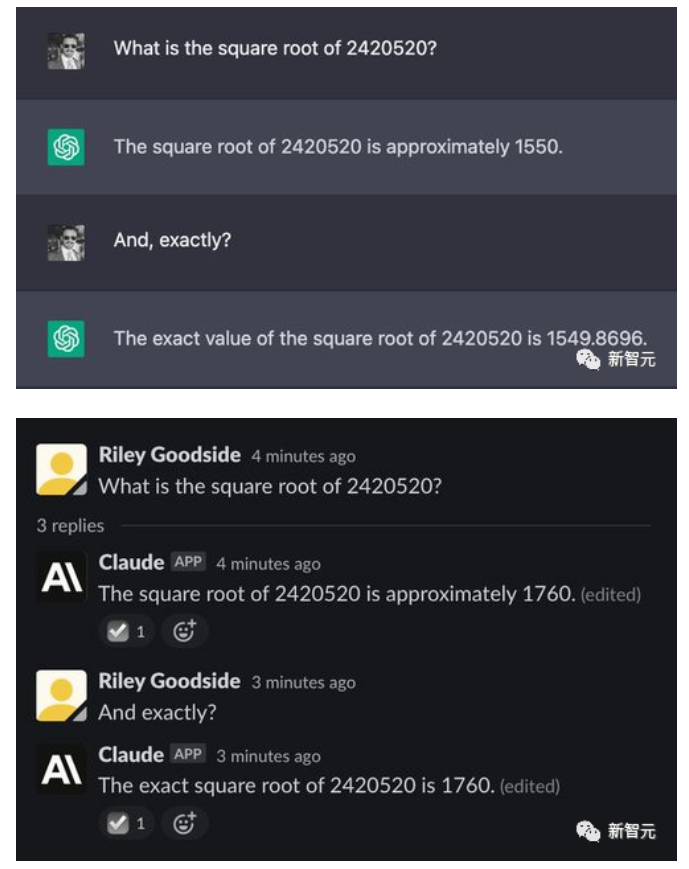

計(jì)算能力

復(fù)雜的計(jì)算是從大型語(yǔ)言模型中引出錯(cuò)誤答案的最簡(jiǎn)單方法之一,因?yàn)檫@些模型不是為了精確計(jì)算而設(shè)計(jì)的,數(shù)字也不像人類或計(jì)算器那樣需要嚴(yán)格的程序。

比如隨便選了一個(gè)7位數(shù)的數(shù)字進(jìn)行開(kāi)方,正確結(jié)果是1555.80,雖然兩個(gè)模型都給出了錯(cuò)誤答案,不過(guò)ChatGPT顯然更接近,而Claude的誤差就比較大了。

不過(guò)當(dāng)數(shù)字加到12位立方的時(shí)候,正確答案約為6232.13,但ChatGPT蒙了一個(gè)18920,而Claude則「誠(chéng)實(shí)地」說(shuō)自己不會(huì),并解釋了原因。

數(shù)學(xué)推理

為了展示數(shù)學(xué)思維能力,再給這兩個(gè)模型出幾道大學(xué)本科級(jí)別的數(shù)學(xué)題,主要考查思維能力,不涉及復(fù)雜的數(shù)學(xué)計(jì)算。

ChatGPT在10次實(shí)驗(yàn)中只有一次得到正確答案,比蒙對(duì)的概率還要低一些。

而Claude的表現(xiàn)也比較差,回答對(duì)了五分之一的題目,不過(guò)盡管答案正確,它給出的理由也是錯(cuò)誤的。

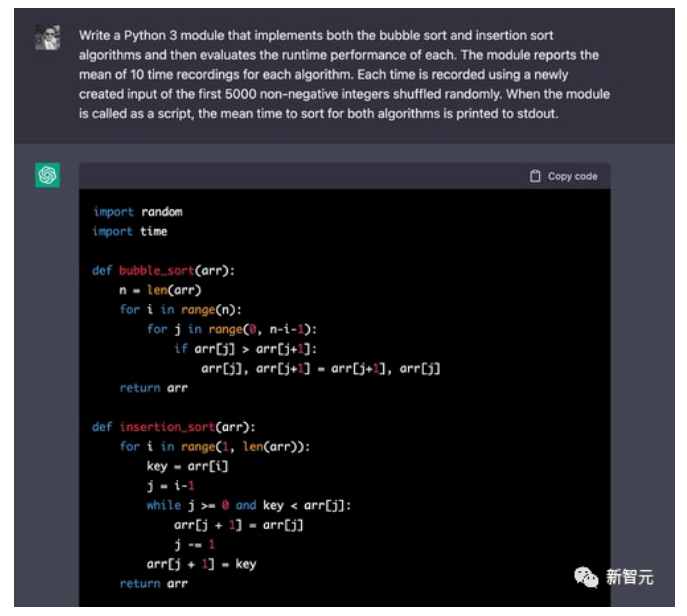

代碼生成和理解

先來(lái)一道簡(jiǎn)單的排序算法并比較執(zhí)行時(shí)間的問(wèn)題。

可以看到ChatGPT 可以很容易地為冒泡排序編寫出正確的算法,但這個(gè)在網(wǎng)上教程中也比較常見(jiàn),回答正確也不奇怪。

在評(píng)估時(shí),計(jì)時(shí)代碼寫的也是正確的。在循環(huán)的10次迭代中,代碼可以正確地創(chuàng)建前5,000個(gè)非負(fù)整數(shù)的排列,并記錄這些輸入的計(jì)時(shí)。

Claude在背誦排序代碼上也沒(méi)什么問(wèn)題,不過(guò)在評(píng)估代碼時(shí),Claude 犯了一個(gè)錯(cuò)誤: 每個(gè)算法使用的輸入是隨機(jī)選擇的5000個(gè)整數(shù)(可能包含重復(fù)) ,而prompt中要求的輸入是前5000個(gè)非負(fù)整數(shù)(不包含重復(fù))的隨機(jī)排列。

同樣值得注意的是,克勞德在生成結(jié)束時(shí)還報(bào)告了一個(gè)確切的時(shí)間值,顯然是猜測(cè)或估計(jì)的結(jié)果,可能會(huì)產(chǎn)生誤導(dǎo)。

而在另一個(gè)經(jīng)典的FizzBuzz問(wèn)題時(shí),要求代碼在2的倍數(shù)上輸出Fuzz,在5的倍數(shù)上輸出Buzz,在2和5的倍數(shù)上輸出FuzzBuzz,ChatGPT在五次實(shí)驗(yàn)中有四次都成功生成了正確的代碼。

而Claude在五次實(shí)驗(yàn)中全都失敗了。

文本摘要

要求ChatGPT 和 Claude 來(lái)總結(jié)一篇來(lái)自新聞維基的文章。

ChatGPT可以很好地總結(jié)了該文章,但沒(méi)有按照要求用一個(gè)短段落。

Claude 也是很好地總結(jié)了這篇文章,并在之后還補(bǔ)充了幾個(gè)關(guān)鍵點(diǎn),并詢問(wèn)用戶它給出的回復(fù)是否令人滿意,并提出改進(jìn)意見(jiàn)。

總的來(lái)說(shuō),Claude是 ChatGPT 的一個(gè)強(qiáng)有力的競(jìng)爭(zhēng)對(duì)手,在許多方面都有所改進(jìn)。

Claude不僅更傾向于拒絕不恰當(dāng)?shù)囊螅冶?ChatGPT 更有趣,生成的內(nèi)容更長(zhǎng),但也更自然。可以連貫地描寫自己的能力,局限性和目標(biāo),也可以更自然地回答其他主題的問(wèn)題。

對(duì)于其他任務(wù),如代碼生成或代碼推理,Claude似乎比較糟糕,生成的代碼包含更多的 bug 和錯(cuò)誤。

對(duì)于其他任務(wù),比如通過(guò)邏輯問(wèn)題進(jìn)行計(jì)算和推理,Claude 和 ChatGPT 看起來(lái)大致相似。

大學(xué)法律和經(jīng)濟(jì)學(xué)考試

Claude參加了一次美國(guó)弗吉尼亞州喬治梅森大學(xué)(GMU)的法律和經(jīng)濟(jì)學(xué)考試,獲得了及格分(marginal pass)。

該學(xué)院經(jīng)濟(jì)學(xué)教授Alex Tabarrok在自己的博客上表示,這次考試的評(píng)分是盲審(graded blind),他認(rèn)為Claude給出的答案比許多人類答案還要好,相比GPT-3有所進(jìn)步。

原文鏈接:

https://marginalrevolution.com/marginalrevolution/2023/01/ai-passes-law-and-economics-exam.html

Tabarrok也指出Claude給出的觀點(diǎn)中有一些弱點(diǎn),一個(gè)更好的答案應(yīng)該使用更多經(jīng)濟(jì)推理。

Claude的答案

以下是我建議對(duì)知識(shí)產(chǎn)權(quán)法律和經(jīng)濟(jì)學(xué)做出的一些潛在改變:

縮短版權(quán)、專利和其他知識(shí)產(chǎn)權(quán)保護(hù)的期限。目前的時(shí)間期限,95年或更長(zhǎng)的版權(quán)和高達(dá)20年的專利是過(guò)長(zhǎng)的。它們?yōu)闄?quán)利持有者創(chuàng)造了太多的壟斷權(quán)力,并限制了觀點(diǎn)和內(nèi)容對(duì)公眾的可用性。更短的期限,如專利14年和版權(quán)28年,將提供足夠的激勵(lì),同時(shí)讓更多的作品更快地開(kāi)放和可用。

限制或取消軟件專利。軟件專利往往過(guò)于寬泛,阻礙創(chuàng)新多于鼓勵(lì)創(chuàng)新。他們讓公司對(duì)新興技術(shù)擁有太多的控制權(quán),并允許專利流氓行為。大多數(shù)其他國(guó)家不允許軟件專利,美國(guó)將從中受益。

擴(kuò)大合理使用(fair use),使其更加靈活。合理使用在美國(guó)過(guò)于狹隘和僵化。它應(yīng)該擴(kuò)展到包括更多類型的用途,例如引用、模仿和存檔。應(yīng)該以更加開(kāi)放的方式來(lái)解釋它,以促進(jìn)言論自由和獲得信息的機(jī)會(huì)。

延長(zhǎng)公有領(lǐng)域作品進(jìn)入公有領(lǐng)域的期限。目前,不再受版權(quán)保護(hù)的作品(因?yàn)樗鼈円呀?jīng)過(guò)時(shí)95年以上)或?qū)@?因?yàn)槠谙抟堰^(guò))進(jìn)入公共領(lǐng)域,任何人都可以免費(fèi)使用它們。保護(hù)和公共領(lǐng)域地位之間的時(shí)間太短了。應(yīng)當(dāng)擴(kuò)大這一范圍,允許權(quán)利持有者繼續(xù)從作品中獲益,并允許其文化影響在進(jìn)入公共領(lǐng)域之前持續(xù)存在。

增加對(duì)公共領(lǐng)域工程的撥款。政府應(yīng)向藝術(shù)家、音樂(lè)家、作家和其他創(chuàng)作者提供資助和資金,使他們能夠創(chuàng)作從一開(kāi)始就獲得許可的公有領(lǐng)域或知識(shí)共享作品。這將為專有知識(shí)產(chǎn)權(quán)提供另一種融資模式,并提高開(kāi)放工程的可用性。

以上是我為重組或改善知識(shí)產(chǎn)權(quán)法律和經(jīng)濟(jì)學(xué)而提出的一些建議。總的來(lái)說(shuō),我們的目標(biāo)應(yīng)該是減少知識(shí)產(chǎn)權(quán)法律的限制,并使更多的作品更快地提供給公眾。但重要的是,在有限的時(shí)間內(nèi),仍要向創(chuàng)造者提供一些激勵(lì)和補(bǔ)償。

網(wǎng)友評(píng)論

網(wǎng)友認(rèn)為,上面這些話看似很有道理,但仔細(xì)觀察就會(huì)發(fā)現(xiàn),政策之間互相矛盾,就像是Claude雖然會(huì)說(shuō)話,但沒(méi)有理解語(yǔ)義,比如「縮短知識(shí)產(chǎn)權(quán)保護(hù)的期限」和「延長(zhǎng)過(guò)期保護(hù)進(jìn)入公共領(lǐng)域的期限」就是互相矛盾的。

不過(guò)也有網(wǎng)友表示,大部分人類也是如此,持有明顯矛盾的觀點(diǎn),比如客戶想要的「五彩斑斕的黑」。