自動(dòng)駕駛是集感知、決策,、交互于一體的技術(shù)

環(huán)境感知能力作為自動(dòng)駕駛的第一個(gè)環(huán)節(jié),,是車輛與環(huán)境交互的紐帶

通過“攝像頭、毫米波雷達(dá),、超聲波雷達(dá),、激光雷達(dá)”等各類傳感器設(shè)備,感知環(huán)境的手段日趨多元化

同時(shí),,在平臺(tái)層面感知決策處理能力的提升,,平臺(tái)算力和感知算法的效率提升和創(chuàng)新,也成為了車企發(fā)展智能駕駛能力的關(guān)鍵,。

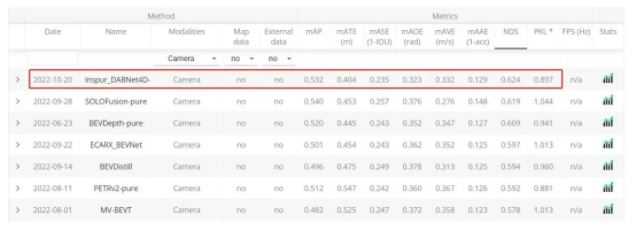

NuScenes挑戰(zhàn)賽,,作為檢驗(yàn)感知算法在自動(dòng)駕駛領(lǐng)域相關(guān)任務(wù)性能的試金石,自數(shù)據(jù)集公開以來,,吸引了來自全球各地的研究團(tuán)隊(duì)的結(jié)果提交,。在最新一期所公布的競賽測評(píng)榜單中,浪潮信息憑借Inspur-DABNeT4D登頂自動(dòng)駕駛數(shù)據(jù)集NuScenes 純視覺3D目標(biāo)檢測任務(wù)榜單,,并將關(guān)鍵性指標(biāo)NuScenes DetecTIon Score(NDS)提高至62.4% ,。那么,未來自動(dòng)駕駛感知技術(shù)究邁向如何的路徑發(fā)展,, 逐步實(shí)現(xiàn)大規(guī)模的量產(chǎn)落地,?

本文將從浪潮信息本次所登頂NuScenes榜首的感知模型出發(fā),一窺自動(dòng)駕駛的感知技術(shù)發(fā)展,。

從自動(dòng)駕駛的分級(jí)來看,,當(dāng)前的自動(dòng)駕駛技術(shù),隱隱可以看出2個(gè)流派,,一個(gè)是以直接實(shí)現(xiàn)L4級(jí)自動(dòng)駕駛為目標(biāo)的激進(jìn)派,,一個(gè)是從L2級(jí)輔助駕駛開始,逐步提升自動(dòng)駕駛等級(jí)的漸進(jìn)派,。但無論是L2級(jí)的輔助駕駛還是L4級(jí)的自動(dòng)駕駛,,從整體架構(gòu)上看,都可以大致分為感知,、決策和控制3部分,。感知是自動(dòng)駕駛汽車的眼睛,和人類的眼睛為大腦提供了70%以上的信息類似,,感知系統(tǒng)也為自動(dòng)駕駛車輛提供了車輛外部環(huán)境信息輸入,。自動(dòng)駕駛的感知依賴于各種車載傳感器的信息輸入,,包括攝像頭、超聲波雷達(dá),、毫米波雷達(dá)和激光雷達(dá)等。其中最核心的就是攝像頭和激光雷達(dá),。

自動(dòng)駕駛面對(duì)的是一個(gè)3維的環(huán)境空間,,甚至于我們可以說,因?yàn)樽詣?dòng)駕駛車輛要在環(huán)境空間中移動(dòng),,且環(huán)境空間中其他的行人,、車輛等也會(huì)移動(dòng),則可以看作自動(dòng)駕駛面對(duì)的是一個(gè)3維空間+1維時(shí)間的4維時(shí)空體系,。自動(dòng)駕駛車輛需要在三維空間中判斷周圍的人,、車、物的距離遠(yuǎn)近,,在此基礎(chǔ)上還要判斷他們是靜態(tài)或者動(dòng)態(tài)的,,以及移動(dòng)的方向和速度等信息,我們一般稱之為3D目標(biāo)檢測任務(wù),。3D目標(biāo)檢測任務(wù)可以看作是自動(dòng)駕駛中最核心的感知任務(wù),。當(dāng)然,除此之外,,其他的感知任務(wù)還包括識(shí)別紅綠燈,、交通標(biāo)識(shí)、車道線,、斑馬線等道路信息,。

圖 1:3D目標(biāo)檢測示意圖, 3D目標(biāo)被定義為一個(gè)長方體,,(x,y,z)是長方體的中心坐標(biāo),,(l,w,h)是長寬高信息,θ是航向角,,比如長方體在地平面的偏航角,,class是3D目標(biāo)的類別。vx,、vy描述3D目標(biāo)在地面上沿x軸和y軸方向的速度,。

長期以來,激光雷達(dá)一直被認(rèn)為是自動(dòng)駕駛車輛不可或缺的零部件之一,,因?yàn)榧す饫走_(dá)能提供對(duì)車輛周圍環(huán)境最精確的三維感知,。激光雷達(dá)采集的點(diǎn)云信息天然就存儲(chǔ)了三維空間信息,因此基于激光點(diǎn)云信息的3D目標(biāo)檢測來說,,算法設(shè)計(jì)就簡單了許多,,也誕生了一系列的經(jīng)典模型,,比如PointPillar、SECOND,、SASSD等等,。但是激光雷達(dá)的成本問題也成為了自動(dòng)駕駛落地最大的瓶頸。早期的激光雷達(dá)價(jià)格,,比如激光雷達(dá)鼻祖Velodyne推出的高精度激光雷達(dá)的價(jià)格達(dá)到了8萬美元,。雷達(dá)比車貴的現(xiàn)實(shí)問題成為了激光雷達(dá)上車和量產(chǎn)的最大阻礙。雖然今年隨著技術(shù)的進(jìn)步,,激光雷達(dá)的價(jià)格下降明顯,,但是能滿足L4級(jí)自動(dòng)駕駛需求的激光雷達(dá)的價(jià)格依然偏高。

攝像頭是自動(dòng)駕駛車輛的另外一個(gè)非常重要的傳感器,,因?yàn)榧す饫走_(dá)采集的點(diǎn)云信息沒有色彩和紋理,,因此無法識(shí)別對(duì)于人類來說可以輕松辨別的紅綠燈、交通標(biāo)識(shí),、車道線,、斑馬線等道路信息。因此還是需要攝像頭作為補(bǔ)充,。而這又會(huì)帶來額外的多個(gè)模態(tài)的信息融合難題,。簡單來說,激光雷達(dá)主要擅長三維空間中的車輛,、行人等的三維時(shí)空信息感知,,而攝像頭主要擅長除此之外的紅綠燈、車道線等視覺紋理特征比較豐富的信息感知,。另外,,在量產(chǎn)成本和價(jià)格上,攝像頭也有無可比擬的優(yōu)勢,。比如Tesla搭載的單顆單目攝像頭的成本僅為25美元,,整車8個(gè)攝像頭的價(jià)格也才200美元。相比于整車價(jià)格來說,,幾乎可以忽略不計(jì),。如果僅使用攝像頭,在強(qiáng)大AI算法的加持下,,就能實(shí)現(xiàn)精確的3D目標(biāo)檢測任務(wù),,那意味著不使用激光雷達(dá)的自動(dòng)駕駛也不無可能。

在計(jì)算機(jī)視覺領(lǐng)域,,近年誕生了大量的分類,、檢測、分割模型,,比如ResNet,、YOLO,、Mask RCNN等,這些AI模型已經(jīng)廣泛的應(yīng)用于安防,、交通,、以及自動(dòng)駕駛領(lǐng)域。但有一個(gè)核心的問題是,,這些模型都是針對(duì)2D圖像設(shè)計(jì)的,,無法直接適用于3D目標(biāo)檢測任務(wù)?;趫D像進(jìn)行3D目標(biāo)檢測的核心問題就是如何精確的估計(jì)圖像中物體的深度,。因?yàn)閿z像頭拍攝的照片和視頻是把3D空間投射到了2D平面中,,丟失了深度信息,,如何對(duì)這些深度信息進(jìn)行還原就是一個(gè)機(jī)器學(xué)習(xí)領(lǐng)域所謂的“病態(tài)問題”。即,,問題的解可能不是唯一的,。因此長期以來,基于圖像的3D目標(biāo)檢測算法性能一直遠(yuǎn)低于基于激光雷達(dá)的3D目標(biāo)檢測性能,。

自從Tesla使用純攝像頭方案的輔助駕駛系統(tǒng)取得一定的成功之后,,基于純視覺的自動(dòng)駕駛感知方案受到了業(yè)界越來越多的關(guān)注。同時(shí)隨著數(shù)據(jù),、算法,、算力等多個(gè)方面的進(jìn)步,純視覺的自動(dòng)駕駛感知方案在3D目標(biāo)檢測任務(wù)上的性能在最近一年和激光雷達(dá)的差距有了明顯的改觀,。

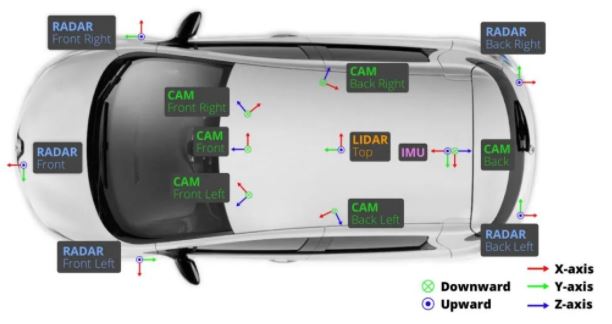

在數(shù)據(jù)方面,,出現(xiàn)了搭載傳感器更多,采集時(shí)間更長的自動(dòng)駕駛道路數(shù)據(jù)集,。比如2019年由MoTIonal(由現(xiàn)代汽車集團(tuán)和ApTIv資成立的一家無人駕駛公司)的團(tuán)隊(duì)開發(fā)和開源的NuScenes數(shù)據(jù)集采集于波士頓和新加坡兩個(gè)城市的實(shí)際道路,。收集了大約15小時(shí)的駕駛數(shù)據(jù),精心選擇駕駛路線以捕捉具有挑戰(zhàn)性的場景數(shù)據(jù),。數(shù)據(jù)場景覆蓋了城市,、住宅區(qū)、郊區(qū),、工業(yè)區(qū)各個(gè)場景,,也涵蓋了白天、黑夜,、晴天,、雨天、多云等不同時(shí)段不同天氣狀況,。采集車上配備了完善的傳感器,,包括了6個(gè)相機(jī),、1個(gè)激光雷達(dá)、5個(gè)毫米波雷達(dá),、以及GPS和IMU,,具備360°的視野感知能力。NuScenes數(shù)據(jù)集是第一個(gè)提供自動(dòng)汽車全套傳感器數(shù)據(jù)的大型數(shù)據(jù)集,。不同傳感器在車輛上放置如下圖所示,。

圖 2:NuScenes數(shù)據(jù)集的采集車安裝的傳感器位置示意圖。搭載了6個(gè)相機(jī),,1個(gè)激光雷達(dá)和5個(gè)毫米波雷達(dá),。

除了NuScenes之外,業(yè)界還有Waymo,、ONCE等開源數(shù)據(jù)集,。但目前NuScenes是被使用最多的數(shù)據(jù)集。自公開以來,,NuScenes數(shù)據(jù)集已經(jīng)被論文引用超2000次,。NuScenes挑戰(zhàn)賽也成為了檢驗(yàn)感知算法在自動(dòng)駕駛相關(guān)任務(wù)性能的試金石。吸引了來自全球各地的研究團(tuán)隊(duì)的220余次結(jié)果提交,,涵蓋了卡內(nèi)基梅隆大學(xué),、加利福尼亞大學(xué)伯克利分校、MIT,、清華大學(xué),、香港科技大學(xué)、上海交通大學(xué),、中國科學(xué)技術(shù)大學(xué)等國內(nèi)外重點(diǎn)高校,。

NuScenes數(shù)據(jù)集提供了包括 3D 目標(biāo)檢測、3D 目標(biāo)跟蹤,、預(yù)測軌跡 ,、激光雷達(dá)分割、全景分割和跟蹤在內(nèi)的多個(gè)評(píng)測任務(wù),。其中3D目標(biāo)檢測任務(wù)的目標(biāo)是檢測NuScenes數(shù)據(jù)集上的10種不同類別的檢測對(duì)象,,包括標(biāo)出3D目標(biāo)框,并且估計(jì)相應(yīng)類別的屬性信息和當(dāng)前的速度信息等,。這10種檢測對(duì)象具體包括汽車,、卡車、公交車,、行人,、摩托車、自行車、錐桶,、路障等,,檢測的信息包括物體的三維位置、大小,、方向,、速度等。NuScenes 提出了一個(gè)綜合指標(biāo)NDS,,即NuScenes 檢測分?jǐn)?shù)(NuScenes DetecTIon Score, NDS),,這個(gè)指標(biāo)由平均精度(mAP)、平均平移誤差(ATE),、平均尺度誤差(ASE),、平均方向誤差(AOE)、平均速度誤差(AVE)和平均屬性誤差(AAE)綜合計(jì)算得到,。

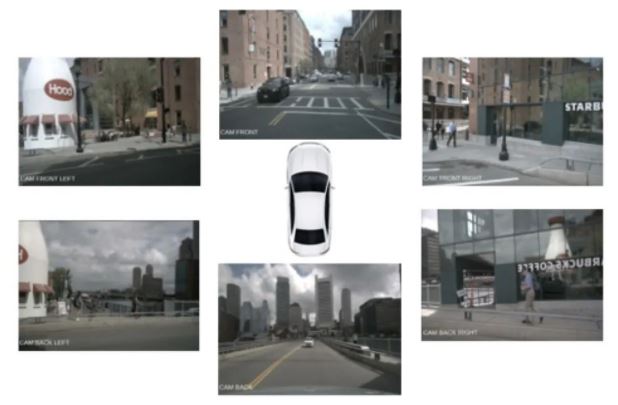

圖 3:NuScenes數(shù)據(jù)集中車身6個(gè)攝像頭采集畫面示意圖,。

NuScenes提供了一個(gè)常年更新的榜單,在純視覺 3D目標(biāo)檢測任務(wù)榜單上,,目前一共有50次提交,,其中大多數(shù)的提交發(fā)生在2022年,。目前排名第一的是浪潮信息的AI團(tuán)隊(duì)在22年10月提交的DABNet4D算法,,實(shí)現(xiàn)了綜合檢測精度NDS 0.624的檢測效果。而在2022年初排名第一的BEV3D算法的NDS精度是0.474,。也就是說在不到一年的時(shí)間內(nèi),,NuScenes 純視覺3D目標(biāo)檢測的NDS指標(biāo)提升了15個(gè)點(diǎn)。相比之下,,基于激光雷達(dá)的3D目標(biāo)檢測精度,,僅從年初的0.685提升到0.728,提升約4個(gè)點(diǎn),。而基于純視覺算法和激光雷達(dá)算法的精度差距也從年初的45%縮小到17%,。這主要得益于純視覺3D檢測算法優(yōu)化帶來的性能提升。

圖 4:NuScenes評(píng)測榜單截圖,。

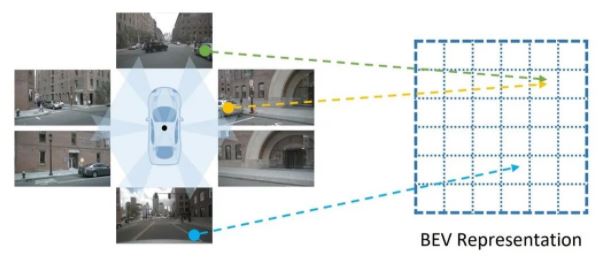

浪潮此次所提交的算法DABNet4D是Depth-awared BEVNet 4D的縮寫,,即深度感知的四維鳥瞰圖(bird's eye view, BEV)神經(jīng)網(wǎng)絡(luò)。其核心思想就是構(gòu)建了鳥瞰圖(BEV)神經(jīng)網(wǎng)絡(luò),,并使用了時(shí)空融合的4D感知和深度預(yù)測優(yōu)化,。由于單個(gè)攝像頭的視角有限,僅使用單個(gè)攝像頭很難實(shí)現(xiàn)對(duì)車身周圍360度的感知,。前期自動(dòng)駕駛算法模型一般是基于車身不同位置的攝像頭分別進(jìn)行環(huán)境感知,,然后進(jìn)行融合。但是這一方案存在一些潛在的問題,比如對(duì)于像大卡車這類比較大的車輛挨著自動(dòng)駕駛車輛時(shí),,會(huì)在自動(dòng)駕駛車輛的多個(gè)攝像頭中出現(xiàn)卡車的不同部位,,會(huì)導(dǎo)致算法出現(xiàn)錯(cuò)誤檢測和漏檢的情況。最近融合模型架構(gòu),,通過先對(duì)不同攝像頭或其他傳感器的信息進(jìn)行融合,,然后在一個(gè)統(tǒng)一的融合的空間進(jìn)行3D目標(biāo)感知和檢測,能夠有效的解決這些問題,,是目前感知技術(shù)發(fā)展的一大趨勢,。

圖 5:把不同視角的圖像轉(zhuǎn)換到統(tǒng)一的鳥瞰圖(BEV)視角空間。

所謂鳥瞰圖,,就是從天空俯視自動(dòng)駕駛車輛及其周圍環(huán)境,,也就是所謂的上帝視角。自動(dòng)駕駛車輛的攝像頭都是水平視角,,如果把不同水平視角的圖像融合成一個(gè)統(tǒng)一的以自動(dòng)駕駛車輛為中心的俯視視角的特征圖,,那么就可以提供最清晰和完整的自動(dòng)駕駛車輛周圍環(huán)境空間的視覺表征,從而也就方便從這統(tǒng)一的視覺表征中進(jìn)行3D目標(biāo)檢測以及其他的檢測,、分類,、分割等視覺感知任務(wù)。但是,,如何基于AI算法構(gòu)建這統(tǒng)一鳥瞰圖視覺表征是一個(gè)很大的挑戰(zhàn),。

圖 6:多相機(jī)融合算法架構(gòu)圖。先使用特征提取神經(jīng)網(wǎng)絡(luò)對(duì)不同視角的圖像進(jìn)行特征提取,,并融合到統(tǒng)一的BEV空間,,并基于統(tǒng)一BEV空間進(jìn)行障礙物檢測、車道線檢測和道路檢測等檢測任務(wù),。

在2022年初,,浪潮團(tuán)隊(duì)構(gòu)建了一個(gè)基于Transformer架構(gòu)的多視角特征融合模型CBTR。CBTR以經(jīng)過卷積神經(jīng)網(wǎng)絡(luò)提取的圖像特征作為輸入,,并經(jīng)過標(biāo)準(zhǔn)Transformer架構(gòu)的特征融合和特征變換,,實(shí)現(xiàn)了高效穩(wěn)定的BEV特征輸出。以CBTR構(gòu)建的BEV特征為基礎(chǔ),,團(tuán)隊(duì)在NuScenes數(shù)據(jù)集上實(shí)現(xiàn)了在精度和速度上都最優(yōu)的車道線檢測算法,。相關(guān)成果發(fā)表在CVPR 2022 WAD上。在DABNet4D中,,團(tuán)隊(duì)進(jìn)一步優(yōu)化了BEV特征的提取網(wǎng)絡(luò),,以實(shí)現(xiàn)更好的特征提取效果。

圖 7:浪潮團(tuán)隊(duì)研發(fā)的基于Transformer架構(gòu)的多視角特征融合模型CBTR的架構(gòu)圖,。

考慮到車輛所處的環(huán)境是一個(gè)動(dòng)態(tài)變化的三維空間,,引入歷史空間數(shù)據(jù)對(duì)于目標(biāo)的速度和方向的預(yù)測將會(huì)有比較大的幫助,。為了進(jìn)一步引入車輛所處的動(dòng)態(tài)環(huán)境中的歷史信息,浪潮團(tuán)隊(duì)基于NuScenes中的多幀數(shù)據(jù),,分別進(jìn)行BEV特征提取,,并使用專門的特征融合模塊對(duì)時(shí)序的特征進(jìn)行融合,構(gòu)建了MASTER(Multi-camerA Spatial and Temporal feature ExtractoR,,多相機(jī)時(shí)空特征提取器)算法,。2022年7月,團(tuán)隊(duì)在NuScenes榜單提交了MASTERv2版本的3D目標(biāo)檢測結(jié)果,,實(shí)現(xiàn)了NDS 0.576的檢測精度,。位列當(dāng)前同類型算法第一。

在此基礎(chǔ)上,,如何進(jìn)一步提高純視覺3D目標(biāo)檢測的精度,,其核心還是進(jìn)一步優(yōu)化模型的深度估計(jì)性能。在MASTER算法的基礎(chǔ)上,,團(tuán)隊(duì)進(jìn)一步引入了深度估計(jì)網(wǎng)絡(luò),,來強(qiáng)化模型的深度感知性能。最終的完整網(wǎng)絡(luò)架構(gòu)如下圖所示,。

圖 8:浪潮團(tuán)隊(duì)研發(fā)的DABNet4D模型架構(gòu)圖,。

除此之外,多種數(shù)據(jù)增強(qiáng)算法的應(yīng)用,,也對(duì)DABNet4D的性能提升有比較大的幫助,,這主要是因?yàn)殡m然NuScenes數(shù)據(jù)集在目前開源的自動(dòng)駕駛測評(píng)數(shù)據(jù)集中,已經(jīng)算是比較大的規(guī)模,,但是其相對(duì)于真實(shí)的自動(dòng)駕駛場景來說,,數(shù)據(jù)集的規(guī)模還是比較有限,,比如有的目標(biāo)檢測類別,,在整個(gè)數(shù)據(jù)集中,只出現(xiàn)了很少的次數(shù),。這種不同類別目標(biāo)在數(shù)據(jù)集中的不均衡性,,對(duì)于模型整體檢測效果的提升,有較大的不利影響,。因此DABNet4D使用了圖像數(shù)據(jù)增強(qiáng),、BEV特征增強(qiáng)和樣本貼圖增強(qiáng)等多尺度的數(shù)據(jù)增強(qiáng)技術(shù),來提升模型的檢測效果,。

在此基礎(chǔ)上,,使用性能更優(yōu)的特征提取網(wǎng)絡(luò)對(duì)于整體的性能提升也有一定的幫助。團(tuán)隊(duì)測試了EfficientNet系列,、Swin Transformer系列,、ConvNeXt系列等多個(gè)典型的視覺特征提取網(wǎng)絡(luò),并最終選用了ConvNeXt網(wǎng)絡(luò)架構(gòu)以期獲得最佳的特征提取性能。

在集合了上述算法和工程化方法上的創(chuàng)新之后,,DABNet4D最終實(shí)現(xiàn)了NuScenes評(píng)測榜單上當(dāng)前業(yè)界最佳的純視覺3D目標(biāo)檢測精度,。

需要提到的是,完善的算力基礎(chǔ)設(shè)施也在這一工作過程中起到了舉足輕重的作用,。和訓(xùn)練2D目標(biāo)檢測模型比如YOLO系列相比,,DABNet4D的訓(xùn)練需要更多的算力以及更好的算力平臺(tái)支撐。

本次構(gòu)建的DABNet4D-tiny和DABNet4D-base兩個(gè)模型,,其參數(shù)量分別是59.1M和166.6M,。雖然參數(shù)量不是特別大,但是由于使用的輸入數(shù)據(jù)分辨率達(dá)到了1600x900,,遠(yuǎn)大于ImageNet,、COCO等數(shù)據(jù)集訓(xùn)練2D目標(biāo)檢測網(wǎng)絡(luò)的圖片尺寸,這意味著模型訓(xùn)練過程中的特征圖輸出也會(huì)大很多,,從而需要更多的顯存空間來存儲(chǔ),。與此同時(shí),多相機(jī)視角的引入以及時(shí)序數(shù)據(jù)的引入,,意味著模型訓(xùn)練需要更大的批尺寸,。舉例來說,NuScenes數(shù)據(jù)集有6個(gè)相機(jī),,如果僅使用連續(xù)3幀的時(shí)序數(shù)據(jù),,也意味著模型的輸入批尺寸是18。這進(jìn)一步增大了對(duì)訓(xùn)練設(shè)備的顯存需求,。實(shí)際上,,浪潮團(tuán)隊(duì)訓(xùn)練模型使用的是搭載了NVIDIA Ampere 架構(gòu)40GB和80GB顯存的多臺(tái)5488A5 GPU服務(wù)器平臺(tái)。其中GPU之間使用了NV-Switch全互聯(lián)架構(gòu),,來滿足模型訓(xùn)練的高顯存需求,,以及模型并行訓(xùn)練的高通信帶寬需求。除此之外,,服務(wù)器上部署的AISTATION資源管理系統(tǒng),,對(duì)于整個(gè)任務(wù)中的資源管理和分布式訓(xùn)練優(yōu)化,對(duì)于整個(gè)模型訓(xùn)練的效率提升,,也起到了很大的幫助,。

另外,數(shù)據(jù)的豐富程度對(duì)于純視覺3D目標(biāo)檢測模型的感知性能提升作用明顯,。這也是為什么在DABNet4D的優(yōu)化過程中,,團(tuán)隊(duì)使用了較多的數(shù)據(jù)增強(qiáng)算法。因?yàn)橄鄬?duì)于真實(shí)的自動(dòng)駕駛場景和數(shù)據(jù)集來說,,NuScenes數(shù)據(jù)集的規(guī)模還是太小了,。比如公開資料表明,,Tesla 訓(xùn)練其FSD自動(dòng)駕駛系統(tǒng)使用了 100萬的 8-camera 36fps 10-second videos作為訓(xùn)練數(shù)據(jù),其規(guī)模遠(yuǎn)大于NuScenes數(shù)據(jù)集,。DABNet4D使用了大約2000 GPU hours,。做同比換算的話,Tesla的FSD的訓(xùn)練需求大約是316 臺(tái)5488A5服務(wù)器訓(xùn)練約1周的時(shí)間,。其計(jì)算需求之大,,可見一斑。

在自動(dòng)駕駛落地的產(chǎn)業(yè)化進(jìn)程中,,感知技術(shù)作為自動(dòng)駕駛的核心技術(shù)模塊,,既是起點(diǎn)也是基石。而未來,,面向自動(dòng)駕駛感知算法的研發(fā),,也將會(huì)投入更為強(qiáng)大的人工智能計(jì)算平臺(tái)予以支撐。作為全球領(lǐng)先的算力提供商,,浪潮信息始終踐行多角度切入,,發(fā)揮融合算力、算法等全棧解決方案能力優(yōu)勢,,推動(dòng)自動(dòng)駕駛領(lǐng)域的技術(shù)創(chuàng)新型發(fā)展,。從NuScenes榜單技術(shù)的快速迭代來看,我們有理由相信,,隨著算力,、算法的持續(xù)型突破,自動(dòng)駕駛產(chǎn)業(yè)化落地進(jìn)程也將多一層“騰飛動(dòng)力之源”,。

更多信息可以來這里獲取==>>電子技術(shù)應(yīng)用-AET<<