2017年,,當名為“Deepfakes”的用戶在互聯(lián)網(wǎng)上首次發(fā)布合成視頻時,也許不曾想到他已經(jīng)打開了“潘多拉魔盒”,。隨著DeepFake技術在缺少監(jiān)管的狀態(tài)下野蠻生長至今,,已逐漸成為危害經(jīng)濟和社會穩(wěn)定的存在。無數(shù)事實都在時刻提醒我們:眼見未必為實,!不能再理所當然地相信互聯(lián)網(wǎng)上的圖像和視頻,。

Deepfakes技術發(fā)展大事記

2014:Deepfakes技術誕生

2014年,“GAN之父”Ian Goodfellow與同事發(fā)表了首篇介紹生成對抗網(wǎng)絡(GAN)的科學論文,,它就是我們今天深入討論的deepfakes的技術基礎,。

2015年:GAN越發(fā)完善

研究人員開始將GAN與經(jīng)過圖像識別優(yōu)化的多層卷積神經(jīng)網(wǎng)絡(CNN)相結合。CNN能夠并行處理大量數(shù)據(jù),,而且在顯卡上的運行效率特別高,。這一組合取代了以往較為簡單的GAN代理驅動網(wǎng)絡,也讓生成結果的可信度邁上新的臺階,。

2017年:第一段Deepfakes視頻誕生

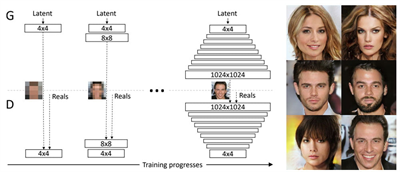

生成器代理通常會生成低分辨率的圖像,,因為越清晰越容易被檢測出問題,只有這樣,,檢查代理才難以檢測內(nèi)容的真?zhèn)?。Nvidia通過分階段訓練網(wǎng)絡:先由偽造AI學習創(chuàng)建低分辨率圖像,然后,,將分辨率逐漸提升,,以此推動Deepfakes仿真能力實現(xiàn)了質的飛躍。自此,,Deepfakes一詞就成了AI生成圖像和視頻的代名詞,。

2018年:Deepfakes登陸YouTube頻道

此后,Nvidia研究人員進一步提升GAN控制能力,,他們可以針對單一圖像特征(例如人像中的“黑發(fā)”和“微笑”)做出調整,。通過這種方式,,可以將訓練圖像的特征有針對性地轉移到AI生成圖像上。與此同時,,首個專門研究Deepfakes的YouTube頻道正式上線,,包括了各種類型的視頻。

【網(wǎng)絡轉移可用于控制圖像AI,,例如僅創(chuàng)建微笑著的人像】

2019年:Deepfakes成為主流

拋開技術進步不談,,2019年是deepfakes正式成為主流的一年。網(wǎng)絡上Deepfakes數(shù)量快速增加,,Deepfakes的技術發(fā)展速度超出了預期,,技術專家Hao Li甚至大膽預測,Deepfakes將在很快走向完美,。

2020年:對Deepfakes提出監(jiān)管

Facebook在2020年美國大選開始時宣布,,將在自家平臺上全面禁止deepfakes——諷刺或戲仿性質的Deepfakes除外,;YouTube也采取了類似的指導方針,;Twitter則開始執(zhí)行其2019年推出的管理Deepfakes準則;當年8月,,TikTok也開始禁止其視頻平臺違規(guī)使用Deepfakes技術,。

在這一年,Jigsaw公司正式發(fā)布了一款由AI驅動的檢測工具Assembler,,可幫助管理者檢測出Deepfakes圖像,。高通則投資了一家初創(chuàng)公司,該公司能夠以不可撤銷的方式將原始照片及視頻標記為“原創(chuàng)”,,從而降低后續(xù)的Deepfakes識別難度,。

目前階段

Deepfakes技術本身仍在繼續(xù)發(fā)展,微軟已經(jīng)正式推出了FaceShifter,,能夠將模糊的原始圖像處理為可信的偽造畫面,。娛樂巨頭迪士尼也開始在電影制作中廣泛應用Deepfakes技術,并推出了百萬像素級Deepfakes視頻制作工具,。這一切,,都為Deepfakes可能被利用的犯罪活動創(chuàng)造了條件。

今年6月,,F(xiàn)BI發(fā)布公告,,提醒公眾警惕在遠程求職面試中使用Deepfakes技術假扮成他人的情況。這些職位大多與信息技術,、系統(tǒng)開發(fā),、數(shù)據(jù)庫以及軟件管理相關。如果這些詐騙者成功過關,,將有權訪問目標企業(yè)的敏感數(shù)據(jù),,包括客戶 PII(個人身份信息),、財務數(shù)據(jù)、公司IT數(shù)據(jù)庫和/或專有信息,。

Deepfakes威脅日益增加

經(jīng)過多年的發(fā)展,,現(xiàn)在的Deepfakes技術已經(jīng)從“一眼假”變成真?zhèn)文娴摹皩崟r換臉”,而且門檻極低,,只需要通過一款軟件,,幾張圖片,即可一鍵生成,。而一系列的網(wǎng)絡安全事件也充分表明,,Deepfakes引發(fā)的信任安全危機可能才剛剛開始。

根據(jù)VMware最新發(fā)布的《年度全球事件響應威脅報告》顯示,,去年,,使用面部和語音替換技術進行網(wǎng)絡攻擊的數(shù)量增長了13%。其中,,電子郵件是Deepfakes攻擊的主要傳遞載體,,占整體攻擊數(shù)量的78%,這與商業(yè)電子郵件入侵(BEC)嘗試的持續(xù)增加有關,。

此外,,在接受研究人員調查的網(wǎng)絡安全專業(yè)人士中,有66%的受訪人表示他們在過去一年中發(fā)現(xiàn)了至少一起此類事件,。事實再次證明,,Deepfakes技術用于網(wǎng)絡攻擊已經(jīng)從理論威脅演變成了現(xiàn)實危害。

早在2019年,,美國國土安全部就對Deepfakes技術的應用安全性提出了質疑,,稱“使用該技術騷擾或傷害他人利益的現(xiàn)象應當引起公眾重視”。然而,,用于分辨Deepfakes偽造視頻的技術目前還尚未成熟,。

根據(jù)威脅情報公司Sensity發(fā)布的一份最新研究報告顯示,Deepfakes檢測算法和軟件有86%的幾率會將經(jīng)Deepfakes偽造處理過的視頻認定為“真”,。而2022年3月卡內(nèi)基梅隆大學的研究指出,,對比市面上各種Deepfakes技術檢測產(chǎn)品的算法和硬件基礎發(fā)現(xiàn),其準確度在30%-90%之間浮動,。

更重要的是,,隨著Deepfakes技術的快速發(fā)展,也許未來再精密的Deepfakes檢測算法也無法準確地識別真?zhèn)?。這意味著Deepfakes技術將最終改變游戲規(guī)則——無論是社交還是娛樂方面,。Deepfakes專家Hao Li認為,這種發(fā)展趨勢是完全有可能的,,因為圖像的實質不過是輔以適當顏色的像素,,AI找到完美的副本只是時間問題,。

此外,短視頻的盛行,,以及Reface或Impressions等應用的普及,,使得偽造圖像和視頻正變得司空見慣。過去,,人們堅信“耳聽為虛,,眼見為實”,而現(xiàn)在,,可能正如GAN之父Ian Goodfellow所言,,“AI也許正在關閉我們這一代觀察世界的大門?!?/p>

積極防御Deepfakes應用風險

雖然Deepfakes技術在應用時產(chǎn)生的威脅看起來很嚴重,,不過,我們也并非完全無計可施,。FBI在之前的公告中就指出,,雖然一些Deepfakes視頻處理的極為逼真,但并未達到完美無瑕的程度,。通過一些不正常的眨眼,、不正常的光線,、不協(xié)調的聲音,,以及咳嗽、打噴嚏等動作細節(jié),,都可識別出視頻的真假,。在時長超過10s的視頻畫面中,發(fā)現(xiàn)這些破綻并不難,。

同時,,企業(yè)組織還可以采取多種措施來抵御它們,包括培訓和教育,、先進技術以及威脅情報等,,從而在一定程度上抑制惡意的Deepfakes活動:

首先,教育和培訓員工有關Deepfakes社交工程攻擊(尤其是那些最有針對性的攻擊)的知識是降低風險的一個重要因素,,而且必須將重點放在財務部門相關員工身上,,并且經(jīng)常性提醒他們注意這種可能性;

其次,,在技術方面,,建議企業(yè)組織部署更多的分析系統(tǒng),以及時發(fā)現(xiàn)異常偽造行為等,。Deepfakes欺詐活動一般需要時間來設置和執(zhí)行,,這讓潛在受害者有足夠的時間來發(fā)現(xiàn)警告信號并采取行動,;

除此之外,企業(yè)還可以通過隨機分配用戶指令來實現(xiàn)有效防御,。因為Deepfakes創(chuàng)作者無法預測數(shù)以千計的可能請求,。雖然犯罪分子可以實時操縱Deepfakes,但視頻質量會顯著下降,,因為Deepfakes技術所需的強大處理能力使其無法快速做出反應,。在此情況下,反復響應錯誤的用戶可以被標記,,并進行進一步調查,。

更多信息可以來這里獲取==>>電子技術應用-AET<<