本文討論的是機(jī)器學(xué)習(xí)中的公平公正問題(Bias and Fairness in Machine Learning),那么,究竟什么是機(jī)器學(xué)習(xí)中的公平公正呢?

隨著人工智能系統(tǒng)和應(yīng)用程序在我們?nèi)粘I钪械膹V泛應(yīng)用,人工智能已經(jīng)成為了輔助人們決策的重要工具,例如,使用推薦系統(tǒng)算法做出電影推薦、購(gòu)買產(chǎn)品推薦等,使用預(yù)測(cè)和分析系統(tǒng)用于貸款申請(qǐng)、約會(huì)和雇傭等高風(fēng)險(xiǎn)決策。美國(guó)法院使用了一款人工智能軟件—「選擇性制裁罪犯管理檔案」(Correctional Offender Management Profiling for Alternative Sanctions,COMPAS),用于預(yù)測(cè)一個(gè)人再次犯罪的風(fēng)險(xiǎn),輔助法官?zèng)Q定是釋放罪犯,還是把罪犯關(guān)進(jìn)監(jiān)獄。對(duì)該軟件的一項(xiàng)調(diào)查發(fā)現(xiàn)了對(duì)非洲裔美國(guó)人的一種偏見:相較于白人罪犯,COMPAS 更有可能給非洲裔美國(guó)人罪犯打出較高的潛在風(fēng)險(xiǎn)分?jǐn)?shù),從而不予以釋放 [1]。

有偏的訓(xùn)練數(shù)據(jù)集一般被認(rèn)為是影響機(jī)器學(xué)習(xí)公平公正的重要因素之一。大多數(shù)機(jī)器學(xué)習(xí)模型都是通過在大型有標(biāo)記數(shù)據(jù)集上訓(xùn)練得到的。例如,在自然語言處理中,標(biāo)準(zhǔn)的算法是在包含數(shù)十億單詞的語料庫(kù)上訓(xùn)練的。研究人員通常通過抓取網(wǎng)站 (如谷歌圖像和谷歌新聞)、使用特定的查詢術(shù)語,或通過聚合來自維基百科 (Wikipedia) 等來源的易于訪問的信息來構(gòu)建此類數(shù)據(jù)集。然后,由研究生或通過 Amazon Mechanical Turk 等眾包平臺(tái)對(duì)這些數(shù)據(jù)集進(jìn)行注釋和標(biāo)記。

在醫(yī)學(xué)領(lǐng)域,由于醫(yī)療數(shù)據(jù)的生成和標(biāo)記成本非常高,機(jī)器學(xué)習(xí)特別容易受到有偏見訓(xùn)練數(shù)據(jù)集的影響。去年,研究人員利用深度學(xué)習(xí)從照片中識(shí)別皮膚癌。他們對(duì) 129,450 張圖像的數(shù)據(jù)集進(jìn)行訓(xùn)練,其中 60% 是從谷歌圖像中提取的。在這個(gè)數(shù)據(jù)集中只有不到 5% 的圖像是深膚色的個(gè)體,而且該算法沒有在深膚色的人身上進(jìn)行測(cè)試。因此,將該深度學(xué)習(xí)分類器應(yīng)用在不同的種群中可能會(huì)存在巨大的差異。

用于圖像分類的深度神經(jīng)網(wǎng)絡(luò)通常是在 ImageNet 上訓(xùn)練的,ImageNet 是一套包含 1400 多萬張標(biāo)記圖像的集合。ImageNet 中 45% 以上的數(shù)據(jù)來自美國(guó),而美國(guó)人口僅占世界人口的 4%。與此形成對(duì)比的是,盡管中國(guó)和印度的人口占世界人口的 36%,但兩國(guó)在 ImageNet 的數(shù)據(jù)中只占 3%。在這樣的數(shù)據(jù)集中訓(xùn)練得到的計(jì)算機(jī)視覺模型,把傳統(tǒng)的美國(guó)新娘穿著白色衣服的照片標(biāo)記為「新娘」、「服裝」、「女人」、「婚禮」,而把印度北部新娘的照片標(biāo)記為「行為藝術(shù)」和「服裝」。圖 1 是 Nature 上一篇報(bào)道中給出的一幅圖片,在有偏數(shù)據(jù)集上訓(xùn)練的算法通常只將左側(cè)的圖片識(shí)別為新娘 [2]。

圖 1. 在有偏數(shù)據(jù)集上訓(xùn)練的算法通常只將左手圖像識(shí)別為新娘 [2]

影響機(jī)器學(xué)習(xí)公平公正的另外一個(gè)重要因素是機(jī)器學(xué)習(xí)算法本身。一個(gè)經(jīng)典機(jī)器學(xué)習(xí)的算法總是試圖最大限度地提高在訓(xùn)練數(shù)據(jù)集中的總體預(yù)測(cè)精度。如果一組特定的個(gè)體在訓(xùn)練數(shù)據(jù)集中出現(xiàn)的頻率高于其他個(gè)體,那么算法將會(huì)針對(duì)這些個(gè)體進(jìn)行優(yōu)化,從而提高算法整體準(zhǔn)確度。在實(shí)驗(yàn)環(huán)境下,研究人員使用測(cè)試數(shù)據(jù)集進(jìn)行評(píng)估以驗(yàn)證算法的有效性,但是測(cè)試集通常是原始訓(xùn)練數(shù)據(jù)集的隨機(jī)子樣本,因此可能包含相同的偏見。

為了確保機(jī)器學(xué)習(xí)的公平公正,研究人員認(rèn)為主要有三種途徑:一是提高用于訓(xùn)練機(jī)器學(xué)習(xí)算法的數(shù)據(jù)質(zhì)量,公平、廣泛的收集不同來源的數(shù)據(jù),使用標(biāo)準(zhǔn)化的元數(shù)據(jù)系統(tǒng)地標(biāo)注訓(xùn)練數(shù)據(jù)集的內(nèi)容。二是改進(jìn)機(jī)器學(xué)習(xí)算法本身。整合約束條件,從本質(zhì)上使得機(jī)器學(xué)習(xí)算法在不同的子群體和相似的個(gè)體之間實(shí)現(xiàn)公平的性能;改變學(xué)習(xí)算法,減少對(duì)敏感屬性的依賴,比如種族、性別、收入——以及任何與這些屬性相關(guān)的信息。三是使用機(jī)器學(xué)習(xí)本身來識(shí)別和量化算法和數(shù)據(jù)中的偏見,即開展人工智能審計(jì),其中審計(jì)人員是一個(gè)系統(tǒng)地探測(cè)原始機(jī)器學(xué)習(xí)模型的算法,以識(shí)別模型和訓(xùn)練數(shù)據(jù)中的偏見。

本文重點(diǎn)談?wù)摍C(jī)器學(xué)習(xí)中算法的公平公正問題,我們選擇了 ICML 2019 的三篇文章,分別針對(duì)機(jī)器學(xué)習(xí)領(lǐng)域中的圖嵌入問題、回歸問題,以及自然語言處理領(lǐng)域中的語言模型問題展開了討論。

1、Compositional Fairness Constraints for Graph Embeddings

https://arxiv.org/pdf/1905.10674v1.pdf

本文是 Facebook 發(fā)表在 ICML 2019 中的一篇文章,針對(duì)現(xiàn)有的圖嵌入(Graph Embedding)算法無法處理公平約束的問題,例如確保所學(xué)習(xí)的表示與某些屬性 (如年齡或性別) 不相關(guān),通過引入一個(gè)對(duì)抗框架來對(duì)圖嵌入實(shí)施公平性約束。本文的研究?jī)?nèi)容屬于 (社會(huì)) 圖嵌入和算法公平性研究的交叉領(lǐng)域。

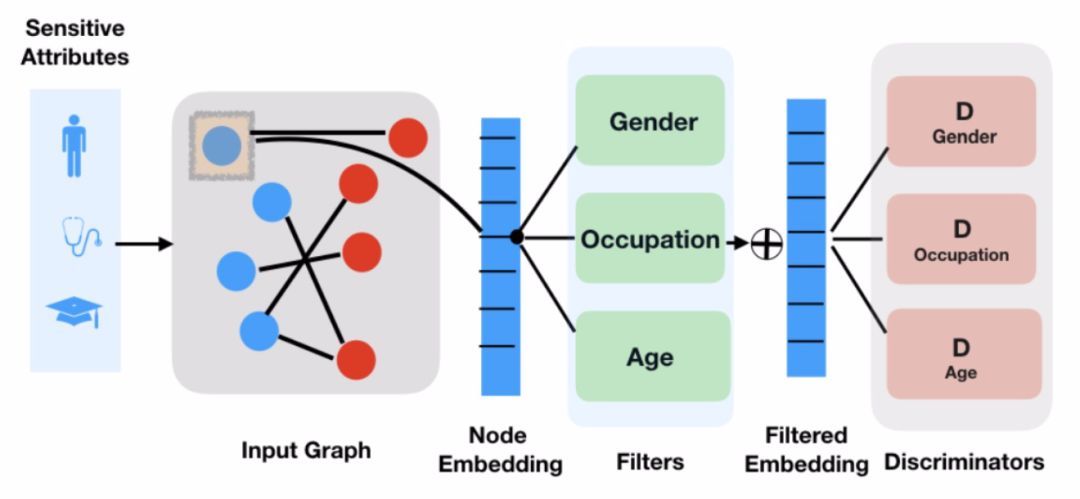

學(xué)習(xí)圖中節(jié)點(diǎn)的低維嵌入是目前最先進(jìn)的應(yīng)用于預(yù)測(cè)和推薦系統(tǒng)的方法。在實(shí)際應(yīng)用中,特別是涉及到社交圖的應(yīng)用中,需要有效控制學(xué)習(xí)到的節(jié)點(diǎn)嵌入中所包含的信息。以推薦系統(tǒng)為例,人們希望能夠保證推薦是公平的而不依賴于用戶的種族或性別,此外,也希望能夠在不暴露自身屬性的前提下學(xué)習(xí)節(jié)點(diǎn)嵌入表示以保證隱私。本文的工作聚焦于對(duì)社會(huì)圖(Social Graph)加入不變性約束的可行性,即生成對(duì)特定敏感信息 (例如,年齡或性別) 不變的圖嵌入。首先訓(xùn)練得到一組「過濾器」,以防止對(duì)抗式的甄別者將敏感信息與過濾后的嵌入信息進(jìn)行分類。然后,將過濾器以不同的方式組合在一起,靈活生成對(duì)任何敏感屬性子集不變的嵌入。方法的整體結(jié)構(gòu)見圖 2。

圖 2. 方法整體結(jié)構(gòu)

早期關(guān)于在社會(huì)類應(yīng)用中增加強(qiáng)制不變性約束 (或「公平性」) 的工作通常只涉及一個(gè)敏感屬性的情況,但是實(shí)際應(yīng)用中通常社會(huì)圖嵌入會(huì)涉及到多個(gè)屬性。在極端情況下,可能希望不只是節(jié)點(diǎn),甚至是圖中的邊(edge)也具備公平性,例如,一個(gè)社交網(wǎng)絡(luò)平臺(tái)上的用戶可能希望該平臺(tái)的推薦系統(tǒng)忽略他們與某個(gè)其他用戶是朋友,或者他們參與了某個(gè)特定內(nèi)容的事實(shí)。本文提出的方法通過學(xué)習(xí)得到一組對(duì)抗性過濾器,從而刪除關(guān)于特定敏感屬性的信息。

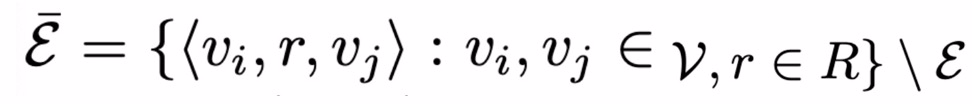

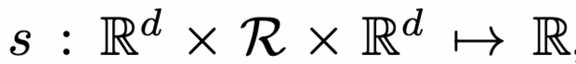

首先,考慮嵌入一個(gè)異質(zhì)或多關(guān)系 (社會(huì)) 圖 G = (V, e),G 包含有向邊三元組 e= < u,r, v >,其中 u, v∈V 為節(jié)點(diǎn),r∈R 表示節(jié)點(diǎn)間的關(guān)系。假定每個(gè)節(jié)點(diǎn)都屬于一個(gè)特定的類別,節(jié)點(diǎn)間的關(guān)系受到節(jié)點(diǎn)類型的約束。基于圖的關(guān)系預(yù)測(cè)任務(wù)描述如下:ξ_train 表示訓(xùn)練邊集合,定義負(fù)邊集合如下:

負(fù)邊集合表示未在真實(shí)圖 G 中出現(xiàn)的邊的集合。給定ξ_train,目標(biāo)是學(xué)習(xí)得到評(píng)分函數(shù) s 以滿足:

換句話說,學(xué)習(xí)得到的評(píng)分函數(shù)在理想情況下應(yīng)該對(duì)任何真邊緣評(píng)分高于任何假邊緣。

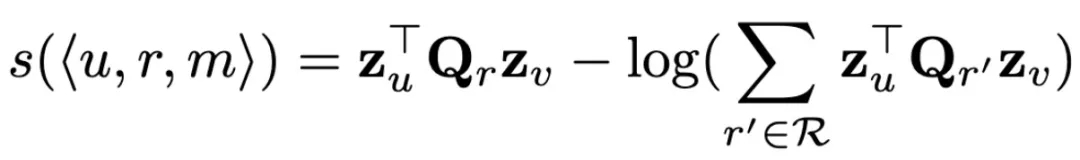

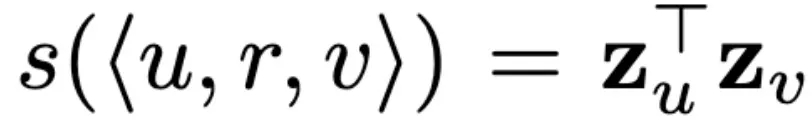

圖嵌入(Graph Embedding)的任務(wù)目標(biāo)是通過學(xué)習(xí)一個(gè)映射函數(shù) ENC 來完成關(guān)系預(yù)測(cè)任務(wù),即將節(jié)點(diǎn) v 映射為節(jié)點(diǎn)嵌入 z_v=ENC(v)。此時(shí)評(píng)分函數(shù)為:

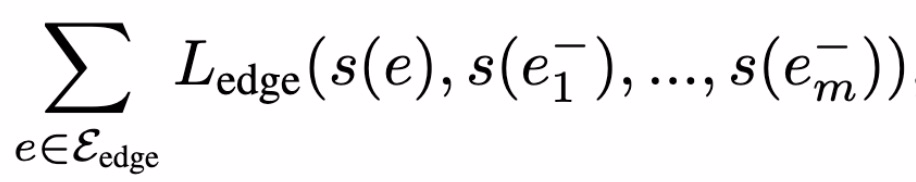

評(píng)分函數(shù)的含義為:給定兩個(gè)節(jié)點(diǎn)嵌入 z_u ∈ R.^d 和 z_v∈ R.^d,以及它們之間的關(guān)系 r ∈ R,評(píng)分函數(shù) s 表示邊 e=<u,r,v> 在圖中存在的概率 ( s∈ R)。通常來講,基于圖嵌入模型的方法主要是認(rèn)為兩個(gè)節(jié)點(diǎn)嵌入間的距離能夠表征兩個(gè)節(jié)點(diǎn)間存在邊的可能性。本文利用噪聲對(duì)比估計(jì)等破壞分布的對(duì)比學(xué)習(xí)方法來優(yōu)化評(píng)分函數(shù),目的是最大化真實(shí)邊(正樣本)與虛假邊(負(fù)樣本)對(duì)比的概率。其中,邊(e_batch ? e_train)的損失函數(shù)計(jì)算為:

以及

表示負(fù)樣本,例如,不存在于圖中的隨機(jī)樣本邊。

考慮公平性的處理,對(duì)一個(gè)節(jié)點(diǎn)類型,假設(shè)屬于該類型的全部節(jié)點(diǎn)都包含有 K 組敏感屬性,那么對(duì)圖嵌入模型進(jìn)行公平性處理的任務(wù)就是確保所學(xué)習(xí)的節(jié)點(diǎn)嵌入 (z_u) 在這些敏感屬性方面不存在偏見或不公平。

不變的實(shí)用公平性

本文給出了一個(gè)簡(jiǎn)單的以用戶為中心的社會(huì)圖嵌入場(chǎng)景。以性別為敏感屬性、電影推薦為關(guān)系預(yù)測(cè)任務(wù)的例子,具體任務(wù)場(chǎng)景如下:如果給用戶一個(gè)按鈕,上面寫著「推薦電影時(shí)請(qǐng)忽略我的性別」,那么按下這個(gè)按鈕后,用戶希望從系統(tǒng)中得到什么?很顯然,用戶 u 的目的是系統(tǒng)能夠不考慮他們的性別公平地向他(她)推薦電影,即如下式:

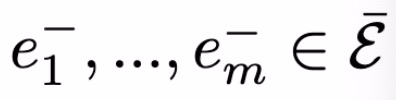

其中 s(e) = s(<z_u, r, z_v>),a_u 為敏感屬性。如果直接處理上式,我們能夠發(fā)現(xiàn)一個(gè)明顯的問題,即對(duì)于每一個(gè)節(jié)點(diǎn)都需要對(duì)它的全部邊(可能是數(shù)以百萬計(jì))進(jìn)行評(píng)分。假設(shè)認(rèn)為 s(e) 僅由 u 決定(忽略掉節(jié)點(diǎn) v 的影響),則可以通過實(shí)施表征不變性來保證上式對(duì)于所有邊緣預(yù)測(cè)的獨(dú)立性:

此時(shí)滿足互信息(mutual Information):I(z_u,a_u)=0。推廣到多個(gè)敏感屬性 S? {1,...,K}:

上式相當(dāng)于對(duì) S 個(gè)不同敏感屬性的 S 獨(dú)立不變性約束的假設(shè)。針對(duì)本文所討論的應(yīng)用場(chǎng)景,S 不是固定不變的。對(duì)于不同的用戶來說,他們所認(rèn)為的敏感屬性可能不同(年齡,職業(yè),性別等等)。基于上述分析,本文在上式中引入一種對(duì)抗性損失和一種「過濾」嵌入,從而對(duì)節(jié)點(diǎn)嵌入施加表征不變性約束。

復(fù)合編碼器

首先,將 ENC 嵌入函數(shù)泛化,以選擇性地「過濾」掉有關(guān)某些敏感屬性的信息。對(duì)每一個(gè)敏感屬性 k∈{1,...,K},定義一個(gè)過濾函數(shù) f_k,通過訓(xùn)練 f_k 能夠去除掉與敏感屬性 k 有關(guān)系的信息。為了保證節(jié)點(diǎn)嵌入的不變性,本文使用復(fù)合編碼器組合過濾后的嵌入:

在組合映射函數(shù)(C-ENC)的訓(xùn)練迭代過程中,每輪迭代都通過采樣二進(jìn)制掩碼來確定集合 S。本文將二進(jìn)制掩碼采樣為一個(gè)固定概率 p=0.5 的伯努利序列。在訓(xùn)練過程中,隨機(jī)采樣得到的二進(jìn)制掩碼能夠使得模型產(chǎn)生不同敏感性屬性組合的不變嵌入,從而實(shí)現(xiàn)在推理過程中推廣到未知的組合。

對(duì)抗損失

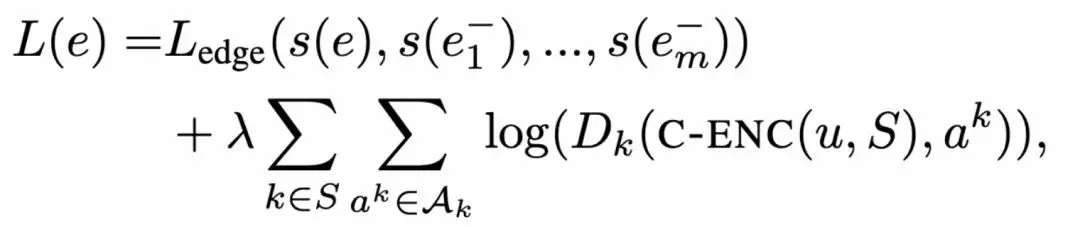

本文引入對(duì)抗正則項(xiàng)訓(xùn)練復(fù)合編碼器 Dk。為每個(gè)敏感屬性 k 定義一個(gè)分類器 D_k,目的是通過節(jié)點(diǎn)嵌入預(yù)測(cè)第 k 個(gè)敏感屬性 D_k : R^d × A_k → [0, 1],其中,D_k 的概率區(qū)間為 [0,1]。給定邊預(yù)測(cè)損失函數(shù) L_edge,對(duì)抗正則化損失函數(shù)為:

其中,λ控制對(duì)抗正則項(xiàng)的強(qiáng)度。為了在小批量設(shè)置的情況下優(yōu)化該損失,本文定義兩種交替執(zhí)行的隨機(jī)梯度下降更新方法:(1)T 小批量更新:基于 C-ENC(Dk 恒定不變)優(yōu)化 L(e);(2)T』小批量更新:基于 Dk(C-ENC 恒定不變)優(yōu)化 L(e)。

本文在三個(gè)數(shù)據(jù)庫(kù)中進(jìn)行實(shí)驗(yàn),F(xiàn)reebase15k-237、MovieLens-1M,以及從 Reddit 中整理得到的邊緣預(yù)測(cè)數(shù)據(jù)庫(kù)。三個(gè)庫(kù)的統(tǒng)計(jì)信息如表 1 所示(具體包括全部節(jié)點(diǎn)數(shù)量(|v|),帶有敏感屬性的節(jié)點(diǎn)數(shù)量(|T*|),敏感屬性的數(shù)目及其類型和圖中邊緣的總數(shù)):

表 1. 數(shù)據(jù)庫(kù)詳細(xì)情況

(1)FREEBASE15K-237

FREEBASE15K-237 是一個(gè)標(biāo)準(zhǔn)的知識(shí)基準(zhǔn)庫(kù) [9],本文使用該庫(kù)評(píng)估對(duì)抗正規(guī)化的影響,在完成標(biāo)準(zhǔn)的知識(shí)庫(kù)任務(wù)的同時(shí),保持實(shí)體嵌入與「敏感」屬性標(biāo)簽的不變性。在本庫(kù)中,確定三個(gè)常見的屬性標(biāo)簽:/award/award_nominee,作為敏感屬性。

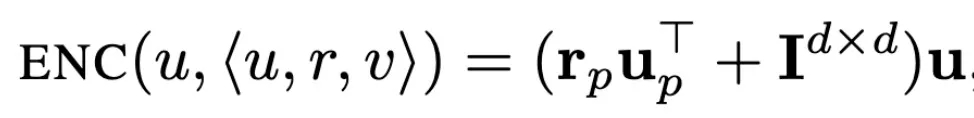

在實(shí)驗(yàn)過程中,本文采用聯(lián)合訓(xùn)練主模型和對(duì)抗框架的方式,但在測(cè)試不變性時(shí),本文訓(xùn)練一個(gè)新分類器 (與鑒別器具有相同的能力) 從所學(xué)習(xí)的嵌入中預(yù)測(cè)敏感屬性。此外,在這些實(shí)驗(yàn)中,本文依賴于兩個(gè)基線:首先,對(duì)比不包含任何不變性約束的基線方法,即λ= 0。其次,與一種非復(fù)合對(duì)抗的基線方法進(jìn)行對(duì)比,即分別訓(xùn)練 K 個(gè)不同的編碼器和 K 個(gè)不同的對(duì)抗框架。使用 Relu 激活函數(shù)的多層感知機(jī)(Multi-layer perceptrons,MLP)作為分類器 Dk 和過濾器 f_k[7]。使用 TransD 方法計(jì)算編碼器和邊緣預(yù)測(cè)損失函數(shù) [8]。在這個(gè)模型中,一個(gè)節(jié)點(diǎn)/實(shí)體的編碼取決于預(yù)先決定的邊緣關(guān)系,以及該實(shí)體是一個(gè)關(guān)系中的頭還是尾。頭節(jié)點(diǎn)的嵌入 (即邊關(guān)系中的源節(jié)點(diǎn)) 由下式計(jì)算:

其中,u、u_p、r_p 為可訓(xùn)練的嵌入?yún)?shù),I 為 d 維單位矩陣。編碼函數(shù)對(duì)尾部節(jié)點(diǎn)進(jìn)行了類比定義。評(píng)分函數(shù)定義為:

其中,r 為另外一個(gè)可訓(xùn)練的嵌入?yún)?shù)(每個(gè)關(guān)系)。最后,使用標(biāo)準(zhǔn)的最大邊際損失函數(shù)如下:

![]()

(2)MOVIELENS-1M

MOVIELENS-1M 是一個(gè)標(biāo)準(zhǔn)的推薦系統(tǒng)數(shù)據(jù)庫(kù),其目標(biāo)是預(yù)測(cè)用戶對(duì)電影的評(píng)分,將用戶年齡、性別和職業(yè)作為敏感屬性。在本庫(kù)中的任務(wù)可以做如下描述:將電影推薦任務(wù)視為用戶和電影之間的邊緣預(yù)測(cè)問題,將不同的可能評(píng)級(jí)視為不同的邊緣關(guān)系。

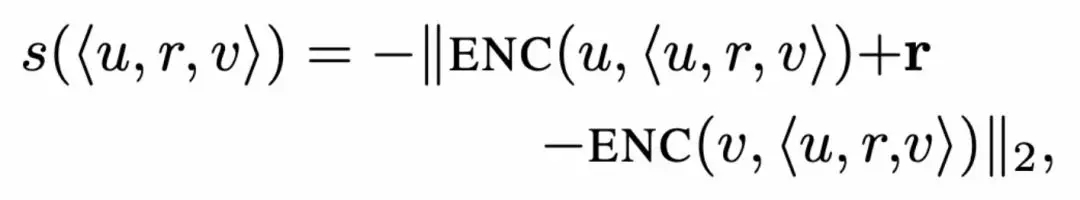

在本庫(kù)中的實(shí)驗(yàn)采用簡(jiǎn)單的「嵌入-查找(Embedding-Lookup)」編碼器,將每個(gè)用戶和電影與一個(gè)唯一的嵌入向量關(guān)聯(lián)起來。評(píng)分階段,使用對(duì)數(shù)似然法計(jì)算如下:

其中,關(guān)系矩陣 Qr 為:

其中,a_r,1、P1、P2 均為可訓(xùn)練的參數(shù)。損失函數(shù)使用簡(jiǎn)單的負(fù)對(duì)數(shù)似然法。

(3)REDDIT

本文最后使用的數(shù)據(jù)庫(kù)是基于 REDDIT 獲取的,REDDIT 是一個(gè)廣受歡迎的、以討論為基礎(chǔ)的網(wǎng)站,用戶可以在這里對(duì)不同話題社區(qū)的內(nèi)容進(jìn)行發(fā)布和評(píng)論。對(duì)于這個(gè)數(shù)據(jù)集,考慮一個(gè)傳統(tǒng)的邊緣預(yù)測(cè)任務(wù),其目標(biāo)是預(yù)測(cè)用戶和網(wǎng)站社區(qū)之間的交互情況。通過檢查 2017 年 11 月以來的所有情況,如果用戶在這段時(shí)間內(nèi)至少在某社區(qū)出現(xiàn)過一次,就會(huì)在該用戶和該社區(qū)之間設(shè)置一個(gè)邊。然后,將圖中的低分?jǐn)?shù)節(jié)點(diǎn)去掉,最終得到一個(gè)包含 366K 個(gè)用戶、18K 個(gè)社區(qū)、7M 邊緣的圖。基于該圖,實(shí)驗(yàn)的主要任務(wù)是構(gòu)建邊緣預(yù)測(cè)模型,基于 90% 的用戶-社區(qū)邊緣情況預(yù)測(cè)剩余的缺失邊緣。

將某些社區(qū)節(jié)點(diǎn)看作是「敏感」節(jié)點(diǎn),將是否與這些敏感社區(qū)有邊緣連接看作是用戶的敏感屬性。所謂的公平性目標(biāo)是指模型的預(yù)測(cè)結(jié)果不受用戶是否訪問過某特定社區(qū)的情況影響。

在本數(shù)據(jù)庫(kù)中的實(shí)驗(yàn)采用的是簡(jiǎn)單的「嵌入-查找(Embedding-Lookup)」編碼器,使用簡(jiǎn)單點(diǎn)積評(píng)分函數(shù):

以及最大邊際損失函數(shù):

![]()

最后,本文給出了三類公平性實(shí)驗(yàn),

Q1:不變性的成本

為了量化學(xué)習(xí)到的嵌入對(duì)敏感屬性的不變性程度,凍結(jié)編碼器 C-ENC、訓(xùn)練一個(gè)新的 MLP 分類器預(yù)測(cè)每個(gè)過濾后嵌入的敏感屬性。此外,評(píng)估使用這些過濾嵌入對(duì)原始預(yù)測(cè)任務(wù)的性能。理想情況下,訓(xùn)練得到的新 MLP 應(yīng)當(dāng)能夠在預(yù)測(cè)敏感屬性時(shí)具有隨機(jī)準(zhǔn)確性,此外,這些嵌入能夠較好地完成原有的邊緣預(yù)測(cè)任務(wù)。

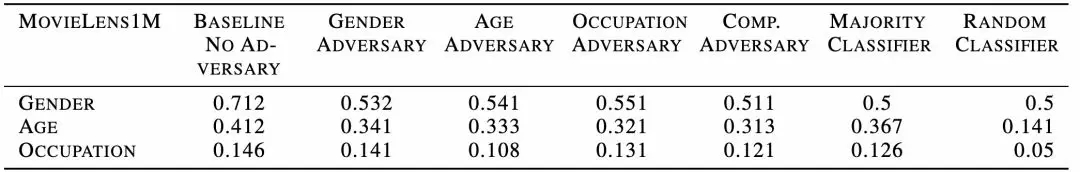

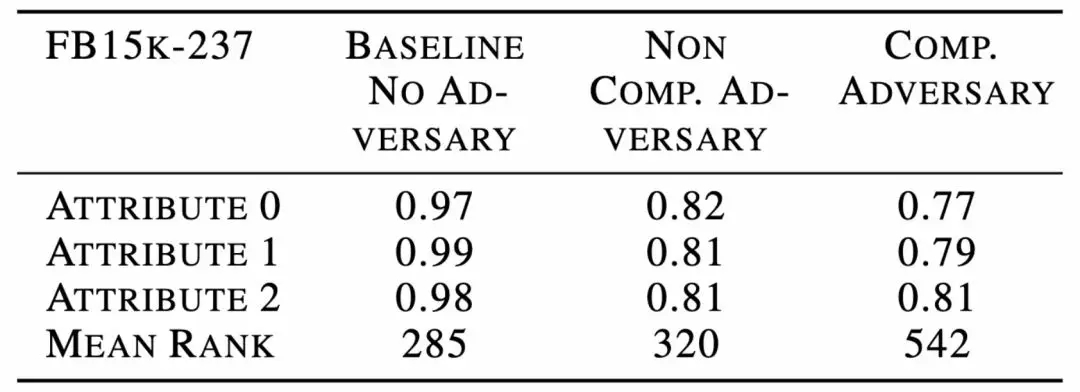

總的來說,本文實(shí)驗(yàn)結(jié)果表明,在社會(huì)推薦數(shù)據(jù)集上,包括 MovieLens-1M 和 REDDIT,本文的方法能夠?qū)崿F(xiàn)一個(gè)合理的折衷,即幾乎完全刪除敏感信息,同時(shí)保證邊緣預(yù)測(cè)任務(wù)的相對(duì)誤差只增加約 10%。表 2 給出在使用各種嵌入方法時(shí),預(yù)測(cè) MovieLens 數(shù)據(jù)上的敏感屬性的情況。由表 2 結(jié)果可知,敏感屬性的分類準(zhǔn)確度與多數(shù)投票分類器的分類準(zhǔn)確度相當(dāng),使用組合對(duì)抗框架的 RMSE 從 0.865 下降到 1.01。表 3 給出了使用不同方法完成 Freebase15k-237 庫(kù)中預(yù)測(cè)敏感屬性能力的實(shí)驗(yàn)結(jié)果。所有的敏感屬性都是二進(jìn)制的,表 3 給出了 AUC 分?jǐn)?shù)以及完成主要邊緣預(yù)測(cè)任務(wù)的平均秩。Freebase15k-237 庫(kù)中的實(shí)驗(yàn)結(jié)果顯示,如果想要消除敏感信息,必須以增加原始邊緣預(yù)測(cè)任務(wù)成本為代價(jià)。這個(gè)結(jié)果是可接受的,因?yàn)閷?duì)于這個(gè)數(shù)據(jù)集,「敏感」屬性是由實(shí)體類型注釋合成得到的,這些屬性與邊緣/關(guān)系預(yù)測(cè)主任務(wù)高度相關(guān)。這一實(shí)驗(yàn)結(jié)果也表明,基于圖嵌入的方法進(jìn)行去偏處理是存在潛在局限性的。

表 2. 預(yù)測(cè) MovieLens 數(shù)據(jù)上的敏感屬性的情況

表 3.Freebase15k-237 庫(kù)中預(yù)測(cè)敏感屬性的能力

Q2:復(fù)合框架的影響

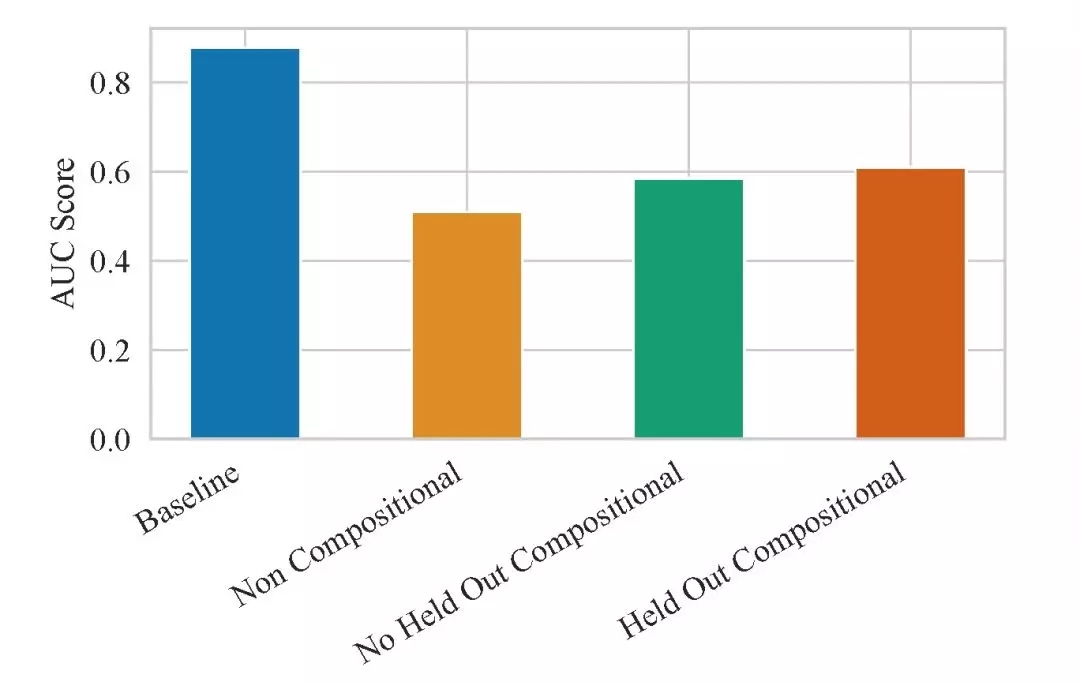

由表 2 中的實(shí)驗(yàn)結(jié)果可以看出,本文提出的復(fù)合框架效果優(yōu)于單獨(dú)對(duì)每一種屬性進(jìn)行去偏處理的效果。與單獨(dú)基于每種敏感屬性進(jìn)行對(duì)抗正則化嵌入模型訓(xùn)練相比,使用復(fù)合框架能夠去除掉更多的敏感信息,這是由于在數(shù)據(jù)庫(kù)中不同的敏感屬性,例如年齡、性別和職業(yè),是相互關(guān)聯(lián)的。圖 3 給出預(yù)測(cè) REDDIT 數(shù)據(jù)集中敏感屬性的能力,其中條形圖對(duì)應(yīng)于 10 個(gè)二進(jìn)制敏感屬性的平均 AUC。與表 2 實(shí)驗(yàn)給出的結(jié)論不同,在 REDDIT 庫(kù)中,復(fù)合框架的效果并不如單獨(dú)處理每個(gè)敏感屬性的好。這說明,本文提出的復(fù)合對(duì)抗性框架效果受到不同的數(shù)據(jù)庫(kù)特性影響。

圖 3. 使用不同嵌入方法時(shí),預(yù)測(cè) Reddit 數(shù)據(jù)集中敏感屬性的能力

Q3:對(duì)未知敏感屬性組合的不變性

使用復(fù)合編碼器的一個(gè)優(yōu)勢(shì)在于能夠生成對(duì)不同敏感屬性組合不變的嵌入。對(duì)于一個(gè)單獨(dú)的節(jié)點(diǎn),能夠生成 2^K 個(gè)獨(dú)立的嵌入。本文在 REDDIT 庫(kù)中進(jìn)行實(shí)驗(yàn),這是由于與另外兩個(gè)庫(kù)相比 REDDIT 庫(kù)的敏感屬性數(shù)量最多。由圖 3 中的實(shí)驗(yàn)可知,本文提出的方法對(duì)于未知組合的實(shí)驗(yàn)效果下降很小(0.025),表明該方法具有對(duì)未知敏感屬性組合的不變性。

小結(jié)

基于圖節(jié)點(diǎn)嵌入的圖表示學(xué)習(xí)是大規(guī)模推薦系統(tǒng)中廣泛應(yīng)用的一種重要方法,本文重點(diǎn)討論的是基于圖嵌入算法的去偏處理。該方法目前還存在很多局限性,一是,本文使用的對(duì)抗損失函數(shù)僅停留在理論分析層面,近期的研究中陸續(xù)提出了其他損失函數(shù),包括非對(duì)抗的損失函數(shù),這些損失函數(shù)是否更適合于本文所討論的問題,還缺少進(jìn)一步的分析;二是,本文討論的是針對(duì)屬性層面集合的公平性問題,對(duì)于一些子集合(由多個(gè)屬性組成的集合)層面的公平性問題,并未涉及;三是,本文是在理想實(shí)驗(yàn)條件下對(duì)不同屬性進(jìn)行的組合,這種理想條件假定的是不同屬性具有公平的組合機(jī)會(huì)。然而在實(shí)際應(yīng)用場(chǎng)景中,用戶本身就是有偏見的,例如與男性用戶相比,女性用戶搜索時(shí)會(huì)著重考慮搜索結(jié)果是否是性別公平的,這種用戶接口的偏見是否會(huì)對(duì)本文提出的框架有所影響,本文并未做討論。

2、Fair Regression: Quantitative Definitions and Reduction-Based Algorithms

![]()

https://arxiv.org/pdf/1905.12843.pdf

隨著機(jī)器學(xué)習(xí)涉及到我們生活中越來越重要的方面,包括教育、醫(yī)療、刑事司法和貸款等,越來越多的人開始關(guān)注如何確保算法公平地對(duì)待不同的亞群體用戶。這一問題,在「分類」這一機(jī)器學(xué)習(xí)應(yīng)用領(lǐng)域中的研究和討論最為廣泛,近年來已經(jīng)提出了一些衡量公平度的定量指標(biāo),由此產(chǎn)生了一系列旨在滿足這些要求的算法。然而,這些算法主要適用于離線以及小的決策問題,例如招聘、學(xué)校錄取、貸款接收/拒絕決策問題。在實(shí)際問題中,更多的分類算法是要求評(píng)估一個(gè)連續(xù)的問題,比如工作是否成功、大學(xué)一年級(jí)的平均績(jī)點(diǎn)成績(jī),以及放貸的違約風(fēng)險(xiǎn)。因此,已有的關(guān)于公平分類的算法適用范圍相當(dāng)有限。

本文的研究目的是提出一種與原有算法相比適用范圍更廣泛的、回歸任務(wù)和模型類的算法。本文將分類問題考慮為一個(gè)實(shí)值目標(biāo)預(yù)測(cè)問題(Predicting a Real-Valued Target),同時(shí)使用一個(gè)任意 Lipschitz 連續(xù)損失函數(shù)來度量預(yù)測(cè)質(zhì)量。每個(gè)樣本中都包含有一個(gè)受保護(hù)的屬性,例如種族、性別,算法的目標(biāo)是保證這些屬性的公平性。本文主要研究?jī)深惞絾栴}:統(tǒng)計(jì)奇偶性 (Statistical Parity,SP),預(yù)測(cè)結(jié)果在統(tǒng)計(jì)上依賴于受保護(hù)的屬性;有界群體損失 (Bounded Group Loss,BGL),任何受保護(hù)群體的預(yù)測(cè)誤差都低于某個(gè)預(yù)先指定的水平。本文將公平回歸(Fair Regression)定義為在這些約束條件下最小化實(shí)值預(yù)測(cè)的預(yù)期損失任務(wù)。針對(duì)兩類公平問題,本文提出了不同的算法:對(duì)于 BGL,本文提出在每個(gè)子種群中,受損失約束的損失最小化問題可以通過算法簡(jiǎn)化為一個(gè)加權(quán)損失最小化問題。對(duì)于 SP,如果我們將實(shí)值預(yù)測(cè)空間離散化,那么在一定的約束條件下,公平回歸的任務(wù)可以簡(jiǎn)化為代價(jià)敏感的分類問題。

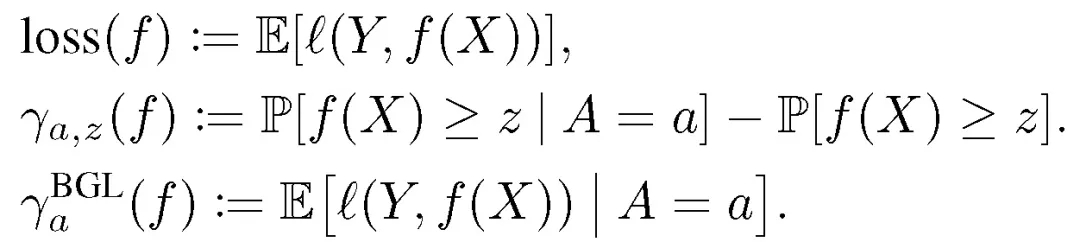

假定我們要解決的是一般的數(shù)據(jù)預(yù)測(cè)問題,模型輸出值是實(shí)數(shù)。我們首先定義損失函數(shù)。假定訓(xùn)練樣本為 (X,A,Y),其中,X 為特征向量,A 為受保護(hù)的屬性(有限值),Y 為標(biāo)記,X 為連續(xù)高維向量。A 可屬于 X 也可不屬于,Y 可為連續(xù)值也可為離散值。給定一個(gè)預(yù)測(cè)函數(shù) f:X→[0,1],算法目標(biāo)是給定 X,找到滿足公平性原則(SP/BGL)的能夠準(zhǔn)確預(yù)測(cè) Y 的預(yù)測(cè)函數(shù) f。與之前算法討論的問題不同,Y 和 f(X)都為實(shí)值函數(shù)。f(X) 預(yù)測(cè) Y 的準(zhǔn)確度由損失函數(shù) l(Y,f(X)) 衡量。一般性地,損失函數(shù)要求滿足 l1 范數(shù)的 1-Lipschitz 約束:

公平性定義

本文中進(jìn)行公平性分類和回歸過程,使用了兩個(gè)基本的定量統(tǒng)計(jì)定義:

SP (Statistical parity):預(yù)測(cè)函數(shù) f 如果獨(dú)立于某個(gè)受保護(hù)的屬性 A,即預(yù)測(cè)函數(shù) f 滿足 (X,A,Y) 上分布的統(tǒng)計(jì)奇偶性,與受保護(hù)屬性無關(guān),我們就說該函數(shù)滿足 SP 要求。當(dāng) f(X)∈[0,1] 時(shí),我們有:P[f(X)≥z|A=a]=P[f(x)≥z]。

BGL(Bounded group lost):如果對(duì)于每個(gè)受保護(hù)的屬性 A 來說,預(yù)測(cè)損失都低于某一預(yù)先確定的值,這個(gè)函數(shù) f 滿足于 BGL。以語音或人臉識(shí)別任務(wù)為例,這一公平性要求表示所有的組別都能獲得較好的識(shí)別效果。當(dāng) E[l(Y,f(X))|A=a]≤ζ,我們得到預(yù)測(cè)水平為ζ的預(yù)測(cè)函數(shù) f。

公平回歸(Fair Regression)

公平回歸的過程就是在滿足 SP 或 BGL 的前提下最小化損失函數(shù) E[l(Y),f(X)]。我們需要在該前提的約束下進(jìn)行優(yōu)化。

SP:本文設(shè)置一個(gè)可調(diào)值用于控制公平性的準(zhǔn)確度,例如針對(duì)每個(gè)屬性的松弛參數(shù)ε_(tái)a,此時(shí)公平回歸任務(wù)為:

(1)

BGL:針對(duì)每個(gè)屬性,設(shè)定一個(gè)約束參數(shù)ζ_a,此時(shí)公平回歸問題為:

(2)

與第一篇論文提到的公平分類相似,為了實(shí)現(xiàn)更好的公平性-準(zhǔn)確性權(quán)衡,這篇論文的作者在公平回歸問題中引入一個(gè)隨機(jī)預(yù)測(cè)因子(Randomized predictors):首先根據(jù)分布 Q 選取 f,然后基于 f 進(jìn)行預(yù)測(cè)。基于公式(1)和(2)給出下述符號(hào):

由此得到 SP 的目標(biāo)函數(shù):

(3)

以及 BGL 的目標(biāo)函數(shù):

(4)

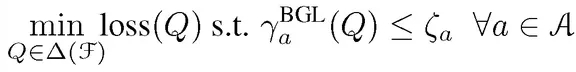

監(jiān)督學(xué)習(xí)示例

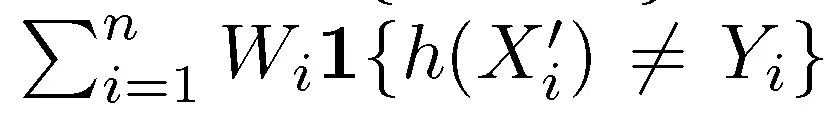

本文作者展示了如何將公平回歸問題轉(zhuǎn)化為三個(gè)標(biāo)準(zhǔn)的學(xué)習(xí)問題:加權(quán)最小二乘回歸、在不公平約束下的加權(quán)風(fēng)險(xiǎn)最小化(無公平性約束)、成本敏感分類問題。加權(quán)最小二乘回歸的風(fēng)險(xiǎn)優(yōu)化問題:給定數(shù)據(jù)集 {(Wi,Xi,Yi)},Wi 為非負(fù)權(quán)重,f 最優(yōu)化權(quán)重經(jīng)驗(yàn)風(fēng)險(xiǎn):

在不公平約束下的加權(quán)風(fēng)險(xiǎn)最小化:使用 l 衡量準(zhǔn)確度,能夠得到針對(duì)相同類別 F 的加權(quán)最小二乘學(xué)習(xí)者。損失函數(shù)為:

成本敏感分類:給定數(shù)據(jù)集 {(X^i,,Ci)},其中 X『i,, 為特征向量,Ci 為表征成本(例如損失函數(shù))區(qū)別。正值 Ci 表示 0 為最佳,負(fù)值 Ci 則表示 1 為最佳。成本敏感分類的最終目標(biāo)為找到能夠最優(yōu)化經(jīng)驗(yàn)成本的分類器 h。給定數(shù)據(jù)集 {(Wi,X^i,Yi)},當(dāng) Yi=1{Ci≤0},以及 Wi=|Ci|,目標(biāo)函數(shù)為:

根據(jù)以上,作者就可以做出有 SP 或者 BGL 約束的公平回歸算法。

實(shí)驗(yàn)結(jié)果

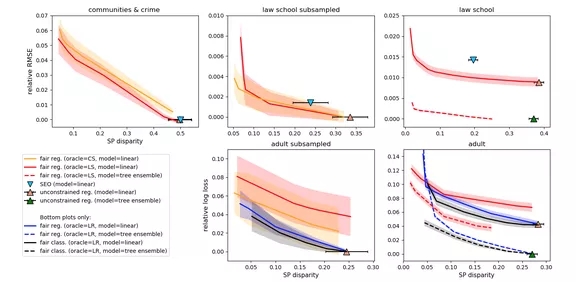

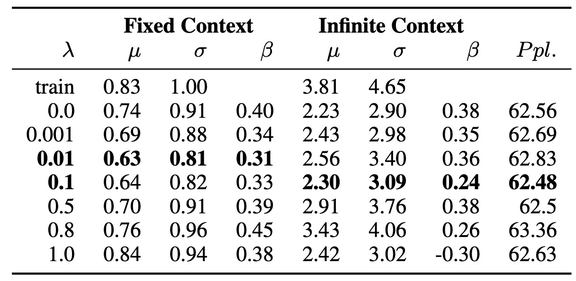

本文使用如下數(shù)據(jù)庫(kù)進(jìn)行實(shí)驗(yàn)比對(duì):成人庫(kù)(Adult)、法學(xué)院(Law School)、社區(qū)和犯罪(Communities&Crime)。由于前兩個(gè)庫(kù)較大,本文也在其子庫(kù)上進(jìn)行了實(shí)驗(yàn)。對(duì)比基線算法包括不受任何公平約束的回歸,以及來自公平分類和公平回歸領(lǐng)域的兩個(gè)基線算法。兩個(gè)基線算法具體為:在任務(wù)為最小二乘回歸的三個(gè)數(shù)據(jù)集上,本文使用完全實(shí)質(zhì)性機(jī)會(huì)均等(full Substantive Equality of Opportunity, SEO)[10] 算法作為基線;在兩個(gè)任務(wù)為 logistic 回歸的數(shù)據(jù)集上,本文運(yùn)行公平分類(Fair Classification,F(xiàn)C)[11] 算法作為基線。

圖 4 給出了 SP 約束下的相對(duì)測(cè)試損失與最壞約束沖突對(duì)比實(shí)驗(yàn)結(jié)果,該實(shí)驗(yàn)通過從實(shí)際損失中減去最小基線損失來計(jì)算相對(duì)損失。圖 4 給出了 95% 的置信區(qū)間來表示本文方法和公平分類(FC)的相對(duì)損失,也給出了 95% 的置信區(qū)間來表示約束違反(對(duì)所有方法都一樣)。除了 Adult 庫(kù)中公平分類(FC)效果更好,在其他數(shù)據(jù)庫(kù)中本文提出的方法效果都為最優(yōu)。此外,本文所提出的方法在減小差距(不公平)的同時(shí),并不會(huì)對(duì)總體損失造成嚴(yán)重影響。本文所提出的方法在全部最小二乘任務(wù)中效果都為最優(yōu),但在 logistic 回歸任務(wù)中,效果低于公平分類(FC)。

圖 4. SP 約束下的相對(duì)測(cè)試損失與最壞約束沖突對(duì)比

小結(jié)

本文所提的算法能夠有效處理一系列損失和回歸問題,同時(shí)在保持總體準(zhǔn)確度的同時(shí)減小了偏見(差異)。在本文給出的實(shí)驗(yàn)中,公平分類 (FC) 作為 logistic 回歸的一個(gè)強(qiáng)大基線算法展現(xiàn)出了良好的性能,在一些實(shí)驗(yàn)條件下效果甚至優(yōu)于本文提出的算法。這表明本文所提出的基于回歸的歸約啟發(fā)式方法還存在一些缺陷,這也為以后的研究留下了改進(jìn)空間。

3、Identifying and Reducing Gender Bias in Word-Level Language Models

https://arxiv.org/pdf/1904.03035.pdf

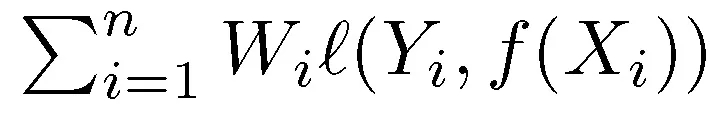

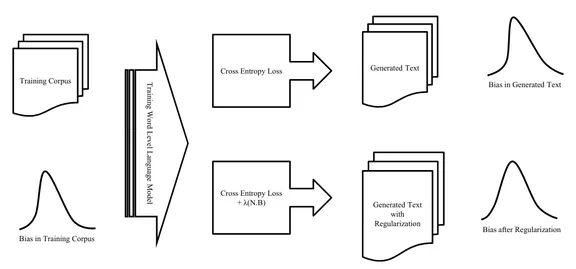

語言建模(Language Model)是一項(xiàng)非常容易受到性別偏見(Gender Bias)影響的自然語言處理任務(wù),同時(shí)也非常具有實(shí)際應(yīng)用價(jià)值,例如屏幕鍵盤中的單詞預(yù)測(cè)。本文的研究目的是識(shí)別用于語言建模的訓(xùn)練數(shù)據(jù)集中的性別偏見,以及減少其對(duì)模型行為的影響。具體來講,本文的工作是評(píng)估性別偏見對(duì)于在文本語料庫(kù)中訓(xùn)練的單詞級(jí)別的語言模型的性能影響。

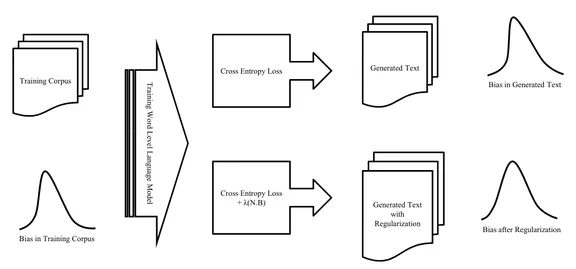

本文首先通過對(duì)訓(xùn)練得到的嵌入特征和共現(xiàn)模式進(jìn)行定性和定量分析,從而檢查數(shù)據(jù)集中存在的偏見。然后,在數(shù)據(jù)集上訓(xùn)練 LSTM 單詞級(jí)別的語言模型,并測(cè)量生成輸出的偏見(如圖 5 所示)。第三,應(yīng)用一個(gè)正則化過程,目的是使得模型學(xué)習(xí)到的嵌入特征最小程度依賴于性別,同時(shí)進(jìn)行獨(dú)立的對(duì)輸入和輸出嵌入特征的去偏處理。

圖 5. 三層 LSTM 模型

分析用于建立最新語言模型的公開數(shù)據(jù)集所顯示的性別偏見

本文選擇了三個(gè)公開數(shù)據(jù)集進(jìn)行驗(yàn)證,包括:Penn Treebank (PTB)、WikiText-2 和 CNN/Daily Mail。PTB 由科學(xué)摘要、計(jì)算機(jī)手冊(cè)、新聞文章等不同類型的文章組成,其中男性單詞的計(jì)數(shù)高于女性單詞。WikiText-2 由維基百科的文章組成,它比 PTB 更加多樣化,因此男女性別詞的比例更加平衡。CNN/Daily Mail 是從體育、健康、商業(yè)、生活方式、旅游等主題的各種新聞文章中整理出來的。這個(gè)數(shù)據(jù)集的男女性別比例更加平衡,相較于前兩個(gè)數(shù)據(jù)集來說,存在的性別偏見最小。

本文使用包含 1150 個(gè)隱藏單元的三層 LSTM 單詞級(jí)語言模型 (AWD-LSTM) 測(cè)量生成輸出的偏見程度[3],使用復(fù)雜度(Perplexity)作為衡量標(biāo)準(zhǔn)。在對(duì)三個(gè)公開數(shù)據(jù)集的驗(yàn)證過程中都得到了合理的復(fù)雜度,分別為 PTB 62.56、Wikitext-2 67.67、CNN/Daily Mail 118.01。

復(fù)雜度(Perplexity)是一種常用的語言模型評(píng)價(jià)標(biāo)準(zhǔn),可以理解為,如果每個(gè)時(shí)間步長(zhǎng)內(nèi)都根據(jù)語言模型計(jì)算的概率分布隨機(jī)挑詞,那么平均情況下,挑多少個(gè)詞才能挑到正確的那個(gè)。即復(fù)雜度(Perplexity)刻畫的是語言模型預(yù)測(cè)一個(gè)語言樣本的能力,通過語言模型得到一條語言樣本的概率越高,語言模型對(duì)數(shù)據(jù)集的擬合程度越好,建模效果越好。

分析性別偏見對(duì)基于遞歸神經(jīng)網(wǎng)絡(luò) (RNNs) 的單詞級(jí)語言模型的影響

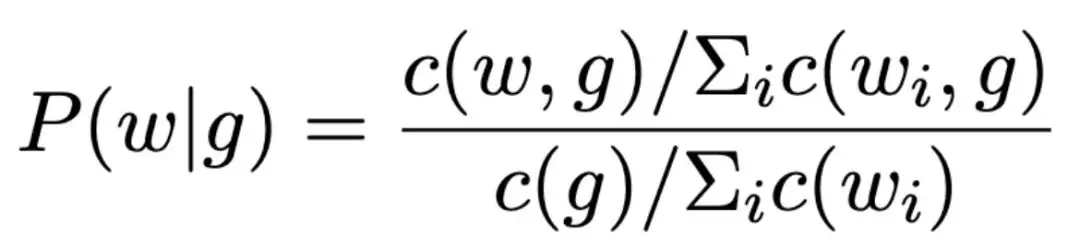

使用能夠表征性別的單詞來表示一個(gè)單詞在上下文中出現(xiàn)的概率:

其中 c(w,g) 是上下文窗口,g 是一組性別詞匯,例如,當(dāng) g=f,這樣的詞包括 he,her,woman 等,w 是語料庫(kù)中的任何單詞,不包括停止詞匯和性別相關(guān)詞匯。關(guān)于 c(w,g) 的選擇,本文采用了固定長(zhǎng)度和權(quán)重以指數(shù)方式遞減(0.95)的有限長(zhǎng)度窗口大小兩種方式進(jìn)行實(shí)驗(yàn)。

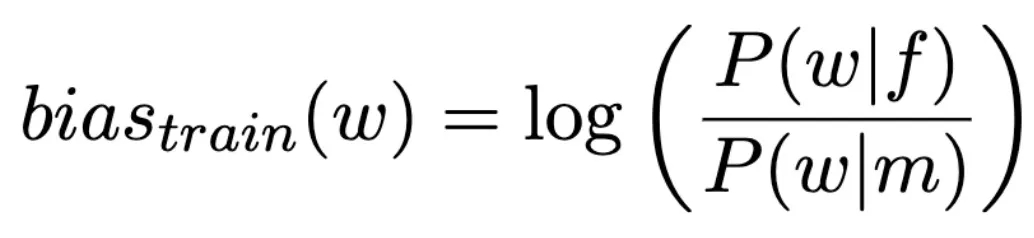

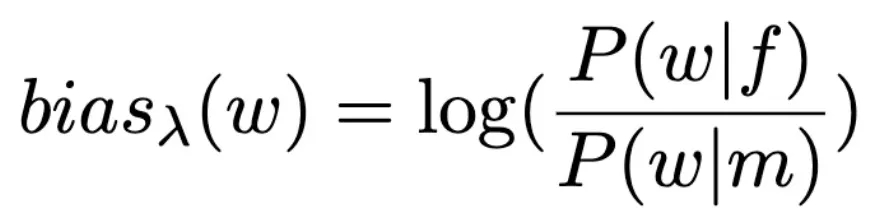

定義特定詞的偏見分?jǐn)?shù)為:

要對(duì)從訓(xùn)練語料庫(kù)和語言模型生成的文本語料庫(kù)中采樣得到的文本中的每個(gè)單詞測(cè)量這個(gè)偏見分?jǐn)?shù),其中,正偏分?jǐn)?shù)意味著該詞與女性詞匯的搭配頻率高于與男性詞匯的搭配頻率。在假設(shè)無限的語境中,偏見分?jǐn)?shù)應(yīng)當(dāng)接近于 0,例如,「doctor」和「nurse」在對(duì)話過程中與男性和女性單詞搭配出現(xiàn)的頻率應(yīng)當(dāng)一樣多。

為了評(píng)估每個(gè)模型的去偏性,測(cè)量生成的語料庫(kù)的偏見分?jǐn)?shù)計(jì)算如下:

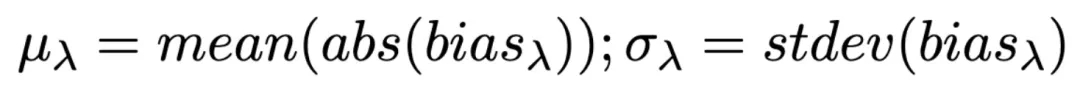

此外,為了估計(jì)偏見放大或縮小的改變程度,本文擬合了一個(gè)單變量線性回歸模型,該模型對(duì)上下文單詞的偏見評(píng)分如下:

其中,β為與訓(xùn)練數(shù)據(jù)集相關(guān)的比例放大測(cè)量值,減小β意味著對(duì)模型去偏,c 為上文定義的 context。本文利用評(píng)估語料庫(kù)中每個(gè)上下文單詞的絕對(duì)平均值μ和標(biāo)準(zhǔn)偏差σ來量化偏見的分布:

最終,取絕對(duì)偏見分?jǐn)?shù)的平均值作為評(píng)估依據(jù)。

減少在這些模型中獲得的偏見的方法

前期的研究表明,機(jī)器學(xué)習(xí)技術(shù)通過捕捉數(shù)據(jù)模式來做出連貫的預(yù)測(cè),可能能夠捕獲甚至放大數(shù)據(jù)中的偏見 [4]。本文分別對(duì)輸入嵌入、輸出嵌入和同時(shí)兩種嵌入這三種情況進(jìn)行了去偏處理。本文使用的方法為:使用 [5] 中的方法從學(xué)習(xí)到的輸出嵌入中提取一個(gè)性別子空間。然后,根據(jù) [6] 中的方法在單詞級(jí)別(word level)的語言模型上訓(xùn)練這些嵌入,而不是使用無偏預(yù)訓(xùn)練的嵌入 [6]。

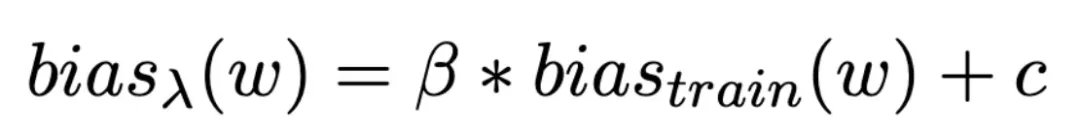

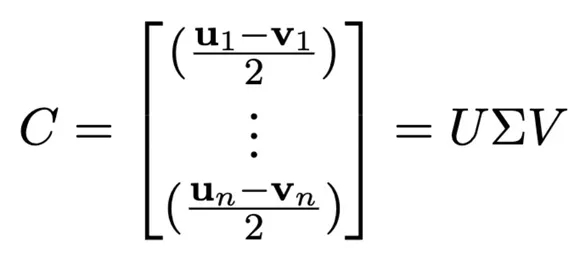

使用 w∈Sw 表示單詞嵌入,Di,...,Dn?Sw 表示定義集,包括性別詞匯對(duì),例如男人和女人。定義集是為每個(gè)語料庫(kù)單獨(dú)設(shè)計(jì)的,因?yàn)槟承┰~并不會(huì)出現(xiàn)在所有語料庫(kù)中。對(duì)于一個(gè)訓(xùn)練語料庫(kù),同時(shí)出現(xiàn)的與性別相關(guān)的相反的詞匯,則將它們認(rèn)定為一個(gè)定義集,{ui,vi}=Di。矩陣 C 是定義集中詞匯對(duì)之間的差異向量的集合,詞匯對(duì)的差異情況表征了性別信息。對(duì) C 進(jìn)行奇異值分解處理:

將 V 的前 k 列定義為性別子空間 B=V_1:k。矩陣 N 由無偏嵌入組成。如果想讓嵌入的偏見最小,那么將其映射到 B 中時(shí),令其 Frobenius 范數(shù)的平方值也是最小。為了減少模型中嵌入層學(xué)習(xí)到的偏見,在訓(xùn)練損失中加入以下正則化項(xiàng):

其中,λ控制最小化嵌入矩陣 W(N 和 B 推導(dǎo)得到的矩陣)的權(quán)重,N 和 C 在模型訓(xùn)練期間迭代更新。

在語言模型中隨機(jī)輸入 2000 個(gè)種子作為開始生成單詞的起點(diǎn)。使用前面的單詞作為語言模型的輸入,并執(zhí)行多項(xiàng)選擇以生成下一個(gè)單詞,重復(fù)該步驟 500 次,最終得到三個(gè)數(shù)據(jù)集對(duì)應(yīng)每個(gè)λ的 10^6 個(gè) token。

結(jié)果分析

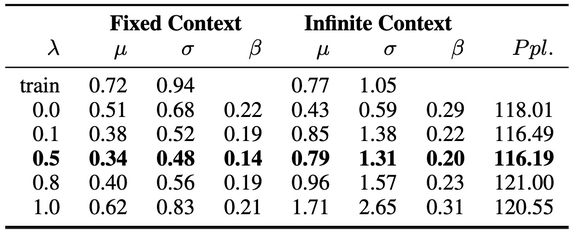

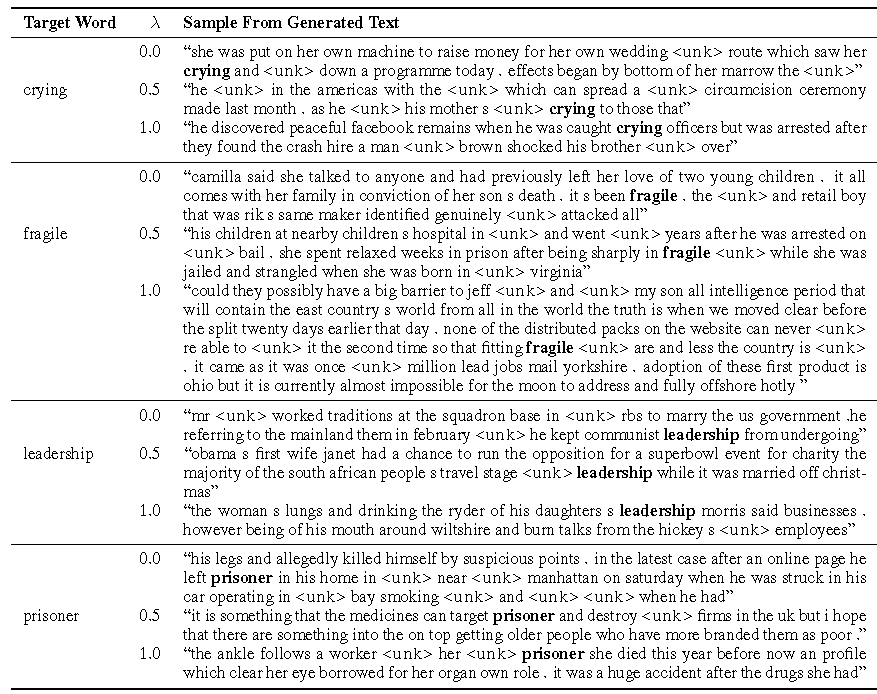

本文使用 RNN 進(jìn)行模型訓(xùn)練。結(jié)果見表 4。數(shù)據(jù)集的整體偏見可由μ表征,較大的μ表示語料庫(kù)存在較大的性別偏見。由表 4 中的實(shí)驗(yàn)結(jié)果可知,隨著λ值增大,μ逐漸減小直至穩(wěn)定,因此λ的優(yōu)化存在一個(gè)區(qū)間。本文還對(duì)單個(gè)單詞的偏差分?jǐn)?shù)進(jìn)行了對(duì)比以評(píng)估去偏的效果。β的傾斜程度表示了模型相對(duì)于訓(xùn)練語料庫(kù)的放大或減弱效果,β值的大幅下降表示減弱偏差,反之亦然。β的負(fù)值則假定損失項(xiàng)沒有產(chǎn)生其它影響。本文給出的實(shí)驗(yàn)結(jié)果中,λ較大時(shí)β也會(huì)增大,作者認(rèn)為這可能是因?yàn)槟P筒环€(wěn)定所造成的。此外,對(duì)于去偏處理參數(shù)μ和σ的影響很小,作者認(rèn)為它們無法捕獲單次級(jí)別的改進(jìn)。基于上述實(shí)驗(yàn)結(jié)果,作者推薦使用單詞級(jí)別的評(píng)估項(xiàng),例如β,來評(píng)估語料庫(kù)級(jí)別的去偏處理效果的魯棒性。

表 4. PTB、WikiText-2、CNN/Daily Mail 中的實(shí)驗(yàn)結(jié)果

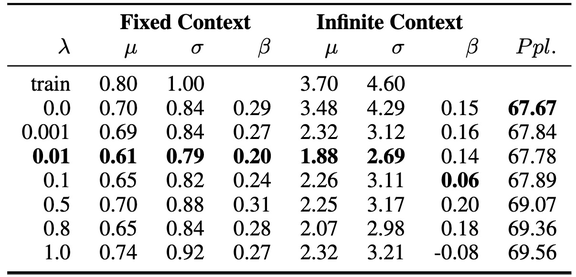

表 5 為從 CNN/Daily Mail 的生成語料中選擇的目標(biāo)詞匯。特別強(qiáng)調(diào)與女性相關(guān)的詞 crying 和 fragile,而一般認(rèn)為與男性相關(guān)的詞匯 Leadership 和 prisoners。當(dāng)λ=0 時(shí),這些偏見非常明顯。對(duì)于 fragile,當(dāng)λ=1.0 時(shí),生成文本中幾乎沒有對(duì)女性的詞匯提及,從而得到大量的中立文本。對(duì)于 prisoners,λ=0.5 時(shí)情況也類似。

表 5. 不同λ值時(shí) CNN/Daily Mail 中的生成文本比較

小結(jié)

本文使用了兩個(gè)不同的指標(biāo)量化語料級(jí)別的性別偏見:絕對(duì)平均值μ和標(biāo)準(zhǔn)偏差σ。此外,提出了一個(gè)用于評(píng)估去偏效果的相關(guān)矩陣β,作者通過對(duì)訓(xùn)練語料庫(kù)生成的文本語料庫(kù)中的單詞級(jí)別的性別偏見進(jìn)行回歸分析來計(jì)算β。

本文提出的方法可以處理語言模型中單詞級(jí)別的詞分布問題。該方法的目標(biāo)是測(cè)量性別偏差,但并不能檢測(cè)在去偏模型和數(shù)據(jù)中仍然存在的顯著的偏見。此外,作者也提出,本文的方法在傳統(tǒng)的語言模型中增加了一個(gè)去偏正則化項(xiàng),這可能會(huì)帶來復(fù)雜度與偏見處理權(quán)衡的問題,例如,在一個(gè)無偏的模型中,男性和女性的語言被預(yù)測(cè)的概率幾乎相等,減小性別偏見會(huì)導(dǎo)致語言模型的復(fù)雜度增高。

4、本文總結(jié)

隨著經(jīng)合組織的《經(jīng)合組織人工智能原則》、歐盟《人工智能倫理指南》和《人工智能政策與投資建議》、20 國(guó)集團(tuán)《人工智能原則》以及《北京人工智能原則》等一系列文件的發(fā)布,人工智能治理成為了 2020 年廣泛關(guān)注的議題,本文所探討的「機(jī)器學(xué)習(xí)中的公平公正」,就是人工智能治理中最關(guān)鍵的問題。

本文對(duì)機(jī)器學(xué)習(xí)中的公平公正問題進(jìn)行了簡(jiǎn)要回顧,包括數(shù)據(jù)偏見和算法偏見兩類。在此基礎(chǔ)上,本文結(jié)合 ICML 2019 中的三篇文章,針對(duì)算法偏見分別對(duì)機(jī)器學(xué)習(xí)領(lǐng)域中的圖嵌入問題、回歸問題,以及自然語言處理領(lǐng)域中的語言模型問題進(jìn)行了詳細(xì)分析。目前,關(guān)于算法去偏的處理還停留在理論分析和實(shí)驗(yàn)的階段,主要通過引入不同的損失函數(shù)、約束矩陣等約束項(xiàng)弱化模型結(jié)果中的偏見,包括第一篇文章中的對(duì)抗損失函數(shù)、第二篇文章中的統(tǒng)計(jì)奇偶性和有界群體損失函數(shù),以及第三篇文章中的去偏正則化項(xiàng)等。算法優(yōu)化的最終目的是希望加入這些約束項(xiàng)去除偏見的同時(shí),不會(huì)嚴(yán)重影響原有機(jī)器學(xué)習(xí)模型的主要任務(wù)性能。

由本文的分析可知,通過使用去偏算法或模型,能夠在一定的實(shí)驗(yàn)環(huán)境下去除偏見,但并不能保證對(duì)所有數(shù)據(jù)有效。此外,本文(包括現(xiàn)在已經(jīng)發(fā)表的其他文獻(xiàn))探討的去偏主要還是集中于性別偏見、種族偏見這一類常見的、容易區(qū)分的偏見屬性,對(duì)于真實(shí)應(yīng)用場(chǎng)景下的復(fù)雜去偏問題,研究之路還很漫長(zhǎng),需要更多的挖掘與探索。