摘 要: 基于對(duì)無(wú)標(biāo)記數(shù)據(jù)算法的研究,討論了基因數(shù)據(jù)分析的半監(jiān)督學(xué)習(xí)算法。基因數(shù)據(jù)的典型特征是小樣本、高維數(shù),處理起來(lái)非常困難。在安全的半監(jiān)督學(xué)習(xí)基礎(chǔ)上,提出了一種降維和半監(jiān)督學(xué)習(xí)相結(jié)合的方法,以提高分類(lèi)效果的精確度及魯棒性。實(shí)驗(yàn)證明,該方法通過(guò)結(jié)合降維和半監(jiān)督學(xué)習(xí)的優(yōu)點(diǎn),具有很好的應(yīng)用價(jià)值。

關(guān)鍵詞: 半監(jiān)督學(xué)習(xí);基因表達(dá)數(shù)據(jù);特征提取;支持向量機(jī)

基因芯片技術(shù)可以一次性對(duì)大量基因序列進(jìn)行檢測(cè)和分析,從而得到高維的基因表達(dá)數(shù)據(jù),因此在病理研究和臨床應(yīng)用等領(lǐng)域備受關(guān)注[1-2]。基因表達(dá)數(shù)據(jù)中基因的數(shù)目巨大,大部分都無(wú)法為樣本的區(qū)分提供有用信息,因此識(shí)別出一小部分能提供足夠有用信息的基因并實(shí)現(xiàn)很好的分類(lèi)至關(guān)重要,這一小部分有效基因被稱(chēng)為分類(lèi)特征基因。特征基因選擇通常由去除分類(lèi)無(wú)關(guān)基因和去除冗余基因兩部分組成。GOLUB T R等人提出的特征記分準(zhǔn)則FSC(Feature Score Criterion)用于去除分類(lèi)無(wú)關(guān)基因[3]。李穎新等人[4]認(rèn)為應(yīng)該在此基礎(chǔ)上考慮方差對(duì)樣本分類(lèi)的影響,利用方差不同對(duì)樣本分類(lèi)的貢獻(xiàn)不同,從而更客觀地評(píng)價(jià)基因包含的分類(lèi)信息量,提出了修訂的特征記分準(zhǔn)則RFSC(Revised Feature Score Criterion)。關(guān)于特征基因的選擇研究有過(guò)濾法、纏繞法、混合方法等[5-6]。特征基因選擇之后,選出的剩余基因可以看作與疾病相關(guān)。因?yàn)槔没驍?shù)據(jù)的高維數(shù)和高噪音進(jìn)行特征提取是必要的途徑。本文結(jié)合降維技術(shù)方法給出新的特征提取方法。提取特征后,樣本的分類(lèi)又顯得尤為重要,一個(gè)好的分類(lèi)器能夠更準(zhǔn)確、更有效地區(qū)分正常樣本,從而為臨床醫(yī)學(xué)提供參照。半監(jiān)督學(xué)習(xí)(Semi-supervised Learning)是目前比較有效的分類(lèi)方法[7],它主要考慮如何利用少量的標(biāo)注樣本和大量的未標(biāo)注樣本進(jìn)行訓(xùn)練和分類(lèi)的問(wèn)題。本文提出的降維和半監(jiān)督學(xué)習(xí)方法能夠更好地利用數(shù)據(jù)的隱含信息,更好地實(shí)現(xiàn)分類(lèi)預(yù)測(cè)效果。

1 數(shù)據(jù)描述及標(biāo)準(zhǔn)化

1.1 基因表達(dá)數(shù)據(jù)

基因表達(dá)譜數(shù)據(jù)可以表述為:

M=x11 x12 … x1n c1x21 x22 … x2n c2 ?塤xm1 xm2 … xmn cm (1)

腫瘤基因表達(dá)譜M中共有m個(gè)樣本、n個(gè)基因。xij代表第i個(gè)樣本的第j個(gè)基因表達(dá)值; ci代表樣本所屬類(lèi)別。gi為第i個(gè)基因所有樣本的表達(dá)值,簡(jiǎn)稱(chēng)為基因gi:

gi=x1ix2ixmi (2)

基因表達(dá)譜最顯著特點(diǎn)是樣本少、維數(shù)高,即m<<n[2]。

1.2 基因表達(dá)數(shù)據(jù)標(biāo)準(zhǔn)化

對(duì)基因表達(dá)數(shù)據(jù)進(jìn)行標(biāo)準(zhǔn)化的方法主要有兩種:(1) 限制每個(gè)基因的均值為0,方差為1;(2)限制每個(gè)基因的值在[0,1]范圍內(nèi)。

本文采用限制每個(gè)基因的值在[0,1]范圍內(nèi)的標(biāo)準(zhǔn)化方法:

xij*=(xij-xj-max-xj-min)

其中,xij為式(1)中所示的基因表達(dá)矩陣M中第i個(gè)樣本的第j個(gè)基因,xj-max為第j列基因的最大值,xj-min為第j列基因的最小值,xij*為標(biāo)準(zhǔn)化后的新值。

2 數(shù)據(jù)處理的相關(guān)理論方法

2.1 IRFSC特征計(jì)分準(zhǔn)則

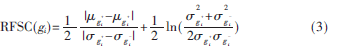

由于相關(guān)組織的某些基因發(fā)生了突變,而突變基因的表達(dá)水平與正常基因的表達(dá)水平不一樣,因此,需要找出突變基因。原則是:將患病和正常樣本兩類(lèi)中具有顯著差異的基因子集保留,其余視為無(wú)關(guān)基因去除。通常是按照某種記分準(zhǔn)則對(duì)每一個(gè)基因進(jìn)行記分[6],分值越大說(shuō)明該基因的正常樣本和腫瘤樣本差異越大、基因含有的分類(lèi)信息就越多。因此按基因分值大小降序排列,排在前面一定數(shù)量的基因作為候選基因,其余基因作為無(wú)關(guān)基因去除。參考文獻(xiàn)[5]中對(duì)GOLUB T R等人提出的FSC進(jìn)行改進(jìn)后為:

若基因表達(dá)譜中只有正常樣本和腫瘤樣本兩類(lèi),則表示基因gi中正常樣本的均值,表示gi中腫瘤樣本的均值;表示gi中正常樣本的標(biāo)準(zhǔn)差,表示gi中腫瘤樣本的標(biāo)準(zhǔn)差。考慮到樣本數(shù)目m和基因數(shù)目n之間的大小關(guān)系m<<n[2],由于n/m的比值越大,對(duì)方差的影響也越大,給出式(3)的改進(jìn)形式:

2.2 降維方法

2.2.1 主成分分析

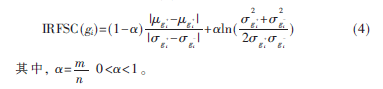

主成分分析PCA(Principal Component Analysis)算法是一個(gè)經(jīng)典的統(tǒng)計(jì)技術(shù),把數(shù)據(jù)從高維的空間中映射到低維的空間并保留主要的信息[8]。在新的坐標(biāo)系下,變換數(shù)據(jù)點(diǎn)的方差沿新的坐標(biāo)軸得到了最大化,這些坐標(biāo)軸經(jīng)常被稱(chēng)為主成分。PCA的主要運(yùn)算步驟如下:

2.2.2 局部保持投影

局部保持投影LPP(Locality Preserving Projection)是一種線形的降維算法[9]。LPP的目的是保持局部的結(jié)構(gòu)信息,所以在低維空間的近鄰搜索與高維空間產(chǎn)生類(lèi)似的結(jié)果。LPP是線性的,這使得LPP處理速度很快,并且很適合于實(shí)際的應(yīng)用,這也是LPP優(yōu)于LLE的地方。降維后產(chǎn)生的變換矩陣可以直接應(yīng)用在測(cè)試集上,所以,其擁有樣本外點(diǎn)學(xué)習(xí)能力。

LPP的算法如下:

(1)PCA投影。通過(guò)保留主要成分,將數(shù)據(jù)集投影到子空間。

(2)構(gòu)建鄰近圖。如果樣本點(diǎn)Xi和樣本點(diǎn)Xj是近鄰點(diǎn),則可以在Xi和Xj之間建立一條邊。建立的近鄰圖是局部流形結(jié)構(gòu)的近似,常采用K近鄰方法。

(3)如果樣本點(diǎn)i和j相連,則設(shè)置權(quán)重W=e,其中t是一個(gè)合適的常數(shù);否則W=0。

其中,L=D-W,而對(duì)角矩陣D的對(duì)角線元素Dii=Wij。

(4)本征映射。計(jì)算特征值分解問(wèn)題:XLXT?琢=?姿XXT?琢求解廣義特征方程的d個(gè)最小特征值對(duì)應(yīng)的特征向量作為d個(gè)投影向量。故由上述特征方程的d個(gè)最小特征值?姿1,?姿2,…,?姿d對(duì)應(yīng)特征向量?琢1,?琢2,…,?琢d,構(gòu)成保持近鄰重建特性的線性變換矩陣。

2.3 支持向量機(jī)

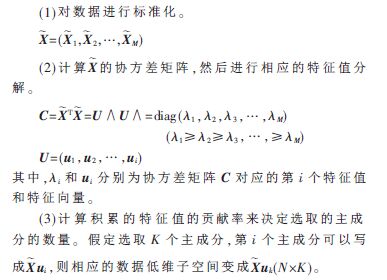

支持向量機(jī)SVM(Support Vector Machines)是由VAPNIK提出的一種新的機(jī)器學(xué)習(xí)方法[10],它基于VC維和結(jié)構(gòu)風(fēng)險(xiǎn)最小化理論 (SRM),在很大程度上解決了傳統(tǒng)機(jī)器學(xué)習(xí)中的維數(shù)災(zāi)難及局部極小等問(wèn)題。由于其完整的理論框架和在實(shí)際應(yīng)用中取得了很多好的效果,在機(jī)器學(xué)習(xí)領(lǐng)域受到了廣泛的重視,圖1給出了SVM分類(lèi)的示意圖。

當(dāng)給定的訓(xùn)練樣本集為{xi,yi},其中i=1,…,N,相應(yīng)的類(lèi)標(biāo)簽為yi={-1,+1}。在線性可分的情況下,SVM 能找到一個(gè)能使兩類(lèi)樣本集分類(lèi)間隔最大的最優(yōu)超平面。這等價(jià)于解決下面的規(guī)劃問(wèn)題:

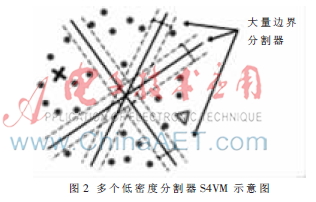

由于支持向量機(jī)是利用有效的少量樣本去構(gòu)建超平面來(lái)預(yù)測(cè)測(cè)試樣本,支持向量的選擇對(duì)分類(lèi)器的精度影響很大。對(duì)大量的數(shù)據(jù)樣本進(jìn)行處理,分類(lèi)器的精度變化不會(huì)很大;但是對(duì)于少量的樣本進(jìn)行處理,分類(lèi)器精度的變化會(huì)非常明顯,尤其是遇到高維小樣本問(wèn)題。分類(lèi)器的精度如果變化很大,就在實(shí)際應(yīng)用中就會(huì)帶來(lái)意想不到的后果。鑒于基因數(shù)據(jù)的特點(diǎn)(高維數(shù)和高噪音),把最新的支持向量機(jī)S4VM應(yīng)用到本文的算法中。S4VM是對(duì)S3VM的改進(jìn),后者主要關(guān)注一個(gè)最優(yōu)的低密度分界線,而S4VM同時(shí)關(guān)注多個(gè)可能的低密度分界線。因?yàn)榻o定一些有標(biāo)記的點(diǎn)和大量為標(biāo)記的點(diǎn),可能存在不止一個(gè)低密度分界線,所以很難決定哪個(gè)是最好的,如圖2所示。雖然這些低密度分界線都與有限的標(biāo)記樣本吻合,但它們之間的差異很大,因此如果選錯(cuò)了,會(huì)有一個(gè)很大的損失,導(dǎo)致性能的下降。所以,S4VM試圖考慮所有可能的低密度分界線。在給定許多不同“間隔”較大的分界線時(shí),通過(guò)對(duì)未標(biāo)記的樣本的類(lèi)別劃分進(jìn)行優(yōu)化,使得在最壞的情況下,相對(duì)于只使用標(biāo)記樣本的支持向量機(jī)的性能提升最大化。

3 算法流程

本文提出算法的具體流程如下。

(1)對(duì)腫瘤基因表達(dá)譜進(jìn)行標(biāo)準(zhǔn)化。

(2)去除無(wú)關(guān)基因。利用RFSC計(jì)算每個(gè)基因的分值,

經(jīng)過(guò)降序排列后選出分值靠前的一部分基因作為候選基因。

(3)特征提取。利用局部保持投影提取主要的特征。

(4)分類(lèi)測(cè)試。利用S4VM進(jìn)行分類(lèi)精確度的檢驗(yàn)。

4 實(shí)驗(yàn)結(jié)果及討論

采用腫瘤基因表達(dá)數(shù)據(jù)集(http://home.ccr.cancer.gov/ oncology/oncogenomics/)進(jìn)行實(shí)驗(yàn)測(cè)試,該表達(dá)譜共27個(gè)樣本(其中16個(gè)為正常樣本,11個(gè)為腫瘤樣本),3 467個(gè)基因。然后,采用ALON等人[11]選出的含有2 000個(gè)特征基因的結(jié)腸癌基因表達(dá)譜數(shù)據(jù)集,包括40個(gè)結(jié)腸癌組織樣本和22個(gè)正常樣本進(jìn)行降維實(shí)驗(yàn)對(duì)比。

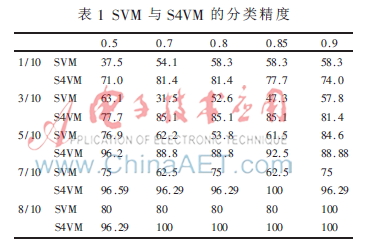

實(shí)驗(yàn)1 選取數(shù)據(jù)集中的27個(gè)樣本,采用SVM和S4VM進(jìn)行分類(lèi)精度檢驗(yàn),分別選取分類(lèi)信息指數(shù)為0.5、0.7、0.8、0.85、0.9的2 085、819、417、279和184個(gè)基因。SVM選取1/10、3/10、5/10、7/10、8/10作為訓(xùn)練集;S4VM選取1/10、3/10、5/10、7/10、8/10作為有標(biāo)號(hào)的數(shù)據(jù)。實(shí)驗(yàn)對(duì)比結(jié)果如表1所示。

在此實(shí)驗(yàn)中,訓(xùn)練集的樣本數(shù)越多,分類(lèi)效果越好;對(duì)于S4VM,有標(biāo)記的樣本數(shù)越多,其精確度越高,而且可以看出S4VM不會(huì)出現(xiàn)太大的精度變化,而SVM精度變化很大,說(shuō)明S4VM的魯棒性效果非常好。

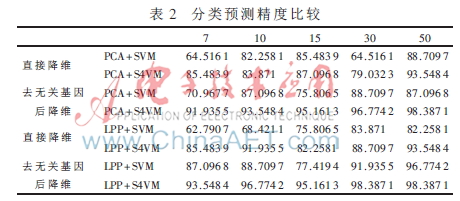

實(shí)驗(yàn)2 進(jìn)行去無(wú)關(guān)基因和直接降維的對(duì)比。采用了PCA+SVM、PCA+S4VM、LPP+SVM及LPP+S4VM進(jìn)行了對(duì)比實(shí)驗(yàn);選擇315個(gè)特征基因分別降到7、10、15、30、和50維。采用SVM分類(lèi)器時(shí)作為訓(xùn)練集,在用S4VM時(shí)采用62個(gè)樣本中的3/10約 19個(gè)作為標(biāo)記的數(shù)據(jù)。實(shí)驗(yàn)對(duì)比結(jié)果如表2所示。可以得出,無(wú)關(guān)基因作為樣本中無(wú)關(guān)的屬性,其存在對(duì)分類(lèi)器模型的選取影響很大;LPP由于很好地保持了局部結(jié)構(gòu),其降維效果明顯要比PCA好;S4VM由于考慮了多個(gè)低密度分割器,并且充分利用了無(wú)標(biāo)記的數(shù)據(jù),使其對(duì)分類(lèi)器的訓(xùn)練有更好的貢獻(xiàn),其魯棒性及精度要比直接使用標(biāo)記數(shù)據(jù)的SVM分類(lèi)效果更明顯。

基因數(shù)據(jù)的主要特點(diǎn)是高維數(shù)和高噪音。本文基于挖掘數(shù)據(jù)本質(zhì)特征的思路,采用降維和安全的機(jī)器學(xué)習(xí)技術(shù)提出一種基因數(shù)據(jù)分析的半監(jiān)督學(xué)習(xí)算法。通過(guò)實(shí)驗(yàn)證明了算法中應(yīng)用降維的有效作用,同時(shí)也顯示出應(yīng)用S4VM作為學(xué)習(xí)機(jī)的潛力,為該方面更深入的研究提供了重要理論和方法基礎(chǔ)。

參考文獻(xiàn)

[1] HOUBIN B, CHUNG R. Gene expression data classificationand Bioengineering(BIBE), IEEE 11th Inter-national Conference, 2011:66-71.

[2] YEUNG K Y, RUZZO W L. Principal component analysis for clustering gene expression data[J]. Bioinformatics, 2011,7(9):763-774.

[3] GOLUB T R, SLONIM D K, TAMAYO P, et al. Molecularclassification of cancer: class discovery and class predic-tion by gene expression monitoring[J]. Science, 1999(286):531-537.

[4] 李穎新,李建更,阮曉剛.腫瘤基因表達(dá)譜分類(lèi)特征基因選取問(wèn)題及分析方法研究[J].計(jì)算機(jī)學(xué)報(bào),2006,29(2):324-330.

[5] 于化龍,顧國(guó)昌,趙靖,等. 基于DNA微陣列數(shù)據(jù)的癌癥分類(lèi)問(wèn)題研究進(jìn)展[J]. 計(jì)算機(jī)科學(xué),2010,37(10):16-22.

[6] 張敏,戈文航.雙聚類(lèi)的研究與進(jìn)展[J]. 微型機(jī)與應(yīng)用,2012,31(4):4-6.

[7] HUANG S C, WU T K. Robust semi-super-vised SVM on kernel partial least discriminantspace for high dimensional data mining[C]. Proceedings of Information Science and Appli-cations(ICISA), International Conference,2012:1-6.

[8] JOLLIFFE T. Principal component analysis [M].New York:Springer,1986.

[9] He Xiaofei,NIYOGI P.Locality preserving pro-jections[C]. Proceedings of Advances In Neural Information Processing Systems 16, MA: Cambridge, MIT Press, 2004:153-160.

[10] Li Yufeng, Zhou Zhihua. Towards making unlabeled data never hurt[C]. In: Proceedings of the 28th International Conference on Machine Learning(ICML’11), Bellevue, WA, 2011:1081-1088.

[11] ALON U, BARKAL N, NOTTERMAN D A, et al. Broad patterns of gene expression revealed by clustering analysisof tumorand normal colon tissues by oligonucleotide arr-ays[J]. Proceedings of the National Academy of Science, 1999,96(12):6745-6750.